Jetson百万开发者故事 | 为了孩子的健康成长,他用NVIDIA Jetson做了一个象棋机器人

2022年年底,素为带着这个项目,参加了NVIDIA举办的Jetson Edge AI开发者大赛,荣获特别奖。

Jetson百万开发者故事 | 通过Jetson NANO展现CV实践价值

贾志刚便是其中一员,他的另外一个身份是 “OpenCV学堂” 的创办人。同时,作为CSDN博客专家以及51CTO视频学院认证讲师,贾志刚在图像特征提取匹配、识别等方面有较深入的研究,拥有10年以上图像处理项目实践经验和教学经验。

Jetson开发者破百万,快来说出你的开发故事吧

现在,NVIDIA面向所有Jetson开发者发起有奖征集活动!说出您与Jetson的故事,无论是开发创造的经典案例,还是学习构建的心得体验,都欢迎您畅所欲言。

正当时 NVIDIA Jetson Nano让智能机器人开发易如反掌

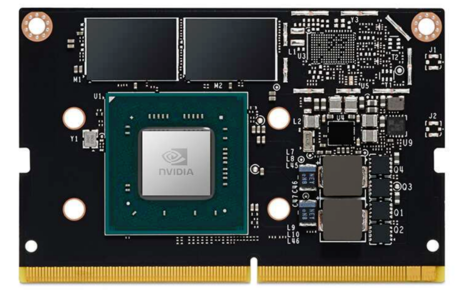

NVIDIA Jetson是面向边缘计算的人工智能平台,适用于自主机器和其他嵌入式应用程序。而NVIDIA Jetson Nano是一款面向嵌入式和边缘人工智能市场的低成本入门级人工智能计算机。

Orin开发套件04-安装DeepStream

前面安装Jetson Orin开发套件的开发环境过程,并没有将DeepStream智能分析套件安装进去,因此需要独立的安装过程,这里提供三种安装方式给使用者参考。

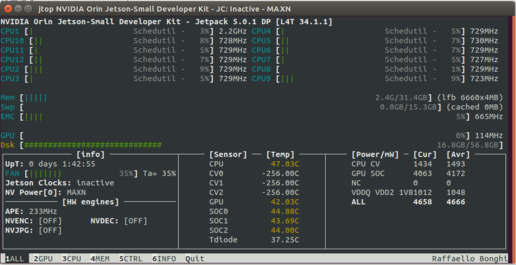

Jetson Orin开发套件03-安装开发环境

过去的AGX Xavier开发套件是需要透过headless(USB线)方式与PC进行连线,然后在PC上执行SDK Manager为Jetson设备安装开发环境,执行步骤相对繁琐。

TAO系列12-将模型部署到Jetson设备

前面我们花了很多力气在TAO上面训练模型,其最终目的就是要部署到推理设备上发挥功能。除了将模型训练过程进行非常大幅度的简化,以及整合迁移学习等功能之外,TAO还有一个非常重要的任务,就是让我们更轻松获得TensorRT加速引擎。

TAO系列06-视觉类的数据格式

前面的系列文章里提过,TAO工具将模型训练的绝大部分技术难题都进行抽象化处理,大幅度减轻开发人员的负担,唯独数据集的收集与整理仍须由人工自行处理,这几乎是留个操作人员的最后工作了。

GTC22 | Jetson开发者日来了 快来点击预约

NVIDIA Jetson开发者日是一个面向所有开发者开放的特别活动。现在免费注册,您将看到Jetson平台专家进行深入探讨,通过多场讲座展示自主机器和边缘AI的最新创新。

Jetbot系列13-图像回归法实现循路功能

前一篇从Jetson Projects所挑选的“TRANSFER LEARNING WITH JETBOT & TRAFFIC CONES”项目,是延续避撞应用使用深度学习的图像分类技术,让Jetbot实现循路的功能,这种“定速”类型的操作基本上比较偏向于“找路”或“走迷宫”的应用。

Jetbot系列11-智能避障之模型训练

Jetbot使用深度学习最基础的图像分类功能,模拟人类真实的视觉感知能力来实现避撞的应用,基本的原理在前一篇文章里已经详细说明,原厂提供的best_model.pth模型文件所采用的数据集。

Jetbot系列12-图像分类法实现找路功能

避撞功能是智能车的最基本保护能力,Jetbot使用深度学习的图像分类技术来模拟人眼习惯实现这个功能,但这只是智能车所展现的最入门应用而已,接下去就要提升到“循路”的功能,跟着指定路线去前进,才是真正进入有实用价值的应用。

Jetbot系列10-智能避撞之现场演示

避撞功能是Jetbot一开始最令人瞩目的功能,因为这是所有小车都必须具备的最基本“自我保护”的能力,而Jetbot没有任何距离传感,只凭着一个CSI摄像头就能完成这项任务,对很多人来说是一件蛮神奇的事情。

Jetbot实战系列08:组装过程的注意细节

假如您的Jetbot小车是从外面采购第三方套件的话,可以跳过本文的内容。如果您是按照jetbot.org原厂的自行组装方式,那么本文所提供的一些细节点,会让您节省很多摸索的时间。

Jetbot实战系列07:机电控制设备的安装

机电控制是智能车最重要的输出功能,假如您使用Jetbot官方的自行打印车体并用组装方式来搭建智能小车的话,就需要搭配下图这个 ”DC-Stepper-Motor” 控制板,因为3D打印车体是根据这个控制板所设计的。

Jetbot实战系列06:I2C总线与PiOLED

在“Jetbot实战系列05-Jetson的40针引脚”一文,已经将SFIO与GPIO之间的关系分析清楚,接下来就是带着大家更深入了解I2C引脚与开发库的使用,以及调整PiOLED显示内容的方法。

Jetbot实战系列05:Jetson的40针引脚

嵌入式设备有个天生赋予的重点任务,就是要成为自动控制整体方案中的一员。早期市场对自动控制的需求主要集中在单纯的“机电控制”上,而具备智能计算的Jetson系列产品相对与几十元的这类控制板来说,成本是高出一个阶位。

Jetbot实战系列03:无线WIFI的安装与调试

无线网络是操控无人车的必要设备,因为我们不可能让无人车拖着一条网路线去进行操作。要为Jetson Nano(含2GB)装上一片无线网卡是非常简单的事情,但是最复杂的问题是“设置”的细节,必须兼顾更多可能的使用场景。