Orin开发套件04-安装DeepStream

前面安装Jetson Orin开发套件的开发环境过程,并没有将DeepStream智能分析套件安装进去,因此需要独立的安装过程,这里提供三种安装方式给使用者参考。

- 使用DeepStream压缩包进行安装:

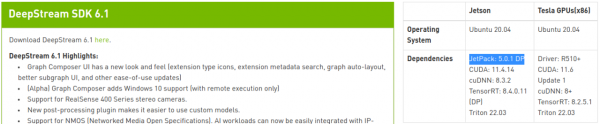

请访问https://developer.nvidia.com/deepstream-getting-started ,进入后会看到如下图的DeepStream SDK 6.1版本说明:

右表所列的是对于系统的要求,在Jetson的部分必须是JetPack 5.0.1 DP版本以上,Jetson Orin开发套件刚好符合这个要求,因此可以安装这个6.1版本的DeepStream。

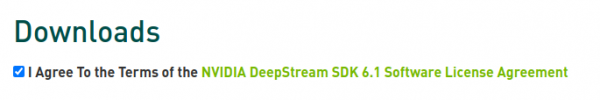

页面往下会看到如下图的“Downloads”部分:

点选左下角“I Agree To…”左边的框,就会跳出下图的选项:

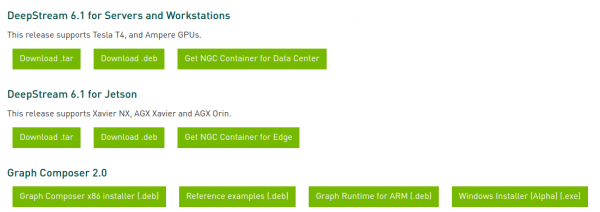

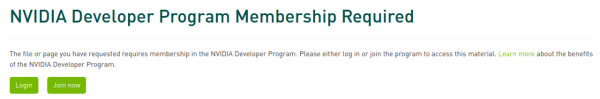

这里推荐下载“Download .tar”压缩包的方式会比较简单。点击后会弹出下面画面:

这是要求使用者必须拥有NVIDIA开发者社区账号,如果没有的话就申请一个,至于申请与登录的步骤,这里就不多赘述了。

将压缩包下载至Jetson Orin开发套件之后,请在Jetson Orin上执行以下步骤:

|

$

$ |

# 安装依赖库 sudo apt install -y libssl1.0.0 libgstreamer1.0-0 gstreamer1.0-tools gstreamer1.0-plugins-good gstreamer1.0-plugins-bad gstreamer1.0-plugins-ugly gstreamer1.0-libav libgstrtspserver-1.0-0 libjansson4=2.11-1 libgstreamer-plugins-base1.0-dev libgstreamer1.0-dev libgstrtspserver-1.0-dev libx11-dev # 重新安装nvidia-l4t的相关库 sudo apt install --reinstall -y nvidia-l4t-gstreamer nvidia-l4t-multimedia nvidia-l4t-core |

现在请到前面下载的deepstream_sdk_v6.1.0_jetson.tbz2的位置,执行以下指令开始安装DeepStream开发工具:

|

$ $ $ |

sudo tar -xvf deepstream_sdk_v6.1.0_jetson.tbz2 -C / cd /opt/nvidia/deepstream/deepstream sudo ./install.sh && sudo ldconfig |

接下来执行下面指令,检验DeepStream的安装是否成功:

|

$ |

deepstream-app --version-all |

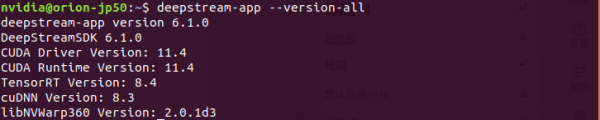

第一次执行会出现一些警告(warning)信息,再执行一次就会正常出现下图信息:

这样就表示安装完成了。

- 通过SDK Manager安装:

这种安装需要有一台装有Ubuntu或CentOS的x86电脑来辅助,相对繁琐一些。这个工具可以在https://developer.nvidia.com/nvidia-sdk-manager下载,直接使用dpkg进行安装就可以,然后开启SDK Manager进行安装。

这种方式比较麻烦的部分是SDK Mananger的登录步骤(如下图),与前一种方式同样需要有NVIDIA开发者社区的账号与密码,如果没有也得申请一个。但是后台验证步骤需要连上NVIDIA的服务器,因此有时需要重复多次才能成功。

登录成功之后进入“STEP 1”选择安装的内容,请勾选下图最下方“DeepStream”选项,然后点选“CONTINUE”进入下一步。

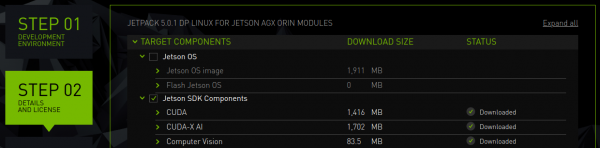

在“STEP 2”里最重要的,就是“取消Jetson OS”选项,如下图所示,因为我们只需要安装DeepStream,而不需要安装操作系统。

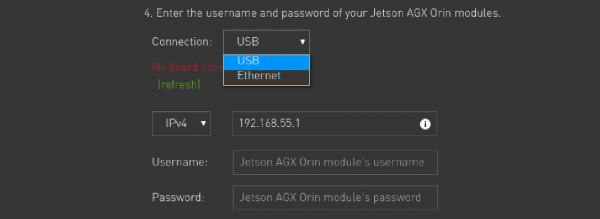

选择好之后,勾选最下方“I accept the terms…”选项,就能进入下个步骤。系统弹出下图对话框,这里有两种连线的选择方式:

- USB:这是Jetson的headless模式进行连接,用Jetson Orin开发套件所提供的Type-C USB传输线将Jetson Orin与PC形成连线;

- Ethernet:使用标准的局域网形成连线,在Jetson Orin可以使用有线或无线的方式。

选择好之后,如果是USB方式则下面的IP预设为192.168.55.1,如果是Ethernet的话则需要自行查清楚Jetson Orin的IP地址。然后输入Jetson Orin的Username与Password,再点击下方“Install”按钮,就能执行DeepStream的安装。

- 使用Docker容器版本:

这是当下最热门的应用与部署技术,从JetPack 4.0版之后,都为Jetson设备安装好Docker基础环境,我们可以直接使用。

DeepStream从5.1开始提供Docker版的使用环境,只需要从NGC下载镜像后就能在Jetson设备上启动使用,不过使用过程需要先熟悉Docker的指令与设备对应关系,这里先教大家在Jetson Orin开发套件上安装Docker版的DeepStream套件。

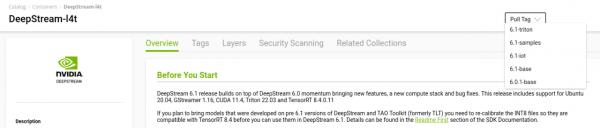

登录https://catalog.ngc.nvidia.com/orgs/nvidia/containers/deepstream-l4t 会进到下图页面中,点击右上角“Pull Tag”下拉选项就会显示目前所支持的各种版本。

Jetson Orin开发套件支持的Jetpack 5.x版本,目前只支持DeepStream 6.1,因此我们需要点击选择下数第二个“6.1-base”,系统已经将下载指令“docker pull nvcr.io/nvidia/deepstream-l4t:6.1-base”复制到剪贴板里面,我们只要在命令行视窗上使用Ctrl-Shift-V组合键,就能完整粘贴的指令:

|

$ |

docker pull nvcr.io/nvidia/deepstream-l4t:6.1-base |

这样就能从NGC下载deepstream-l4t:6.1-base镜像到Jetson Orin开发套件上。至于使用的方式,主要启动指令如下:

|

$

$ |

# 允许外部应用程序连接到主机的X显示器: xhost + # 允许外部应用程序连接到主机的X显示器: sudo docker run -it --rm --net=host --runtime nvidia -e DISPLAY=$DISPLAY \ -w /opt/nvidia/deepstream/deepstream-6.1 -v /tmp/.X11-unix/:/tmp/.X11-unix \ nvcr.io/nvidia/deepstream-l4t:6.1-base |

如果要添加摄像头的话,需要在这个指令里添加以下内容:

- 添加CSI摄像头:-v /tmp/argus_socket:/tmp/argus_socket

- 添加USB摄像头:--device /dev/video<N>

这样就可以开始使用DeepStream 6.1来进行测试与开发了。

来源:业界供稿

好文章,需要你的鼓励

Allen AI团队推出SAGE:首个能像人类一样“想看多长就看多长“的智能视频分析系统

Allen AI研究所联合多家顶尖机构推出SAGE智能视频分析系统,首次实现类人化的"任意时长推理"能力。该系统能根据问题复杂程度灵活调整分析策略,配备六种智能工具进行协同分析,在处理10分钟以上视频时准确率提升8.2%。研究团队创建了包含1744个真实娱乐视频问题的SAGE-Bench评估平台,并采用创新的AI生成训练数据方法,为视频AI技术的实际应用开辟了新路径。

联想推出DE6600系列:更智能的存储解决方案

联想推出新一代NVMe存储解决方案DE6600系列,包含全闪存DE6600F和混合存储DE6600H两款型号。该系列产品延迟低于100微秒,支持多种连接协议,2U机架可容纳24块NVMe驱动器。容量可从367TB扩展至1.798PiB全闪存或7.741PiB混合配置,适用于AI、高性能计算、实时分析等场景,并配备双活控制器和XClarity统一管理平台。

AI视觉模型真的能看懂长篇文档吗?中科院团队首次揭开视觉文本压缩的真相

中科院团队首次系统评估了AI视觉模型在文本压缩环境下的理解能力,发现虽然AI能准确识别压缩图像中的文字,但在理解深层含义、建立关联推理方面表现不佳。研究通过VTCBench测试系统揭示了AI存在"位置偏差"等问题,为视觉文本压缩技术的改进指明方向。

数智时代,openGauss Summit 2025即将发布哪些技术创新破局

“算力+储能”深度融合:超智算发布分布式算力超级节点储能解决方案

联想推出DE6600系列:更智能的存储解决方案

创业公司如何在严格监管行业中实现生死攸关的创新

OpenAI发布GPT-5.2-Codex模型,软件工程自动化能力大幅提升

Waterfox浏览器宣布拒绝AI功能,瞄准Firefox忠实用户

TikTok美国业务出售交易将于下月完成

破局AI数据中心安全瓶颈:Fortinet联合NVIDIA引领隔离式加速新航向

智算中心进化论,科华数据如何做到“更懂”

更高负载、更快建设:2026年数据中心六大趋势

Snowflake数据库更新引发全球大规模服务中断

AI编程初创公司Lovable融资3.3亿美元,英伟达等科技巨头支持