TAO系列12-将模型部署到Jetson设备

前面我们花了很多力气在TAO上面训练模型,其最终目的就是要部署到推理设备上发挥功能。除了将模型训练过程进行非常大幅度的简化,以及整合迁移学习等功能之外,TAO还有一个非常重要的任务,就是让我们更轻松获得TensorRT加速引擎。

将一般框架训练的模型转换成TensorRT引擎的过程并不轻松,但是TensorRT所带来的性能红利又是如此吸引人,如果能避开麻烦又能享受成果,这是多么好的福利!

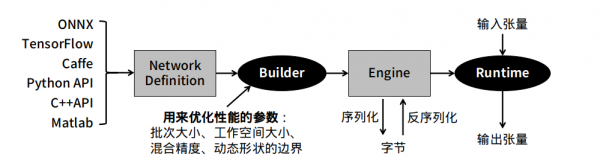

- 一般深度学习模型转成TensorRT引擎的流程

下图是将一般模型转成TesnorRT的标准步骤,在中间”Builder”右边的环节是相对单纯的,比较复杂的是”Builder”左边的操作过程。

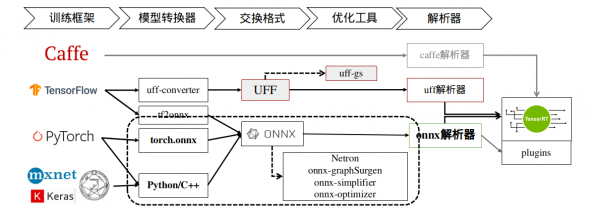

下图就上图 ”Network Definition” 比较深入的内容,TensorRT提供Caffe、uff与ONNX三种解析器,其中Caffe框架已淡出市场、uff仅支持TensorFlow框架,其他的模型就需要透过ONNX交换格式进行转换。

这里以TensorRT所提供的YOLOv3范例来做范例,在安装Jetpack 4.6版本的Jetson Nano设备上进行体验,请进入到TesnorRT的YOLOv3范例中:

|

$ |

cd /usr/src/tensorrt/samples/python/yolov3_onnx |

根据项目的README.md指示,我们需要先为工作环境添加依赖库,不过由于部分库的版本关系,请先将requirements.txt的第1、3行进行以下的修改:

|

1 2 3 4 5 6 |

numpy==1.19.4 protobuf>=3.11.3 onnx==1.10.1 Pillow; python_version<"3.6" Pillow==8.1.2; python_version>="3.6" pycuda<2021.1 |

然后执行以下指令进行安装:

|

$ |

python3 -m pip install -r requirements.txt |

接下来需要先下载download.yml里面的三个文件,

|

$ $

$ |

wget https://pjreddie.com/media/files/yolov3.weights wget https://github.com/pjreddie/darknet/raw/f86901f6177dfc6116360a13cc06ab680e0c86b0/data/dog.jpg |

然后就能执行以下指令,将yolov3.weights转成yolov3.onnx:

|

$ |

./yolov3_to_onnx.py -d /usr/src/tensorrt |

这个执行并不复杂,是因为TensorRT已经提供yolov3_to_onnx.py的Python代码,但如果将代码打开之后,就能感受到这750+行代码要处理的内容是相当复杂,必须对YOLOv3的结构与算法有足够了解,包括解析yolov3.cfg的788行配置。想象一下,如果这个代码需要自行开发的话,这个难度有多高!

接下去再用下面指令,将yolov3.onnx转成yolov3.trt加速引擎:

|

$ |

./onnx_to_tensorrt.py -d /usr/src/tensorrt |

以上是从一般神经网络模型转成TensorRT加速引擎的标准步骤,这需要对所使用的神经网络的结构层、数学公式、参数细节等等都有相当足够的了解,才有能力将模型先转换成ONNX文件,这是技术门槛比较高的环节。

- TAO工具训练的模型转成TensorRT引擎的工具

用TAO工具所训练、修剪并汇出的.etlt文件,可以跳过上述过程,直接在推理设备上转换成TensorRT加速引擎,我们完全不需要了解神经网络的任何结构与算法内容,直接将.etlt文件复制到推理设备上,然后用TAO所提供的转换工具进行转换就可以。

这里总共需要执行三个步骤:

- 下载tao-converter工具,并调试环境:

请根据以下Jetpack版本,下载对应的tao-converter工具:

|

|

Jetpack 4.4:https://developer.nvidia.com/cuda102-trt71-jp44-0 Jetpack 4.5:https://developer.nvidia.com/cuda110-cudnn80-trt72-0 Jetpack 4.6:https://developer.nvidia.com/jp46-20210820t231431z-001zip |

下载压缩文件后执行解压缩,就会生成tao-converter与README.txt两个文件,再根据README.txt的指示执行以下步骤:

- 安装libssl-dev库:

|

$ |

sudo apt install libssl-dev |

- 配置环境,请在 ~/.bashrc 最后面添加两行设置:

|

|

export TRT_LIB_PATH=/usr/lib/aarch64-linux-gnu export TRT_INCLUDE_PATH=/usr/include/aarch64-linux-gnu |

- 将tao-convert变成可执行文件:

|

$ $ $ |

source ~/.bashrc chmod +x tao-converter sudo cp tao-converter /usr/local/bin |

- 安装TensorRT的OSS(Open Source Software)

这是TensorRT的开源插件,项目在https://github.com/NVIDIA/TensorRT,下面提供的安装说明非常复杂,我们将繁琐的步骤整理之后,就是下面的步骤:

|

$ $ $ $ $ $ $

$ $

$ |

export ARCH=请根据设备进行设置,例如Nano为53、NX为72、Xavier为62 export TRTVER=请根据系统的TensorRT版本,例如Jetpack 4.6为8.0.1 git clone -b $TRTVER https://github.com/nvidia/TensorRT TRToss cd TRToss/ git checkout -b $TRTVER && git submodule update --init --recursive mkdir -p build && cd build cmake .. \ -DGPU_ARCHS=$ARCH \ -DTRT_LIB_DIR=/usr/lib/aarch64-linux-gnu/ \ -DCMAKE_C_COMPILER=/usr/bin/gcc \ -DTRT_BIN_DIR=`pwd`/out \ -DTRT_PLATFORM_ID=aarch64 \ -DCUDA_VERSION=10.2 make nvinfer_plugin -j$(nproc) sudo mv /usr/lib/aarch64-linux-gnu/libnvinfer_plugin.so.8.0.1 /usr/lib/aarch64-linux-gnu/libnvinfer_plugin.so.8.0.1.bak sudo cp libnvinfer_plugin.so.8.0.1 /usr/lib/aarch64-linux-gnu/libnvinfer_plugin.so.8.0.1 |

这样就能开始用tao-converter来将 .etlt文件转换成TensorRT加速引擎了。

- 用tao-converter进行转换

- 首先将TAO最终导出(export)的文件复制到Jetson Nano上,例如前面的实验中最终导出的文件ssd_resnet18_epoch_080.etlt,

- 在Jetson Nano上执行TAO的ssd.ipynb最后所提供的转换指令,如下:

|

$ $ |

%set_env KEY= tao converter -k $KEY \ -d 3,300,300 \ -o NMS \ -e ssd_resnet18_epoch_080.trt \ # 自己设定输出名称 -m 16 \ -t fp16 \ # 使用export时相同精度 -i nchw \ ssd_resnet18_epoch_080.etlt |

这样就能生成在Jetson Nano上的ssd_resnet18_epoch_080.trt加速引擎文件,整个过程比传统方式要简便许多。【完】

来源:业界供稿

好文章,需要你的鼓励

Linux基金会成立智能体AI基金会统一管理行业标准

Linux基金会宣布成立代理AI基金会,为AI智能体基础设施开发提供厂商中立的监督。尽管业界承认AI智能体存在安全问题,高德纳咨询公司警告许多企业项目可能因缺乏商业价值而被取消,但基金会仍致力于为AI公司提供中立平台。Anthropic、Block和OpenAI分别贡献了三个项目,包括模型上下文协议、开源AI智能体框架和机器可读文档标准。

快手科技提出新方法:让AI训练不再“翻车“的智慧约束机制

快手科技研究团队提出了熵比截断机制,用于解决强化学习训练中AI容易"走偏"的问题。该方法通过监控AI学习前后思维活跃度变化,在关键时刻进行精准干预,既保证训练稳定性又维持探索能力。在数学推理任务中,此方法显著提升了模型性能并改善了训练稳定性,为AI训练领域提供了新的解决思路。

微软宣布未来四年将在印度投资175亿美元扩大AI业务

微软计划在未来四年内向印度投资175亿美元,这是该公司在亚洲的最大投资。投资将用于建设新数据中心、AI基础设施和技能培训项目。此举正值全球科技巨头加速在印度布局,该国庞大的互联网和智能手机用户群体使其成为关键战场。投资还包括在海德拉巴建设新数据中心区域,并与印度政府合作将AI能力整合到公共数字平台中。

EditThinker:当AI编辑图片也学会“三思而后行“ - 北航与美团联合研究让图像编辑进入“深度思考“时代

EditThinker是北京航空航天大学与美团等机构联合研发的图像编辑AI框架,让AI在编辑图片时能够像人类一样进行反复思考和优化。该系统通过"批评-优化-重试"的循环机制,将传统的一次性编辑转变为迭代改进过程,在四个权威测试平台上显著提升了现有编辑模型的表现,特别是在需要复杂推理的编辑任务中效果突出。

Linux基金会成立智能体AI基金会统一管理行业标准

微软宣布未来四年将在印度投资175亿美元扩大AI业务

Window Maker Live 13.2基于Debian 13为32位PC带来新生

Coder推出混合人员与智能体开发团队治理技术栈

研究人员发现虚拟机管理程序勒索软件攻击激增700%

AI技术快速迭代迫使企业每90天重构技术栈

诺基亚与阿朗企业合作推出端到端园区网络服务

甲骨文红牛车队:用云计算、AI和数据驱动F1未来

新云计算将挑战传统云巨头AI基础设施主导地位

Anthropic与埃森哲达成大规模AI合作协议

从一条带鱼到一杯刺梨汁,拼多多如何用“千亿扶持”改写供给故事?

打通“最后一公里”的持锤人:一家老牌分销商的AI突围与出海野望