走进芯时代:AI算力GPU芯片分析

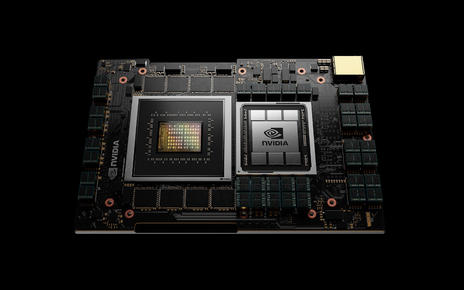

尽管AI芯片种类繁多,GPU因其适应性和强大的并行计算能力,仍是AI模型训练的主流硬件。英伟达在GPU领域的技术积累和生态建设使其处于领先地位,而国内GPU厂商虽在追赶,但仍存在差距。AI应用向云、边、端全维度发展,模型小型化技术成熟,数据传输需求增加,Chiplet技术降低设计复杂度和成本。

META PLATFORMS大规模GPU设施全解析

如果大家每天需要处理数百万亿次AI模型执行,并在生成式AI步入主流的背景下时刻准备将这样的负载规模再提升一、两个数量级,那GPU就是各位不可或缺的战略资源。Meta Platforms明显就是这样,他们正拿出大笔财务预算,想要用“钞能力”从英伟达手中夺取显卡产能。

AI芯片架构众多,谁会主宰算力芯片?

智算中心的发展依托最新AI理论和计算架构,以AI大模型和算力技术为核心。GPU主导算力芯片市场,AI信创推动国产算力。AI分布式计算市场由算力芯片、内存和互联设备组成。ChatGPT推动GPU需求,SK海力士HBM3产量售罄。CoWoS封装技术集成HBM与处理器,台积电领先封装市场。AI算力需求推动高效电源技术发展,背面供电技术成为关键。

AIGC产业图谱V2.0

ChatGPT的火爆使生成式AI(AIGC)回归焦点,AIGC指利用AI技术生成内容,涵盖文本、图像、音频等领域。AIGC产业图谱V2.0展示了基础设施、算法模型、内容应用等生态布局。

ARM NEOVERSE路线图发布:CPU设计出炉,大型GPU缺席

Arm Neoverse数据中心计算路线图刚刚迎来一系列新鲜元素,遗憾的是数据中心级独立GPU加速器仍然缺席。

Nvidia发布第四季度财报 AI芯片需求巨大推动数据中心GPU收入大涨409%

今天Nvidia公布了第四季度财务业绩,结果再次超出华尔街预期,使其股价在盘后交易中走高。

有意见 | 养兵和用兵缺一不可,看清训练和推理,才知道Groq LPU为啥快

根据Groq官网的介绍,LPU是一种专为AI推理所设计的芯片。但要训练大模型,仍然需要购买GPU。

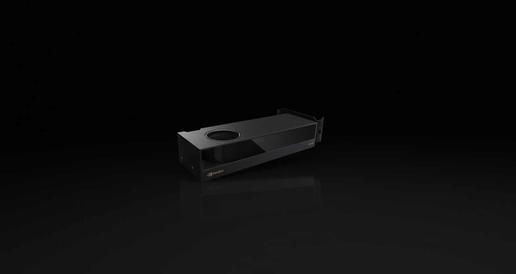

NVIDIA RTX 2000 Ada GPU赋能AI加速的未来,革新各行各业工作流"

NVIDIA RTX 2000 Ada的推出为AI加速带来了高性价比的解决方案,展现了NVIDIA在推动技术进步和赋能未来工作方式方面的前瞻性。

EOS只能半速运行:就连英伟达也无法为自家超级计算机提供充足H100 GPU

要说当下最困难的挑战,就是如何为计算系统采购充足的英伟达“Hopper”H100 GPU。哪怕是作为供应商的英伟达自己,也只能在有限的配额之下谨慎规划、调拨给内部使用。

英伟达推出用于AI加速设计工作负载的RTX 2000 Ada Generation GPU

英伟达公司今天推出了新的Nvidia RTX 2000 Ada Generation GPU,将更强大的生成式人工智能处理器打包到“紧凑型工作站”中,让用户能够在设备上运行高级AI应用程序。

“ANTARES”MI300 GPU表现抢眼,AMD数据中心业务正在复苏

从最近的态势来看,AMD旗下Instinct数据中心GPU加速器业务在2024年的表现似乎将比人们的预期好上不少。

AMD当前已成无可争议的数据中心GPU性能王者

AMD在圣何塞召开的Advancing AI大会上公布了MI300产品家族,基本与英伟达、英特尔和其他AI加速器厂商的节奏保持一致。

为提升GPU性能,英伟达选择对HOPPER HBM内存扩容

一个月前,在英伟达通过财务会议放出的技术路线图中,可以看到GH200 GPU和H200 GPU加速器将作为“Blackwell”GB100 GPU和B100 GPU之前的过渡产品,而Blackwell家族计划在明年年内推出。

支持DirectX Imagination IMG DXD高性能GPU问世

近日,Imagination Technologies推出IMG DXD,这是支持DirectX的高性能GPU IP新产品线的首款产品。

销售火爆令英伟达大赚特赚,季度GPU出货量已达“900吨”

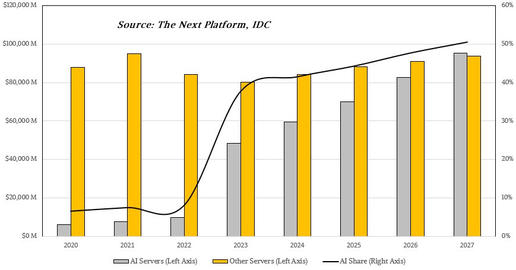

Omdia发布统计,认为在一定时期之内,服务器市场将继续以GPU为最主要的核心组件。这家市场研究机构估计,单英伟达H100 GPU这一款产品在今年第二季度的出货量就超过了900吨。

Nvidia联手初创公司Xanadu使用GPU为量子计算模拟提供动力

Nvidia公司正在和位于多伦多的初创公司Xanadu Quantum Technologies展开合作,首次实现在超级计算机上运行量子计算模拟。

Nvidia发布TensorRT-LLM开源软件 提升高端GPU芯片上的AI模型性能

Nvidia近日宣布推出一款名为TensorRT-LLM的新开源软件套件,扩展了Nvidia GPU上大型语言模型优化的功能,并突破了部署之后人工智能推理性能的极限。

全球系统构建商近期将提供搭载 NVIDIA L40S GPU 的 OVX 系统

NVIDIA L40S GPU 结合 NVIDIA Omniverse 平台,将加速计算密集型的复杂应用,推动生成式 AI 发展并开启更多可能性。