META PLATFORMS大规模GPU设施全解析

如果大家每天需要处理数百万亿次AI模型执行,并在生成式AI步入主流的背景下时刻准备将这样的负载规模再提升一、两个数量级,那GPU就是各位不可或缺的战略资源。Meta Platforms明显就是这样,他们正拿出大笔财务预算,想要用“钞能力”从英伟达手中夺取显卡产能。

早在今年一月,Met Platforms社交网络与AI创新首席执行官马克·扎克伯格就在Instagram上发帖,表示公司年内将为GPU加速器划拨大笔投资,涵盖包括多达35万张英伟达“Hopper”H100 GPU在内的相关设备。其目标只有一个——追求通用人工智能,简称AGI,也就是人们常说的“思考型机器”。

扎克伯格当时指出,到2024年底,Meta Platforms将拥有一大批加速器储备,算上其他GPU设备,其掌握的算力总量将“接近60万张H100显卡的水平。”

如今,Meta Platforms公司的技术人员正通过一系列ODM合作伙伴将这些GPU装进系统,同时发表了一份关于服务器、网络与存储设施的声明,表示这些资源将被用于训练Llama 3大语言模型,用以打造更强、更大、做好生产应用准备的Llama家族最新成员。

让我们先从GPU等效算力的角度入手,再具体看看Facebook在通过Llama 3追求AGI目标时选择了怎样的基础设施架构,最后展望Facebook AI研究与生成式AI实验室后续将要打造的Llama 4与Llama 5模型。

我们并不清楚2022年时Meta Platforms在其队列中掌握有多少张GPU,毕竟当时生成式AI才刚刚崭露头角。早在2017年,Meta Platforms(当时还与其打造的社交网络拳头产品Facebook使用同一名称)就建立起首代AI集群,其中安装有2.2万张“Volta”V100 GPU。

2022年1月,随着生成式AI浪潮初见端倪,Meta Platforms以其DGX服务器设计加200 GB/秒Infiniband互连方案为基础,从英伟达处买下了Research Super Cluster(简称RSC),全部2000个节点能够为AI工作负载提供总计1.6万个GPU。根据当时的报道,RSC设备的首阶段版本采用6080张英伟达的“Ampere”A100 GPU加速器,系统于2022年10月正式上线运行。2023年5月,RSC最终版本建成,但采用的并不是当时正在发售的“Hopper”H100 GUP,而是9920块A100 GPU加速器。各节点均基于200 GB/秒Infiniband网络在双层闭合拓扑中实现互连。

根据Omdia发布的报告,Meta Platforms当时计划在2023年从英伟达手中分得15万块H100 GPU。我们猜测这些H100 GPU将被纳入Meta Platforms于2022年10月披露的“Grand Teton”系统当中。结合当时的信息,我们还估计该系统将采用博通的PCI-Express交换机,用于实现Grand Teton设备内各GPU与CPU间的多路连接。

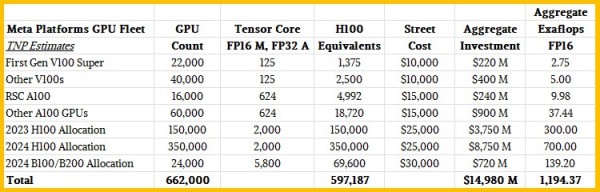

基于以上历史资料,我们又整理出下面这份2024年内Meta Platforms GPU集群的归纳表格:

很明显,其中有很多部分只能用猜测来填补。但没关系,思想实验有益无害,我们不妨大胆假设。

让我们先考虑以下几个问题。如果Omdia公布的2023年Meta Platforms H1200配额数量正确,那么Meta Platforms在2023年和2024年掌握的H100 GPU总量将完全可以满足20个集群所需要的24576张——这里的20个集群,正是该公司本周公布新系统消息时做出的表述。

今年年内将有35万张H100 GPU落入Meta Platforms手中,所以明显可知:无论“Blackwell”B100和B200 GPU加速器有多强,Meta都已经不想再等,而需要马上投入对AGI的全力研发。当然,这并不是说Meta Platforms今年就拿不到Blackwell GPU。

如果我们假设社交巨头拥有约4万块传统GPU(估计大多数是V100),再加上RSC之前出现的第一代超级计算机上安装的2.2万张V100,而后根据V100 GPU张量核心的FP16与FP32算力进行等效换算,基本就能确定Meta Platforms中手英伟达GPU在AI工作负载场景下的相对性能。由此可知,6.2万张V100 GPU仅相当于3875张H100,而在当时按市场行情采购这批V100 GPU大概需要6.2亿美元。虽然Meta Platforms应该是享受到了一点批量优惠,但恐怕空间不大。

我们猜测Meta Platforms的集群中可能拥有7.6万张A100 GPU,相当于2.37万张H100,意味着纯GPU采购就需要11亿美元。如果A100的储备规模确实如此,那么其张量核心的FP16精度算力将拥有超过47千万亿次的总体性能水平(配合稀疏性支持进行性能优化),相当于用不到2倍的价格得到了6.1倍的总和算力。

而Meta Platforms这座庞大的50万H100 GPU算力池在总体投入方面则再上一个数量级,纯GPU采购成本就高达125亿美元,相当于以往投入的11倍。其FP16精度下的总算力为1000百亿亿次,性能提升则高达21.1倍,相当于FP16精度算力的成本减半。如果Meta Platforms在其模型中使用FP8精度(该公司已经明确提及),那么相对性能将再次翻倍,成本效益也会随之优化。

顺带一提,这里我们讨论的Meta Platforms超算系统单就训练而言,但其在实际应用中可能是训练与推理混合。Meta Platforms发布的博文并未对此做出解释。此外,整个算力池也将包含内部原研的MTIA设备。

无论如何,我们认为今年Meta Platforms一定会为2.4万张Blackwell B 100或者B200 GPU留出预算空间。如果英伟达真能为Meta Platforms提供这么多GPU,我们相信其肯定会相应建立一套纯Blackwell GPU集群。当然,具体可能是英伟达Blackwell 设备同AMD“Antares”Instinct MI300X设备的组合。

事实上,Meta Platforms当前讨论的两大集群之一,已经确定将基于400 Gb/秒InfinBand网络。这一点非常有趣,因为Meta Platforms本身其实是超以太网联盟的成员之一,而且曾经表示希望以太网能在某些指标方面与InfiniBand看齐,甚至已经在为达成目标而努力。

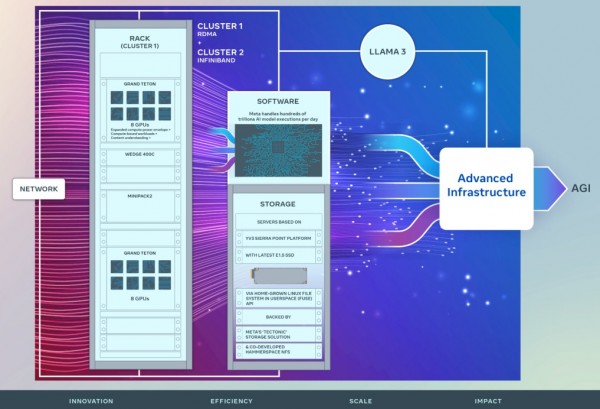

Meta Platforms基础设施负责人Kevin Lee、Adi Gangidi和Mathew Oldham在博文中写道,“我们的新型AI集群将建立在RSC的成功与经验教训基础之上。我们专注于构建端到端AI系统,着力为研究人员和开发人员提供更好的体验与生产效率。这些集群将采用效率更高的高性能网络架构,配合一系列关键存储调整,再加上每个良种 的24576张英伟达Tensor Core H100 GPU,意味着两套集群都能支持超越当初RSC容纳能力的更大、更复杂的模型,希望能够为生成式AI产品的开发与AI研究的进步铺平道路。”

该公司还重申了其对于开源Grand Teton服务器设计、用于容纳硬件的OpenRack机架、开源PyTorch框架以及开源Llama大语言模型的支持承诺。

如果按照24576张GPU计算,就会发现图中系统内的各机架只容纳了两套Grand Teton系统,也就是说Meta Platforms在其博文中提到的这两大集群,各自在1536个机架中安装有3072个节点。从这个密度来看,Meta Platforms显然还没有全面普及液冷设计的打算,因为液冷方案能够让四台GPU机器运行在单一机架之内。当然,这可能也与Meta Platforms选择的机架间网络连接方式有关。

在上图中,我们还能看到Wedge 400C与Minipack2网络机架的身影,其由Arista Networks根据OCP规格构建,明显是面向以太网交换基础设施。这些集群的InfiniBand与以太网版本均提供8个用于连接GPU服务器的400 Gb/秒端口,对应每GPU一个。

Meta Platforms的技术人员写道,“通过这两种网络机架,我们能够评估不同互连类型对于大规模训练场景的适用性与可扩展性,据此收集更多见解,帮助我们了解未来要如何设计并构建规模更大的集群。通过对网络、软件和模型架构进行认真协调和设计,我们成功将RoCE与InfiniBand集群应用在大型生成式AI工作负载之上(包括在RoCE集群上持续训练Llama 3),期间未发现任何网络瓶颈。”

这些GPU集群采用的存储服务器将基于安装E1.S SSD闪存模块的“Sierra Point”Yosemite V3服务器。Meta Platforms还自主开发了用户空间内Linux文件系统(FUSE),该系统将运行在各Sierra Forrest存储服务器之上,并由Meta公司自己的闪存Tectonic存储覆盖层提供备份(Tectonic中的Haystack文件系统针对磁盘驱动器进行了优化),同时搭配与Hammerspace共同开发的分布式NFS文件系统。

我们也在努力整理这些AI集群所使用的参考架构,更多消息将在后续文章中为大家一一呈现。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元