走进芯时代:AI算力GPU芯片分析

尽管AI芯片种类繁多,GPU因其适应性和强大的并行计算能力,仍是AI模型训练的主流硬件。英伟达在GPU领域的技术积累和生态建设使其处于领先地位,而国内GPU厂商虽在追赶,但仍存在差距。AI应用向云、边、端全维度发展,模型小型化技术成熟,数据传输需求增加,Chiplet技术降低设计复杂度和成本。

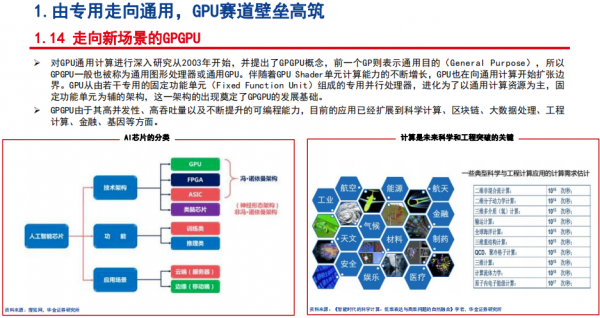

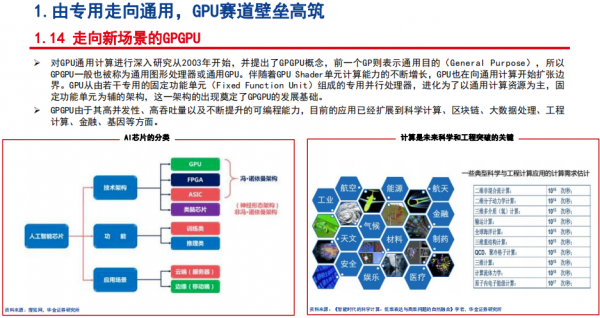

虽然Al芯片目前看有SPU、ASIC、CPU、FPSA等几大类,但是基于几点原因我们判断GPU仍将是训练模型的主流硬件:

1、Transformer架构是最近几年的主流,该架构最大的特点之一就是能够利用分布式BPU进行并行训练,提升模型训练效率;

2、ASIC的算力与功耗虽然看似有优势,但考虑到AI算法还是处于一个不断发展演进的过程,用专用芯片部署会面临着未来算法更迭导致芯片不适配的巨大风险;

模型小型化技术逐步成熟,从训练走向推理。云、边、端全维度发展。

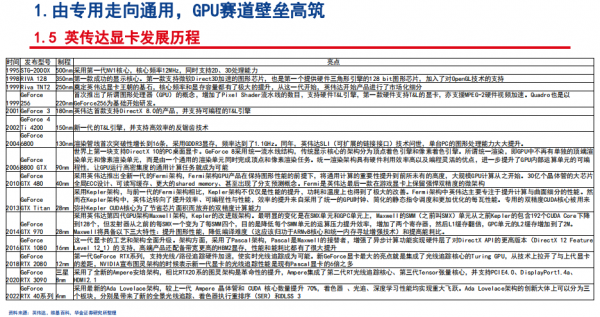

1、GPU方面, 在英伟达的推动下,其从最初的显卡发展到如今的高性能并行计算,海外大厂已经具备了超过20年的技术、资本、生态、人才等储备,形成了大量的核心技术专利,而且也能充分享有全球半导体产业链的支撑,这都或是目前国内厂商所缺失的。

近几年在资本的推动下,国内涌现出数十家GPU厂商,各自或都具备一定的发展基础,但整体经营时间较短,无论从技术积淀、产品料号布局、高端料号件能夹说,与国外大厂仍具备较大差距。但国产化势在必行,国内相关产业链重点环节也积极对上游芯片原厂进行扶持,国产算力芯片需要不断迭代以实现性能的向上提升,后续持续关注相关厂商料号升级、生态建设和客户突破:

2、 Al在端侧设备应用普及是大势所趋,目前,知识蒸馏、剪枝、量化等模型小型化技术在逐步成熟,Al在云、边、端全方位发展的时代已至。除了更加广泛的应用带来需求量的提升外,更复杂算法带来更大算力的需求也将从另一个维度推动市场扩容;

3、数据的高吞吐量需要大带宽的传输支持,光通信技术作为算力产业发展的支撑底座,具备长期投资价值;

4、 Chiplet技术可以突破单一芯片的性能和良率等瓶颈,降低芯片设计的复杂度和成本。

0赞

0赞好文章,需要你的鼓励

推荐文章

推荐文章

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。