NVIDIA Jetson Nano 2GB系列文章(30):DeepStream 摄像头“实时性能”

前面介绍过使用deepstream-app工具,启用多个视频进行车辆与行人的识别,并且启动“追踪”功能进行物件追踪的高级功能,接下来就教大家如何在deepstream-app里调用USB与CSI摄像头,并且与先前的视频同时启用来进行物件识别的应用。

这里使用Jetson Nano 2GB作为实验平台,上面安装一个CSI摄像头与一个USB摄像头。

在调用摄像头之前,建议先确认一下摄像头的位置与分辨率等信息,因为DeepStream会检查设定文件里的分辨率是否符合要求。使用v4l2-utils工具包来检查摄像头的信息,请按照以下步骤进行安装,并且检测摄像头分辨率:

|

sudo apt-get install v4l2-utils v4l2-ctl --list-devices |

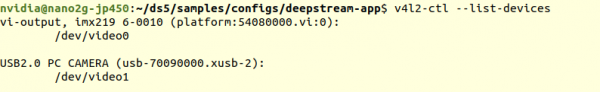

下面显示的信息,表示目前接上一个imx-219的CSI摄像头,以及一个USB 2.0摄像头。

接下执行以下指令,查看个别摄像头可使用的分辨率为多少:

|

v4l2-ctl --list-formats-ext --device=0 v4l2-ctl --list-formats-ext --device=1 |

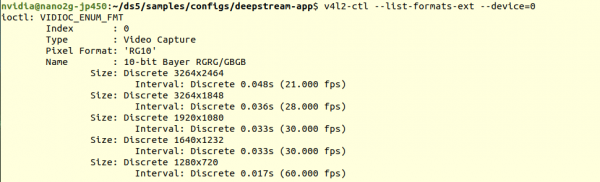

下面显示的信息,表示CSI摄像头(device=0)能支持3264x2464、3264x1848、1920x080、1640x1232、1280x720等5种分辨率

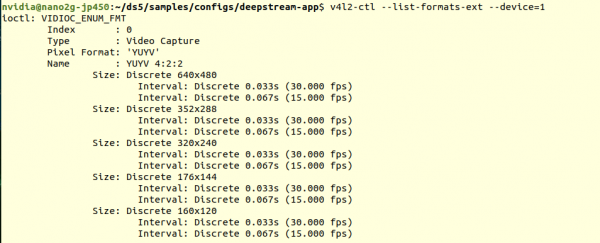

下面显示的信息,表示USB摄像头(device=1)能支持640x480、352x288、320x240、176x144、160x120等5种分辨率

接下来看看在DeepStream路径(/opt/nvidia/deepstream/deepstream)的samples/configs/deepstream-app 下面有个 source2_csi_usb_dec_infer_resnet_int8.txt文件,这是专门以CSI与USB摄像头为输入源的配置,里面可以看到以下关于摄像头设置的内容:

|

[source0] enable=1 #Type - 1=CameraV4L2 2=URI 3=MultiURI 4=RTSP 5=CSI type=5 camera-width=1280 camera-height=720 camera-fps-n=30 camera-fps-d=1 camera-csi-sensor-id=0

[source1] enable=1 #Type - 1=CameraV4L2 2=URI 3=MultiURI type=1 camera-width=1280 camera-height=720 camera-fps-n=30 camera-fps-d=1 camera-v4l2-dev-node=6 |

在[source1]下面的参数有点小问题,用粗体标识出来,因为我们装载的USB摄像头最大分辨率为640x480,因此这里的camera-width与camera-height都必须修改为摄像头所支持的分辨率,此外就是最下面的camera-v4l2-dev-node的部分,前面检查出来这台Jetson Nano 2GB上的USB摄像头编号为“1”,请按照实际状况修改。

将上面三地方修改完后,就可以直接执行以下指令去启动摄像头:

|

deepstream-app -c source2_csi_usb_dec_infer_resnet_int8.txt |

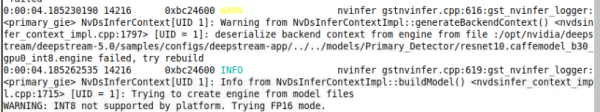

由于配置文件里面原本设定使用INT8的精度去做推理,但是Jetson Nano 2GB并不支持,因此DeepStream自动切换成FP16精度,这需要重新生成对应的TensorRT引擎,会花点时间。

执行之后就能看的画面上出现类似以下的画面,上下分别是CSI摄像头与USB摄像头的显示,由于选择的模型是检测“Car”与“Person”的,所以在这里没有检测到任何目标物件。

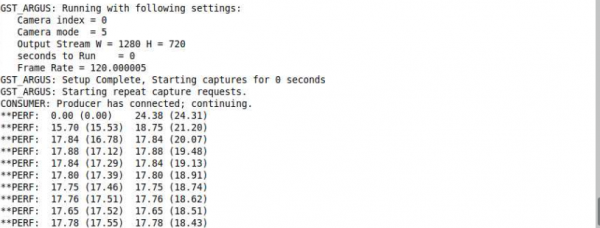

另外看一下先前下指令的终端上,显示在Jetson Nano 2GB上的执行性能如下截屏

两个摄像头都能达到18FPS左右性能,总性能在36FPS左右,已经非常接近实时识别的速度,非常好。您可以试试旋转摄像头或者将手放在前面晃一晃,看看延迟状况如何?应该是很流畅的。

接下来,再添加两个视频文件一起进来执行检测,我们以系统上提供的视频文件做示范:

- /opt/nvidia/deepstream/deepstream/samples/streams/sample_1080p_h264.mp4

- /usr/share/visionworks/sources/data/pedestrians.h264

将这两个的设定添加到文件里的[source2]与[source3],内容如下:

|

[source2] enable=1 type=2 uri=file://../../streams/sample_1080p_h264.mp4

[source3] enable=1 type=2 uri=file:///usr/share/visionworks/sources/data/pedestrians.h264 |

最后调整文件最开始的“[tiled-display]”下面,将“columns=”的值改成“2”,存档后重新执行下面指令:

|

deepstream-app -c source2_csi_usb_dec_infer_resnet_int8.txt |

现在可以看到如下图,两个摄像头与两个视频总共4个输入源同时执行的推理的功能。

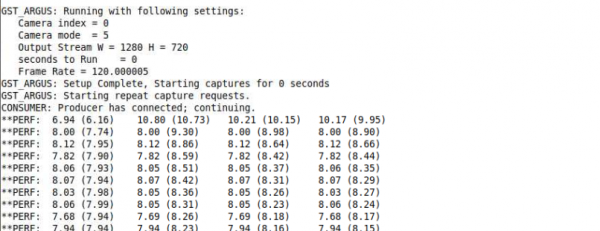

接下来看看此时的性能如何?(如下图)居然每个输入源只剩下8FPS的性能,总性能在32FPS左右,似乎有点慢了。这个问题有补救的办法吗?

实时上问题出现在[primary-gie]使用的模型上,因为Jetson Nano(含2GB)的计算资源较为缺乏,因此DeepStream专门为Nano提供resnet10.caffemodel_b8_gpu0_fp16.engine特调版加速引擎,存放在“../../models/Primary_Detector_Nano”路径下,这是第一个需要做修改的地方:

- model-engine-file=../../models/Primary_Detector_Nano/resnet10.caffemodel_b8_gpu0_fp16.engine

其次就是下面的“config-file”置换成支持Nano版本的配置文件,如下:

- config-file=config_infer_primary_nano.txt

修改完使用的模型之后,重新执行deepstream-app进行物件检测,发现每个数据源的识别性能,立即从原本的8FPS提升到14FPS,也就是总性能从32FPS上升到56FPS左右,提升大约1.8倍。到这里否已经满足样的性能呢?

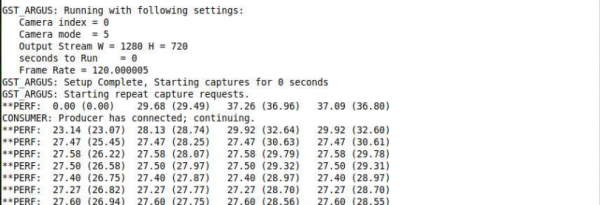

如果还觉得不满足的时候,那就继续看下去,还有大招在后面。只要我们将[primary-gie]下面的“interval”参数设为“1”,这时候再执行看看性能如何?

下面的截屏是调整interval参数之后的性能,有没有吓一跳?瞬间提升一倍。

经过三步骤调整之后,我们在Jetson Nano 2GB上的4个数据源,识别性能都超过27FPS,总性能合计超过100FPS,并且维持识别效果。

现在是不是对Jetson Nano 2GB的性能感到非常满意了!【完】

来源:业界供稿

好文章,需要你的鼓励

谷歌智能体开发套件架构深度解析:从核心组件到实践应用

谷歌Agent Development Kit(ADK)革新了AI应用开发模式,采用事件驱动的运行时架构,将代理、工具和持久化状态整合为统一应用。ADK以Runner为核心,通过事件循环处理用户请求、模型调用和外部工具执行。执行逻辑层管理LLM调用和工具回调,服务层提供会话、文件存储等持久化能力。这种架构支持多步推理、实时反馈和状态管理,为构建超越简单聊天界面的生产级AI应用提供了完整框架。

上海AI实验室让机器人“睁眼看世界“:用视觉身份提示技术让机械臂学会多角度观察

上海AI实验室联合团队开发RoboVIP系统,通过视觉身份提示技术解决机器人训练数据稀缺问题。该系统能生成多视角、时间连贯的机器人操作视频,利用夹爪状态信号精确识别交互物体,构建百万级视觉身份数据库。实验显示,RoboVIP显著提升机器人在复杂环境中的操作成功率,为机器人智能化发展提供重要技术突破。

iOS 18新增游戏应用正式上线,专为iPhone游戏体验而生

苹果在iOS 26中推出全新游戏应用,为iPhone、iPad和Mac用户提供个性化的游戏中心。该应用包含五个主要版块:主页展示最近游戏和推荐内容,Arcade专区提供超过200款无广告游戏,好友功能显示Game Center动态并支持游戏挑战,资料库可浏览已安装游戏并提供筛选选项,搜索功能支持按类别浏览。iOS 26.2版本还增加了游戏手柄导航支持,为游戏玩家提供更便捷的操作体验。

英伟达团队突破AI训练瓶颈:让机器人同时学会多种技能不再“顾此失彼“

英伟达研究团队提出GDPO方法,解决AI多目标训练中的"奖励信号坍缩"问题。该方法通过分别评估各技能再综合考量,避免了传统GRPO方法简单相加导致的信息丢失。在工具调用、数学推理、代码编程三大场景测试中,GDPO均显著优于传统方法,准确率提升最高达6.3%,且训练过程更稳定。该技术已开源并支持主流AI框架。

谷歌智能体开发套件架构深度解析:从核心组件到实践应用

iOS 18新增游戏应用正式上线,专为iPhone游戏体验而生

Sleepbuds制造商Ozlo如何构建睡眠数据平台

CES 2026推出AI伴侣机器人Emily

苹果2026年将发布四款新iPhone机型预览

AGI-Next峰会全记录解读:Kimi、Qwen、智谱、腾讯同台,2026年有新范式是共识,中国引领AI概率最低预测2成

Anthropic推出医疗健康功能助力患者理解病历记录

Google推出通用商务协议,推动智能体购物自动化

核电初创公司携小型反应堆回归,面临重大挑战

谷歌针对部分医疗查询移除AI概览功能

Motional采用AI优先策略重启无人驾驶出租车计划

新年存储升级:三星SSD优惠最高减免100美元