NVIDIA Jetson Nano 2GB 系列文章(29): DeepStream 目标追踪功能

在计算机视觉的应用中,“识别”只是一个相当入门的技术,相信很多人在执行深度学习推理应用中,经常产生的质疑就是“识别出的类别,有什么用途呢”?

确认每一帧图像中有多少个我们想要识别的种类,以及他们在图像中的位置,只是整个应用的第一步而已,如果缺乏“目标追踪(tracking)”的能力,就很难提供视频分析的基础功能。

在标准 OpenCV 体系里有 8 种主流的目标追踪算法,有兴趣的可以在网上搜索并自行研究。

算法的基本逻辑就是需要对视频的相邻帧进行“类别”与“位置”的比对,因此这部分的计算还是相当消耗计算资源的,也就是当视频分析软件“开启”目标追踪功能时,其识别性能必定有所下降,大家必须先有这样的认知。

DeepStream 的定位就是针对“视频分析”的应用,因此“目标追踪”是其最基本的功能之一。

在前面使用的 myNano.txt 配置文件中,只需要调整一个设定值就能开启或关闭这个追踪功能,非常简单。

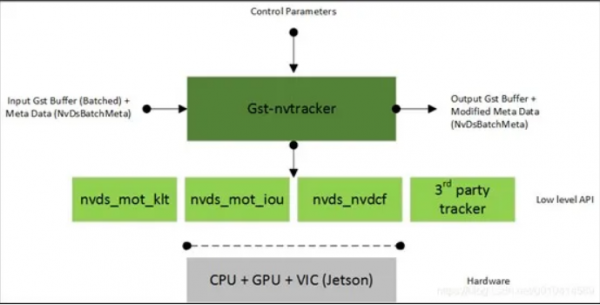

DeepStream 支持 IOU、KLT 与 NVDCF 三种目标追踪算法(如下图),其中 IOU 的性能最好,在 Jetson Nano 2GB 上的总体大约能到 200FPS;NVDCF 的精确度最高,但目前性能大约只能到 56FPS;KLT 算法目前在性能与精确度的平衡比较好,总体性也能到 160FPS,因此通常都选择 KLT 追踪器做演示。

算法的细节不多做解释,请自行寻找相关技术文件学习,这里就直接进入实验的过程。还是以前一篇文章中的 myNano.txt 配置文件为主,如果不知道的话,就用 source8_1080p_dec_infer-resnet_tracker_tiled_display_fp16_nano.txt 复制一份出来就可以,透过修改里面的参数,让大家体验一下 DeepStream 目标追踪的功能。

01

目标追踪功能的开关

在 myNano.txt 最下方,可以看到[tracker]的设定组,下面有个“enable=1”的参数,就是目标追踪的功能。

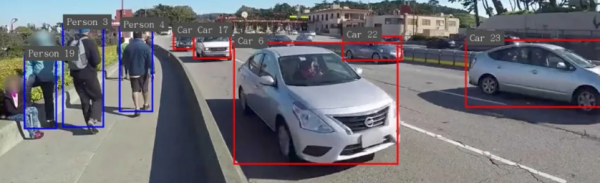

现在先执行一次启动追踪功能,如下图可以看到每个识别出的物件除了类别、标框之外,旁边还有个编号,这个编号会一直跟着该物件,这样就形成“追踪”的功能。

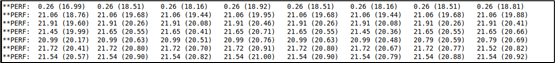

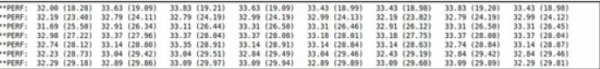

此时的识别性能如下图,总性能(8 个数字相加)大约 160FPS。

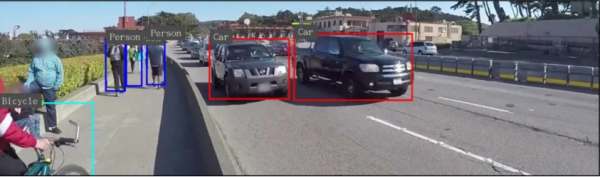

如果将[trakcer]下面改成“enable=0”,再执行看看结果如何?下图中能识别出物件的类别与标框位置,但是已经没有编号。

关闭追踪功能之后的识别性能如下图,总识别性能可以达到 250FPS 左右。

02

切换追踪器

前面说过,目前 DeepStream 5.0 支持三种追踪器,那么要如何选择呢?同样在[tracker]参数组下方,有这样的三行参数:

|

#ll-lib-file=/opt/nvidia/deepstream/deepstream-5.0/lib/libnvds_mot_iou.so #ll-lib-file=/opt/nvidia/deepstream/deepstream-5.0/lib/libnvds_nvdcf.so ll-lib-file=/opt/nvidia/deepstream/deepstream-5.0/lib/libnvds_mot_klt.so |

前面加上“#”号的就是处于关闭的状况,请先将[tracker]切回“enable=1”的开启状态,接下来请自行加减“#”的位置以切换追踪器的选择,分别测试这三个追踪器的不同之处,包括识别性能与追踪能力。

这部分必须直接在视频中体验,因此就不截屏显示。测试结果可以感受到 IOU 追踪器的性能最好,可达到 200FPS 左右,但是同一物件的编号并不是太稳定,而 NVDCF 追踪器的编号最为稳定,但性能大概只有 IOU 的 1/4,最多只能承受 2 路视频的实时分析。

KLT 算法总体性能可达到 160FPS,可以支持到8路以内的实时识别,追踪能力也比 IOU 好不少,不过这个算法对 CPU 的占用率比较高,是这个算法的主要缺点。该如何选择需要看实际的场景与计算设备的资源而定。

03

获取追踪数据

前面打开目标追踪功能的目的,并不只是为了在显示器上看看而已,而是用这些数据做更有价值的应用,而这些数据要从什么地方得到呢?通常都需要透过 Python 或 C++从 DeepStream 提供的接口去获取。

这里提供一个无需了解 DeepStream 接口就能获取目标追踪数据的方法,只要我们在 myNano.txt 里面的[application]参数组,添加一条“kitti-track-output-dir=<PATH>”的路径指向就可以,这里假设要将数据存入“/home/nvidia/track”路径下,在 myNano.txt 里添加一行参数即可:

|

[application] 。。。 。。。 kitti-track-output-dir=/home/nvidia/track |

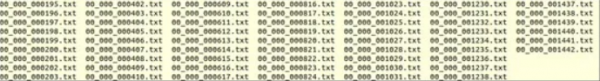

执行“deepstream -c myNano.txt”之后,就可以看到/home/nvidia/track目录下产生非常多的文件,如下截屏:

每个文件存放“一帧”的目标追踪结果,例如我们测试的 sample_1080p_h264.mp4 视频有 48 秒,每秒有 30 帧图像,就会生成 1440 个文件。

前面 6 位数“00_000”代表视频源的编号,从“0”开始,如果有 4 路视频源就会有“00_000”~“00_003”的编号,后面 6 位则是流水号,例如这个测试视频就会生成“000000.txt”~“001440.txt”,由这两部分组合而成文件名。

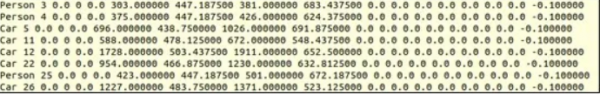

最后看一下文件的内容,如下所示:

这是 KITTI 格式的数据,第一栏位是该物件的类别,第二栏是该物件的“追踪编号”,后面数据所代表的意义,请自行参考 KITTI 的格式定义。

现在我们就可以依序读入这些追踪文件,或者将这些文件回传给控制中心,进行文件解析与信息提取,这样是不是很方便?相信这些内容对于开发会很有帮助。

来源:业界供稿

好文章,需要你的鼓励

Allen AI团队推出SAGE:首个能像人类一样“想看多长就看多长“的智能视频分析系统

Allen AI研究所联合多家顶尖机构推出SAGE智能视频分析系统,首次实现类人化的"任意时长推理"能力。该系统能根据问题复杂程度灵活调整分析策略,配备六种智能工具进行协同分析,在处理10分钟以上视频时准确率提升8.2%。研究团队创建了包含1744个真实娱乐视频问题的SAGE-Bench评估平台,并采用创新的AI生成训练数据方法,为视频AI技术的实际应用开辟了新路径。

联想推出DE6600系列:更智能的存储解决方案

联想推出新一代NVMe存储解决方案DE6600系列,包含全闪存DE6600F和混合存储DE6600H两款型号。该系列产品延迟低于100微秒,支持多种连接协议,2U机架可容纳24块NVMe驱动器。容量可从367TB扩展至1.798PiB全闪存或7.741PiB混合配置,适用于AI、高性能计算、实时分析等场景,并配备双活控制器和XClarity统一管理平台。

AI视觉模型真的能看懂长篇文档吗?中科院团队首次揭开视觉文本压缩的真相

中科院团队首次系统评估了AI视觉模型在文本压缩环境下的理解能力,发现虽然AI能准确识别压缩图像中的文字,但在理解深层含义、建立关联推理方面表现不佳。研究通过VTCBench测试系统揭示了AI存在"位置偏差"等问题,为视觉文本压缩技术的改进指明方向。

数智时代,openGauss Summit 2025即将发布哪些技术创新破局

“算力+储能”深度融合:超智算发布分布式算力超级节点储能解决方案

联想推出DE6600系列:更智能的存储解决方案

创业公司如何在严格监管行业中实现生死攸关的创新

OpenAI发布GPT-5.2-Codex模型,软件工程自动化能力大幅提升

Waterfox浏览器宣布拒绝AI功能,瞄准Firefox忠实用户

TikTok美国业务出售交易将于下月完成

破局AI数据中心安全瓶颈:Fortinet联合NVIDIA引领隔离式加速新航向

智算中心进化论,科华数据如何做到“更懂”

更高负载、更快建设:2026年数据中心六大趋势

Snowflake数据库更新引发全球大规模服务中断

AI编程初创公司Lovable融资3.3亿美元,英伟达等科技巨头支持