面对服务器CPU之争,英特尔决定将产品线一分为二

由于英特尔的代工设施在制程工艺和封装技术方面仍不及竞争对手台积电,因此芯片巨头的服务器CPU产品线也必须“将就”代工部门的当前水平,开发出兼具性能与价格竞争力的方案。也只有这样,英特尔才能在x86领域与CPU老对手AMD以及正在数据中心内开拓CPU业务战线的Arm阵营正面抗衡。

面对现实挑战,英特尔决定将其产品线一分为二:其一为传统至强核心(即所谓性能P核),其二为经过改进的Atom核心(即所谓能效E核)。更准确地讲,与其说这是英特尔至强产品线迎来了新分支,倒不如说这是对英特尔十多年来产品开发原则的进一步强化。(「Knights Landing」至强Phi处理器属于Atom CPU的高性能版本,首次搭载了AVX-512向量数学单元。该单元依托于服务器核心之上,而此核心几乎不可能在移动设备等平台上使用。)

但这种产品线划分也有自己的风险,甚至从极端角度来看,这很可能成为决定英特尔未来命运的重要决策。

这一次,英特尔决定不再像过去那样依靠Atom核心开发低端服务器CPU、并严格限制主内存与I/O扩展,指望这类便宜产品能够被企业客户广泛接纳并大量采购,像过冬的罐头食品那样以量取胜。相反,芯片巨头开始将大量Atom核心整合进真正的服务器插槽当中,并配备真正的内存与I/O容量,通过标准至强服务器平台提供出色的性价比与散热性能,积极迎合标准至强性能P核和超线程技术难以满足的高吞吐量工作负载的现实需求。

从长远来看,也就是在未来五年左右,市场将决定这两种几乎采用相同指令集,但布局各异且每核心L3缓存大小不同的核心到底谁能胜出。AMD采取的也是类似的策略,而且做出的区分更加微妙:Epyc 9000系列“Genoa”变体中使用的就是其标准Zen 4核心,而“Bergamo”高核心数CPU以及“Siena”低发热量服务器CPU采用的则是Zen 4c核心。

另外需要注意的是,苏姿丰在日前Computex 2024的主题演讲中指出,虽然AMD目前在x86服务器CPU出货量中已经占据33%份额,但另外67%仍然由英特尔牢牢把控——而这还是在其代工部门不够给力的条件之下。如今的芯片巨头正在一步步走出困境。

英特尔预计将在2025年左右收拾好其代工设施方面的烂摊子,继续凭借丰富的优秀架构师资源发布出色的CPU设计,甚至可能凭借其“Falcon Shores”项目推出具有市场竞争力的GPU产品。英特尔还在努力提高其封装良品率。英特尔的大举反攻,肯定会让AMD和Arm阵营的日子越来越不好过。至强6产品线的两大版本——包括在Computex上首度亮相的“Sierra Forest”能效E核芯片,以及计划在今年第三季度推出的“Granite Rapids”性能P核芯片——将成为英特尔缩小服务器CPU差距的第一步。到一年半之后,CPU市场真正的血雨腥风将最终袭来,我们预计在各方拼尽全力之后,x86领域的市场份额将继续维持目前的比例。而在不久之后,Arm将逐步占据整体服务器CPU出货量的20%,RISC-V也将赢得一部分客户的青睐。

换句话说,数据中心领域的CPU大战还远未结束。

一套架构,两个目标

英特尔长久以来一直在强调能效E核与性能P核战略,但在着眼于首批Sierra Forest芯片之前,我们不妨了解这项战略中的一些核心原则。而英特尔之所以没有一次性发布整个产品线,我们怀疑就是因为其用于制造Sierra Forest芯片的Intel 7与Intel 3制程工艺仍存在产能限制。

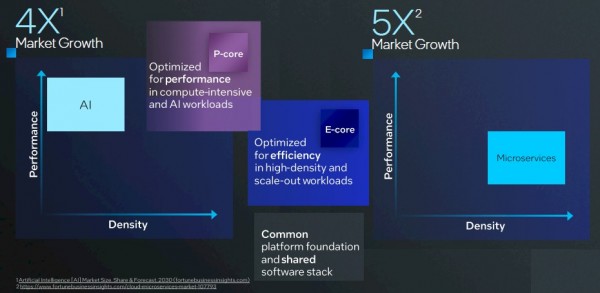

上图所示,为我们根据英特尔公布的两张图表整理而成的结果。图中显示至强6的性能P核变体将主要面向AI工作负载,同时也适用于高性能计算(HPC)模拟与建模,以及其他一切强调核心处理性能的通用型工作负载。其实AI也只是计算密集型工作负载当中的一种,只是在这波生成式AI浪潮的影响之下,确实有更多企业客户希望在自己的CPU集群当中本地运行AI工作负载,从而实现对生成式AI模型的预训练或者配合自有业务数据对模型进行二次训练。

由于能效E核芯片不具备AVX-512向量单元或者AMX矩阵数学单元,因此在AI和HPC运算方面很难发挥主导性作用。这些产品实际还是为传统应用程序、打印、文件和Web服务所设计,但在某些情况下,E核的变体版本可能也足以支撑代码规模相对适中的各类微服务应用程序。英特尔表示,视频流、媒体转码及其他类型的数据流处理都是能效E核芯片的理想应用场景。

在E核与P核设计中,内存和I/O控制器乃至用于CPU NUMA共享内存集群的UltraPath Interconnect(UPI)链接都与核心彼此分离,各核心共同构成一组、两组或三组chiplet小芯片。2023年1月发布的“Sapphire Rapids”至强SP v4的每个小芯片上都设计完备,且每四个小芯片对应一个插槽。而随着2023年12月发布“Emerald Rapids”至强SP v5,英特尔决定退而求其次,只使用两个小芯片但增加总核心数量,且所有控制器仍与核心位于同一小芯片之上。对于低核心数及中核心数设备,Sapphire Rapids及Emerald Rapids也提供单小芯片的单片版本。

Sierra Forest至强6处理器上的核心复合体则采用7纳米制程的Intel 3工艺制造,I/O及内存芯片则采用10纳米制程的Intel 7工艺制造,与Sapphire Rapids和Emerald Rapids基本保持一致。

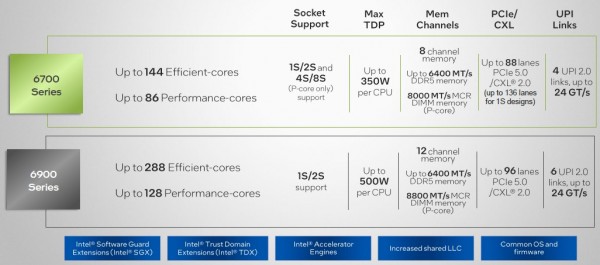

至强6处理器将分为两个封装版本,分别为6700和6900,二者又将按能效E核和性能P核做进一步区分。至强6家族暂时不会将E核和P核混合在同一封装之内,但如果有采购量可观的客户表示兴趣,英特尔也愿意考虑制造。

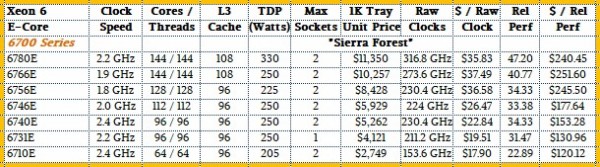

下面来看6700系列与6900系列的性能规格:

本质上讲,6700系列基本分为低核心数(LCC)、高核心数(HCC)和极端核心数(XCC)芯片,这些芯片通过EMIB封装被整合在一起。但英特尔似乎没有提供中核心数(MCC)版本。

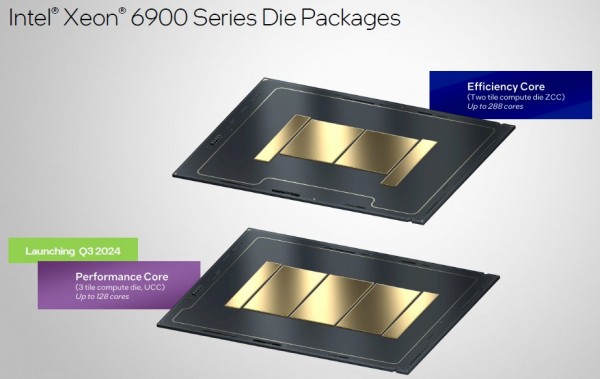

下图所示,为至强6 6700系列芯片的封装样式:

再来看6900系列芯片的封装样式:

至强6系列服务器CPU将采取“错峰式”发布节奏,据英特尔称这是为了迎合客户提出的需求。低端Sierra Forest E核芯片将率先推出,随后于今年第三季度推出高端Granite Rapids P核芯片:

明年第一季度,更强大的Sierra Forest芯片将与全球用户见面,其最多可提供288个核心,与其一道亮相的还有6300、6500和6700系列中的低端Granite Rapids芯片。Granite Rapids芯片还将推出SoC变体,估计大概率用于承载边缘用例,其中强大的核心及向量/矩阵数学单元能够从容应对AI推理负载。

英特尔之前从未推出过强大的Atom芯片,因此我们很难将其与现有至强SP及后续至强6高性能芯片直接比较。在演示中,英特尔倒是将Sierra Forest至强6 6700芯片同第二代至强SP处理器进行了比较,也就是代号“Cascade Lake”的那一款,当初是在2019年4月推出。根据英特尔公布的基准测试和我们自己的进一步分析,基本可以认定基于Atom的能效E核芯片每时钟指令数与Cascade Lake至强SP的整数算力大致相同。如果不相信,大家也自己算算:Sierra Forest中E核的性能约为Emerald Rapids P核的65%,所以对比下来结论基本可信。

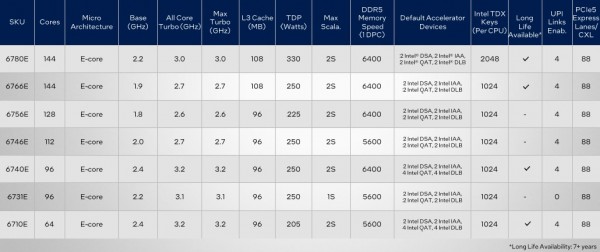

我们还将对至强6 6700E系列进行更深入的架构研究。从SKU堆栈来看,这是一套比较中庸的设计方案,只包含七种变体:

2025年第一季度,英特尔将通过双计算块加双I/O及内存控制器块将Sierra Forest芯片的性能提升一倍,这就是至强6 6900E。英特尔称其为ZCC封装,最多可容纳288个核心。

很明显,如果按照核心数量支付软件费用,那么能效E核版的芯片肯定得不到市场的认可。但如果大家选择自主编写微服务软件或者按服务器插槽计费,那么软件定价将不再是问题,而E核版本的至强6也将瞬间成为降低发热量、控制基础设施成本并实现合理吞吐能力的理想答案。

下面来看我们整理的性能与定价比较表,其中以2009年3月的四核版“Nehalem”至强E5500性能指标为基准。具体列出的则是各代处理器的核心数量、时钟速率以及每周期指令数(IPC)。

Emerald Rapids至强SP v5处理器的“性能通用”高端版本可提供8至64个核心,对应16至128条线程。根据我们的计算方法,其相对性能范围在5.85到27.78之间。按英特尔公布的1000托架采购量计算,其价格范围应该在1099美元到11600美元不等。Sierra Forest芯片不具备超线程设计,核心数量在64个到144个之间(因此只对应64到144条线程),价格则从2749美元到11350美元,相对性能范围为22.89至47.20——意味着其性价比较至强SP v5要高出19%到43%。换句话说,在功率恒定的情况下,Sierra Forest芯片可提供两倍的性能;而在性能恒定的情况下,其功率只相当于原本的一半。当然,这都是非常笼统粗糙的表述,仅供参考。

与Cascade Lake至强SP v2服务器CPU的比较结果同样有趣。代表2019年最顶尖水平的Cascade Lake拥有56个性能P核和112条线程,运行主频为2.6 GHz,可提供21.69个相对单元性能,但每单位性能成本超过了946美元。而2024年的低端Sierra Forest CPU则拥有64个能效E核,运行主频为2.4 GHz,相对性能为22.89,而每单元性能成本仅仅120美元左右。从性价比角度来看,意味着五年时间这款芯片将性价比提升至7.9倍。而且与Sierra Forest系列中的低端至强6 6710E处理器相比,顶级Cascade Lake处理器的功耗更是达到惊人的400瓦。

顶级Sierra Forest 6700E处理器的性能可达低端版本的两倍有余,单位性能成本也基本是两倍,因此与Cascade Lake顶配版本的比较优势就只剩下一半——但3.95倍同样是个不错的成绩。

在后续文章中,我们将进一步对Sierra Forest作出深层架构研究,同时对Granite Rapids展开分析和推测。更多内容敬请期待。

好文章,需要你的鼓励

Allen AI团队推出SAGE:首个能像人类一样“想看多长就看多长“的智能视频分析系统

Allen AI研究所联合多家顶尖机构推出SAGE智能视频分析系统,首次实现类人化的"任意时长推理"能力。该系统能根据问题复杂程度灵活调整分析策略,配备六种智能工具进行协同分析,在处理10分钟以上视频时准确率提升8.2%。研究团队创建了包含1744个真实娱乐视频问题的SAGE-Bench评估平台,并采用创新的AI生成训练数据方法,为视频AI技术的实际应用开辟了新路径。

联想推出DE6600系列:更智能的存储解决方案

联想推出新一代NVMe存储解决方案DE6600系列,包含全闪存DE6600F和混合存储DE6600H两款型号。该系列产品延迟低于100微秒,支持多种连接协议,2U机架可容纳24块NVMe驱动器。容量可从367TB扩展至1.798PiB全闪存或7.741PiB混合配置,适用于AI、高性能计算、实时分析等场景,并配备双活控制器和XClarity统一管理平台。

AI视觉模型真的能看懂长篇文档吗?中科院团队首次揭开视觉文本压缩的真相

中科院团队首次系统评估了AI视觉模型在文本压缩环境下的理解能力,发现虽然AI能准确识别压缩图像中的文字,但在理解深层含义、建立关联推理方面表现不佳。研究通过VTCBench测试系统揭示了AI存在"位置偏差"等问题,为视觉文本压缩技术的改进指明方向。

数智时代,openGauss Summit 2025即将发布哪些技术创新破局

“算力+储能”深度融合:超智算发布分布式算力超级节点储能解决方案

联想推出DE6600系列:更智能的存储解决方案

创业公司如何在严格监管行业中实现生死攸关的创新

OpenAI发布GPT-5.2-Codex模型,软件工程自动化能力大幅提升

Waterfox浏览器宣布拒绝AI功能,瞄准Firefox忠实用户

TikTok美国业务出售交易将于下月完成

破局AI数据中心安全瓶颈:Fortinet联合NVIDIA引领隔离式加速新航向

智算中心进化论,科华数据如何做到“更懂”

更高负载、更快建设:2026年数据中心六大趋势

Snowflake数据库更新引发全球大规模服务中断

AI编程初创公司Lovable融资3.3亿美元,英伟达等科技巨头支持