英特尔至强6新品发布,能为数据中心带来哪些改变? 原创

作者 | 金旺

来源 | 科技行者

近日,在MWC 2025前夕,英特尔正式对外发布了两款至强6系列处理器新品——英特尔至强6700/6500性能核处理器。

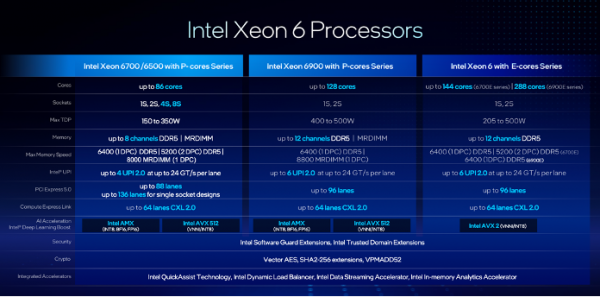

早在2024年,英特尔至强系列处理器首次对外区分能效核和性能核,并发布了英特尔至强6700能效核处理器和英特尔至强6900性能核处理器。

相较于去年英特尔发布的两款至强6系列处理器,此次发布的是从16核到86核的中端至强6系列处理器,是更适合主流数据中心应用的产品,也是英特尔目标服务于传统企业包括数据库、边缘计算、AI应用等更广泛应用的处理器产品。

英特尔临时联合首席执行官兼英特尔产品首席执行官Michelle Johnston Holthaus,“英特尔深耕数据中心市场数十余年,并通过x86 架构引领标准制定和行业发展,目前,英特尔的处理器正为绝大多数数据中心提供动力。”

作为长期在商用服务器领域占据主导地位的X86服务器关键处理器,同时也是AI服务器的CPU机头节点首选,此次至强6系列处理器新品面世,又将会为市场带来怎样的变化?

01 什么样的CPU,更适合主流数据中心?

2023年,我国数字经济规模达到53.9万亿元,占GDP比重为42.8%,据中商产业研究院预测数据显示,2024年我国数字经济占GDP比重将会进一步增长至44.6%。

数字经济规模不断扩大,外加人工智能技术的爆发,各行各业对新一代算力基础设施都提出了更高的需求。

作为全球算力核心供应商之一,英特尔在过去几年里一直是数据中心CPU的主要玩家,这次英特尔至强6系列处理器产品的问世,一些新的特性也随之更新。

首先是硬件性能更新。

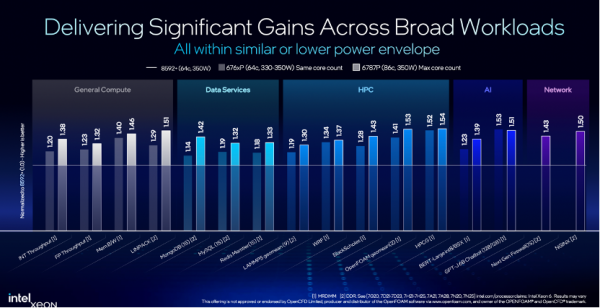

英特尔至强6700/6500性能核处理器最高拥有86个核心、350W功率,相较于上一代产品,在企业工作负载中可以实现平均1.4倍的性能提升。

据英特尔官方透露,虽然此次发布的英特尔至强6700/6500性能核处理器核心数不是最多的,但是它的目标更广泛,是为了面对主流数据中心,更好地服务传统企业数据中心广泛应用而设计,支持单路、双路、4路,甚至8路服务器设计。

例如,相较于高核高密度计算的大芯片,英特尔至强6700/6500性能核处理器150W-350W的TDP(热功耗)在内存通道上同样支持8个内存通道配置,支持AMX加速技术。

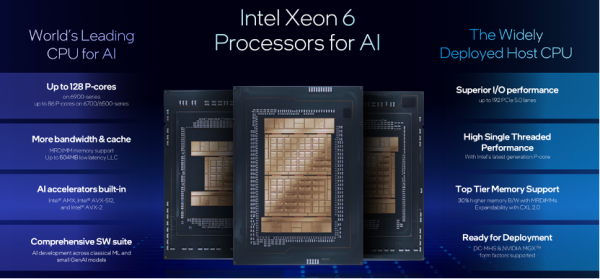

其次是对人工智能技术的支持。

早在大模型兴起之前,人工智能就已经广泛应用在数据中心中,例如搜索、推荐引擎等应用,很多国内互联网巨头都在使用英特尔至强处理来支持相关业务,这让英特尔在过往这些年里积累了不少诸如AMX这样的AI加速技术,这些技术是如今英特尔面向人工智能时代的优势所在。

此外,据英特尔数据中心与AI集团副总裁兼中国区总经理陈葆立透露,“在GPU服务器中,机头位置的CPU选择至关重要,英特尔至强系列处理器一直以来都是AI服务器CPU机头的首选,相较于市面上其他产品,至强6处理器在所需核心数减少三分之一的情况下,性能却可以高出50%。”

什么是服务器的“机头”?

所谓服务器的机头是指计算机网络中用于识别目标服务器的重要组件, 它可以根据特定规则和协议判断请求的目标服务器地址,并将请求转发给相应的服务器,起到路由和转发的作用。

陈葆立指出,“在处理大模型计算时,我们会关注提问后第一个回答的延迟时间,如果使用CPU处理,这一指标将与内存带宽密切相关。”

为了满足企业对于人工智能技术的普遍应用需求,英特尔至强6系列处理器首次引入了内存优化技术——MRDIMM。

这也是英特尔面向更广泛的企业应用需求引入的一项新技术。

02 人工智能推理,英特尔的思路

如今的人工智能技术就像十年前的云计算技术一样,已经成为了这个时代的确定性,这其中,在以生成式AI、大模型为代表的人工智能技术进入应用阶段后,AI推理的重要性逐渐凸显。

在2024年年底的NeurIPS 2024大会上,OpenAI前首席科学家Ilya Sutskever就曾指出,“大模型预训练时代已经结束,接下来更为重要的将会是智能体、推理、理解、自我意识推动的超级智能体。”

面对AI推理,CPU也就有了大用处。

英特尔技术专家指出,“我们发现,在小于20B参数规模的模型中,用至强处理器做AI推理有很大的优势。”

对于20B以内参数规模的大语言模型而言,在推理过程中,不仅会在生成首个token时需要进行密集的计算,在后续大多数token推理中,对内存带宽也有很高的要求。

于是,英特尔在至强6系列处理器中引入了用于内存优化的MRDIMM技术。

什么是MRDIMM?

MRDIMM是多路复用双列直插式内存模组,可以在单个通道上组合和传输多个数据信号,从而在无需额外物理连接的前提下提升带宽。

那么,这样的MRDIMM有怎样的魔力?

一个对比数据是,相比内存速度在4800-5600MT/s的英特尔第五代至强处理器,英特尔至强6处理器的内存速度已经提升到了6400MT/s,而在引入MRDIMM后,这个速度可以进一步被提升到8800MT/s。相较于当下市面上部署的数据中心服务器,内存速度提升达到50%以上。

除了MRDIMM,英特尔AMX是英特尔应对人工智能技术另一项沉淀下来的重要技术。

大模型在2023年火遍全球之前,推荐引擎、自然语言处理、图像处理、目标识别等人工智能技术场景都得益于英特尔AMX技术加持下的英特尔至强处理器。

在端到端的业务流程中,无论是传统的AI,还是现在的生成式AI,都对矢量数据库搜索有需求,这些需求在实际行业部署中得益于英特尔至强内置的AMX加速引擎,在同等核心数下,至强在矢量数据库离线构建索引表的过程中,性能相较行业中其他处理器提升了30%。

与此同时,人工智能技术的发展,也加大了企业对于安全性能的提升。

英特尔TDX是英特尔早在英特尔第四代至强处理器就已经引入的安全计算技术,它是一种基于硬件可信执行环境来部署信任域,信任域是硬件隔离的虚拟机,旨在保护敏感数据和应用程序免遭未经授权的访问。

在人工智能时代,异构系统越来越普及,企业对安全计算技术提出了更高的需求,希望英特尔可以和其他加速卡生产商一起联合构建一个不仅包含CPU,同时还包含GPU的硬件防护体系,于是就有了英特尔至强6处理器引入的TDX Connect技术。

据英特尔技术专家解释,“TDX Connect技术通过在系统中实现英特尔至强处理器和GPU的联合协作,构建一个整体的防护网。”

无论是放在CPU、业务入口上的数据,还是运行在GPU上的模型参数和数据,都能得到硬件防护,这就是TDX Connect技术为安全领域带来的一个显著变化。

这个变化,正是人工智能时代数据保护所特别需要的。

03 至强6 SoC如何为运营商提升能效?

在人工智能浪潮中,各行各业都在进行着悄然改变,这其中也包括网络连接方式和运维方式。

就在前不久,面对DeepSeek席卷全球,以及随之而来的一波人工智能的应用爆发,国内三大运营商迅速完成了DeepSeek的接入。

中信证券在随后的研报中指出,中国电信、中国联通、中国移动三大运营商纷纷宣布全面接入DeepSeek,通过各自的平台和资源实现了DeepSeek在多场景、多产品中的广泛应用,有望加速运营商云计算收入增长。

实际上,为了充分释放下一代网络连接技术的潜力,电信运营商正在积极采用网络切片、AI驱动的无线控制器和云原生架构等技术,接入DeepSeek只是电信运营商面对当下网络技术环境的一个积极求变的缩影。

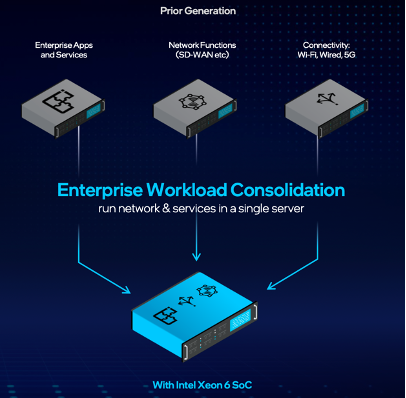

在此次发布会上,英特尔面向网络和边缘计算应用也发布了一款英特尔至强6系统级芯片(SoC)。

据英特尔中国网络与边缘事业部总经理阮伯超介绍称,“这款系统级芯片整合了不同的加速器,以提供更高性能和能效,专门面向运营商网络和边缘应用而设计。”

网络与边缘设备涉及的地区非常广泛,需兼顾计算密度、连接性能、功耗限制与物理尺寸的约束,与此同时,它们通常分布在不同位置,需要考虑到传输过程中的安全性。

据悉,英特尔至强6系统级芯片整合了,拥有72个核心,整合和了各种加速器,以及英特尔至强6性能核处理器其它诸多特性,具体包括以下三方面:

第一,Webroot CSI上传模型的推理速度大幅提升,相较于英特尔至强D-2899NT处理器,提升最高可达4.3倍;

第二,得益于vRAN Boost技术,单核AI RAN性能比上一代提升3.2倍;

第三,在视频边缘服务器上,一个38核系统可同时支持多达38路摄像头视频流的int8推理。

据阮伯超透露,“英特尔至强6系统级芯片已经被广泛运用到运营商网络以及网络与边缘当中。”

以运算网络为例,目前英特尔与诺基亚合作,基于英特尔至强6系统级芯片,诺基亚提升了70%的性能功耗比,帮助运营商提升了整体密度,带来高达2.4倍的无线接入网工作负载容量提升。

除此以外,英特尔本次还发布了实现了带宽翻倍、可以达到200GbE的吞吐量的以太网控制器E830和网络适配器,以及增加了控制功能、提升了可管理性的以太网控制器E610和网络适配器。

面对人工智能应用涌现的这一年,这些也将成为英特尔为电信运营商备战2025的新装备。

好文章,需要你的鼓励

不用再训练AI模型,香港科技大学团队发明“智能管家“,让AI一眼就知道该抓哪里用哪里

香港科技大学团队开发出A4-Agent智能系统,无需训练即可让AI理解物品的可操作性。该系统通过"想象-思考-定位"三步法模仿人类认知过程,在多个测试中超越了需要专门训练的传统方法。这项技术为智能机器人发展提供了新思路,使其能够像人类一样举一反三地处理未见过的新物品和任务。

YouTube推出基于Gemini 3的创作者游戏制作工具

YouTube Gaming宣布推出Playables Builder开放测试版,允许特定创作者使用基于Gemini 3的原型网页应用制作小型游戏,无需编程知识。该工具类似于Google Labs的Disco和GenTabs项目,通过自然语言输入生成交互式内容。尽管AI助手能帮助用户无需技术知识即可创作,但优秀游戏需要技巧、迭代和专业知识才能打造真正有趣的体验。

韩国KAIST让SVG动画脱胎换骨:AI如何破解矢量图形的“语义迷宫“让静态图标活起来

韩国KAIST开发的Vector Prism系统通过多视角观察和统计推理,解决了AI无法理解SVG图形语义结构的难题。该系统能将用户的自然语言描述自动转换为精美的矢量动画,生成的动画文件比传统视频小54倍,在多项评估中超越顶级竞争对手,为数字创意产业带来重大突破。

苹果发现:只需一个注意力层,就能让AI图像生成既快又好

YouTube推出基于Gemini 3的创作者游戏制作工具

英伟达是唯一能负担免费提供AI模型的厂商

OpenAI发布新旗舰图像生成AI模型GPT Image 1.5

脑启发算法可大幅降低AI能耗

Mac办公桌升级必备配件指南:提升工作效率的最佳选择

PTC Windchill+ 助力 HOLON研发全球首批符合汽车行业标准的 L4 级电动汽车

航旅行业的AI“乘法效应”:迈向指数级进化

OpenAI推出GPT Image 1.5模型加速图像生成竞争

Zoom推出AI Companion 3.0智能体工作流程

ChatGPT成为互联网最受阻止的爬虫机器人

英伟达推出开源权重模型填补美国AI市场空白