英特尔Gaudi 2D AI加速器为DeepSeek Janus Pro模型提供加速

近日,DeepSeek发布Janus Pro模型,其超强性能和高精度引起业界关注。英特尔® Gaudi 2D AI加速器现已针对该模型进行优化,这使得AI开发者能够以更低成本、更高效率实现复杂任务的部署与优化,有效满足行业应用对于推理算力的需求,为AI应用的落地和规模化发展提供强有力的支持。

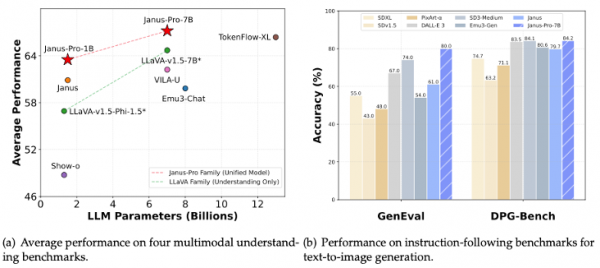

作为一款创新性的AIGC模型,DeepSeek Janus模型集成了多模态理解和生成功能。该模型首次采用统一的Transformer架构,突破了传统AIGC模型依赖多路径视觉编码的限制,实现了理解与生成任务的一体化支持。在此基础上,Janus Pro通过优化训练策略和扩展模型规模,显著提升了文生图等功能的性能与稳定性,并提供了10亿参数和70亿参数两个版本,在性能与精度上展现了较强的竞争力。

在Janus Pro统一的Transformer架构下,文生图模型的吞吐量高低已经从依赖加速器的高算力向充分利用HBM内存高带宽和大容量转换。英特尔® Gaudi 2D凭借 2.45TB/秒的高带宽和 96GB HBM大容量内存,为Janus Pro模型提供了强大的计算支持,使其在生图批处理任务中,随着批量大小(Batch Size)的增加,吞吐性能得到显著提升,大幅缩短任务处理时间。

与此同时,结合英特尔Optimum-Habana框架的优化,英特尔® Gaudi 2D显著提升了文生图任务的吞吐性能和推理效率,仅需约10秒即可生成16张高质量的图片,性能表现卓越。而且,开发者仅需调整数行代码,即可实现这一结果,极大降低了开发门槛和迁移成本,为 AI 应用的高效部署提供便利。

此外,DeepSeek的蒸馏模型在至强和Gaudi平台上也得到了支持,能够为客户创造更好的总体拥有成本(TCO),推动AI的普惠。

一直以来,英特尔始终秉承开放的态度,并通过软硬件相结合的方式推动AI应用落地。目前,英特尔丰富的AI产品组合,包括英特尔®至强®处理器、英特尔®酷睿™ Ultra处理器和英特尔锐炫™显卡等,已经针对业界超过500个开源AI模型提供支持,广泛涵盖DeepSeek、Llama 3.1和通义千问等。同时,英特尔深耕开放生态,不仅以开放生态系统软件实现针对性优化,也通过打造企业AI开放平台(OPEA)为这些模型提供支持。

好文章,需要你的鼓励

AI智能体漏洞挖掘成本骤降,Anthropic呼吁AI防御

Anthropic发布SCONE-bench智能合约漏洞利用基准测试,评估AI代理发现和利用区块链智能合约缺陷的能力。研究显示Claude Opus 4.5等模型可从漏洞中获得460万美元收益。测试2849个合约仅需3476美元成本,发现两个零日漏洞并创造3694美元利润。研究表明AI代理利用安全漏洞的能力快速提升,每1.3个月翻倍增长,强调需要主动采用AI防御技术应对AI攻击威胁。

NVIDIA联手多所高校推出SpaceTools:AI机器人有了“火眼金睛“和“妙手回春“

NVIDIA联合多所高校开发的SpaceTools系统通过双重交互强化学习方法,让AI学会协调使用多种视觉工具进行复杂空间推理。该系统在空间理解基准测试中达到最先进性能,并在真实机器人操作中实现86%成功率,代表了AI从单一功能向工具协调专家的重要转变,为未来更智能实用的AI助手奠定基础。

Spotify年度盘点2025首次推出多人互动功能“盘点派对“

Spotify年度总结功能回归,在去年AI播客功能遭遇批评后,今年重新专注于用户数据深度分析。新版本引入近十项新功能,包括首个实时多人互动体验"Wrapped Party",最多可邀请9位好友比较听歌数据。此外还新增热门歌曲播放次数显示、互动歌曲测验、听歌年龄分析和听歌俱乐部等功能,让年度总结更具互动性和个性化体验。

机器人学会“三思而后行“:中科院团队让AI机器人告别行动失误

这项研究解决了现代智能机器人面临的"行动不稳定"问题,开发出名为TACO的决策优化系统。该系统让机器人在执行任务前生成多个候选方案,然后通过伪计数估计器选择最可靠的行动,就像为机器人配备智能顾问。实验显示,真实环境中机器人成功率平均提升16%,且系统可即插即用无需重新训练,为机器人智能化发展提供了新思路。

AI智能体漏洞挖掘成本骤降,Anthropic呼吁AI防御

Spotify年度盘点2025首次推出多人互动功能"盘点派对"

英国SAP用户因商业套件重启授权迷局感到困惑

AWS发布Graviton5定制CPU,为云工作负载带来强劲性能

美光放弃Crucial品牌:告别消费级存储市场

手机里的NPU越来越强,为什么AI体验还在原地踏步?

如何使用现有基础设施让数据做好AI准备

IT领导者快问快答:思科光网络公司首席数字信息官Craig Williams分享AI转型经验

Anthropic CEO警告AI行业泡沫化,批评"YOLO"式投资

雅虎利用AI实时总结橄榄球比赛精彩内容

押注AI智能体,奇奇科技跨越十年的“换挡”与远航

联想天禧AI及创新终端设备在2025 AIE博览会获两项大奖,引领个人AI体验创新