业界首款液冷存储发布,曙光打造“存算一栈式”液冷方案

11月9日,在“2022中国数据与存储峰会”上,中科曙光发布业界首款液冷存储——曙光 ParaStor 液冷存储系统,开创性地将液冷技术与存储技术深度结合,填补了存储领域液冷产品的空白。

曙光 ParaStor 液冷存储系统发布仪式

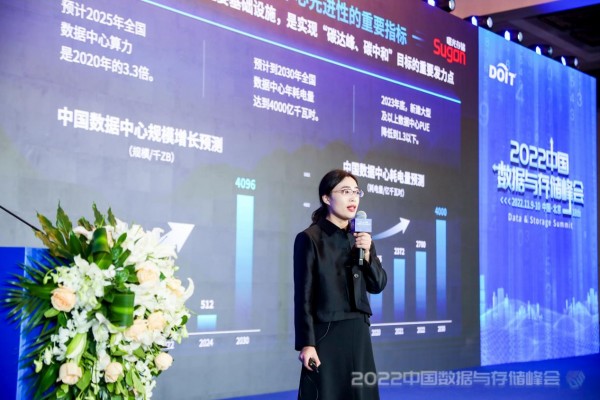

“在液冷逐步商业化的背景下,用户希望把液冷技术进一步扩展到存储系统上,市场对于液冷存储的需求日益迫切”,中科曙光存储事业部副总经理张新凤在峰会上介绍。

中科曙光存储事业部副总经理张新凤

曙光打造首款“软硬一体”液冷存储

曙光 ParaStor 液冷存储系统,继承了曙光20余年的技术优势,巧妙地将换热效率更高的冷板式液冷方案与存储技术结合,显著降低内存、HDD存储关键部件的工作温度,大幅降低散热功率。相比于风冷,液冷存储系统性能提升超过20%。

为了将“绿色”发挥到极致,曙光还对系统软件进行了深度优化,通过采用大比例纠删码、数据重删压缩、硬盘分区休眠、电源功耗精细化控制等技术,在保证容量和性能的基础上,充分提高存储资源利用率,最大限度降低存储系统功耗。

开创业内最全“存算一栈式”液冷方案

在应用层面,曙光 ParaStor 液冷存储系统灵活配置多种场景。针对高性能小规模应用场景,曙光ParaStor 液冷存储系统提供全闪存配置方案,而针对中大规模应用场景,则提供更高性价比的混闪配置方案,为客户释放更多的业务价值。

与曙光液冷服务器技术同源,为便于数据中心基础设施的统一规划、设计和共用,曙光 ParaStor 液冷存储系统可便捷、高效地与液冷服务器形成“存算一栈式”液冷方案,在提高运维效率的同时,助力数据中心部署更便捷。

冲击更低的PUE值

数据显示,存储系统的功耗约占数据中心IT设备系统总功耗的35%,仅次于服务器能耗,液冷存储是实现数据中心“深度绿色化”的关键一环,采用“存算一栈式”液冷方案,可将数据中心PUE值降至1.1以下。以EB级数据中心耗电量为例,采用液冷存储相比风冷存储,一年可节约450万度电量,减少1493吨CO2排放,支持2812个家庭的年度电量,相当于种植82957棵树。

“未来,曙光‘存算一栈式’液冷方案将助力数据中心实现更优PUE指标,为绿色数据中心建设带来新思路”张新凤展望道。

来源:至顶网计算频道

好文章,需要你的鼓励

SanDisk重塑经典SSD品牌:WD Black和Blue正式更名为Optimus系列

西部数据闪存业务分拆后,SanDisk宣布将停用广受欢迎的WD Black和Blue品牌,推出全新的SanDisk Optimus系列NVMe产品线。WD Blue驱动器将更名为SanDisk Optimus,而高端WD Black驱动器将分别更名为Optimus GX和GX Pro。尽管品牌变更,底层硬件和供应链保持不变。然而受全球内存短缺影响,预计2026年第一季度客户端SSD价格可能上涨超过40%。

上海AI实验室研究者想出妙招:让AI像优秀学生一样高效思考,告别“想太多“毛病

上海AI实验室开发RePro训练方法,通过将AI推理过程类比为优化问题,教会AI避免过度思考。该方法通过评估推理步骤的进步幅度和稳定性,显著提升了模型在数学、科学和编程任务上的表现,准确率提升5-6个百分点,同时大幅减少无效推理,为高效AI系统发展提供新思路。

福特汽车准备在车载系统中引入AI智能助手

福特汽车在2026年消费电子展上宣布将在车辆中引入AI助手技术。该AI助手最初将在福特和林肯智能手机应用中推出,从2027年开始成为新车型的原生功能。福特希望通过AI技术实现车辆个性化体验,提供基于位置、行为和车辆能力的智能服务。同时,福特将采用软件定义车辆架构,推出自研的高性能计算中心,提升信息娱乐、驾驶辅助等功能。

MIT团队让机器人终于不再“卡顿“:一种让机器人像人一样流畅反应的突破性技术

MIT团队开发的VLASH技术首次解决了机器人动作断续、反应迟缓的根本问题。通过"未来状态感知"让机器人边执行边思考,实现了最高2.03倍的速度提升和17.4倍的反应延迟改善,成功展示了机器人打乒乓球等高难度任务,为机器人在动态环境中的应用开辟了新可能性。

智能体驱动全球创新浪潮,微软携手前沿伙伴迈进消费电子新未来

达索系统在CES 2026上展示AI驱动的医疗创新, 重塑精准、可预测与个性化医疗

Arm 发布 20 项技术预测:洞见 2026 年及未来发

美光推出全球首款面向客户端计算的 PCIe 5.0 QLC SSD

SanDisk重塑经典SSD品牌:WD Black和Blue正式更名为Optimus系列

福特汽车准备在车载系统中引入AI智能助手

ChatGPT推出健康模式:结合医疗数据提供个性化建议

福特推出AI数字助理及新一代BlueCruise自动驾驶技术

联想Legion Pro可卷曲概念机展现移动大屏游戏新体验

印度和新加坡在智能体AI采用方面超越全球同行

华硕CES 2026新品:更小巧的ProArt GoPro笔记本和升级版Zenbook Duo

n8n警告CVSS满分漏洞影响自托管和云版本