Graphcore发布全球首款3D WoW处理器产品并公布超未来智能计算路线图

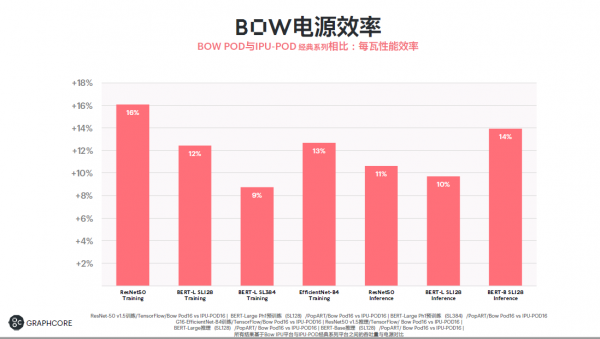

2022年3月3日,中国北京—— Graphcore® 今日正式发布全新IPU系统产品——Bow系列。Bow Pod系统产品采用了全球首款3D Wafer-on-Wafer处理器——Bow IPU。Bow IPU是新一代Bow Pod AI计算机系统的核心。与上代产品相比,它可为真实世界的AI应用提供高达40%的性能提升和16%的电源效率提升,同时价格保持不变,且无需更改现有代码。Bow的命名来源于伦敦市的一处地名。

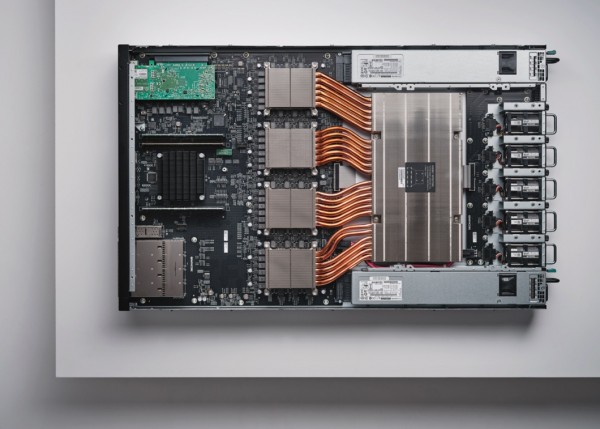

Bow IPU处理器

Bow-2000 计算刀片

同时,Graphcore将于2024年交付全球首台超级智能计算机—— Good ™ Computer(古德计算机)。Graphcore正在开发新一代IPU技术,为这款Good™ Computer提供超过10 Exa-Flops的AI浮点计算;最高可达4PB的存储,带宽超过10PB/秒;支持超过500万亿参数的AI模型;3D Wafer-on-Wafer逻辑栈;同时获得Poplar® SDK的完全支持。该计算机预计价格在100万美元至1.5亿美元(取决于配置)。这款超未来的智能计算机之所以被命名为Good,一方面是Graphcore致力于打造“好”的计算机,一方面是向计算机科学家先驱Jack Good(杰克·古德)致敬。

Graphcore大中华区总裁兼全球首席营收官卢涛表示:“随着AI计算市场的整体快速发展,客户需要兼顾性能、效率和可靠性的计算机系统。我们发布新一代IPU,正是为了支持全球技术开发者和创新者在AI计算领域取得新的技术突破,实现高质量发展。我们希望不断开拓IPU在中国的AI应用场景,通过IPU赋能高效AI计算,支持中国创新者不断推进机器智能的边界。”

Bow Pod的出色性能

旗舰产品Bow Pod256提供超过89 PetaFLOPS的AI计算,而超大规模Bow Pod1024可提供350 PetaFLOPS的AI计算,支持机器学习工程师在AI模型规模呈指数增长的情况下仍可领先一步,在机器智能领域取得新的技术突破。

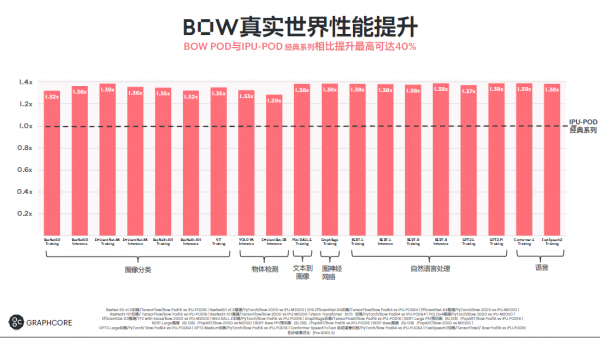

Bow Pod旨在为各种AI应用大规模提供真实世界的性能,从用于自然语言处理的GPT和BERT到用于计算机视觉的EfficientNet和ResNet,再到图神经网络和许多其他应用。

- 在与配有Bow Pod系统的Mk2 IPU-Pod系统相同的峰值功率范围内,客户发现各种AI应用的性能提升高达40%。

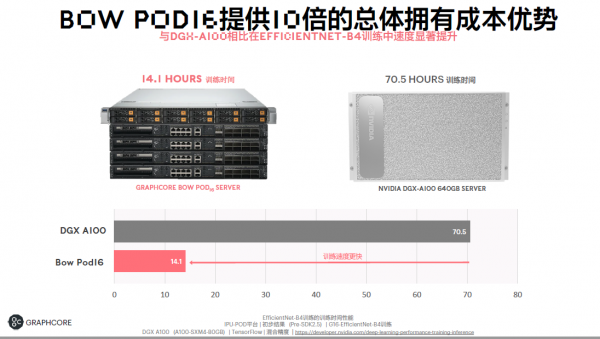

- 对于最先进的计算机视觉模型EfficientNet,Bow Pod16性能比同类Nvidia DGX A100系统提升5倍以上,而价格只有一半,因而总体拥有成本提升高达10倍。

- 与上代产品相比,除了40%的性能提升,Bow Pod系统还可以大幅提高电源效率。经过一系列实际应用测试表明,Bow Pod的每瓦性能最高可提升16%。

Wafer-on-Wafer创新技术

Bow Pod系统核心的Bow IPU处理器采用了全球首项3D半导体技术,从而支持Bow Pod 系统实现了巨大的性能提升和更高的电源效率。Wafer-on-Wafer 3D技术由Graphcore与台积电合作开发。Wafer-on-Wafer技术有潜力在硅片之间提供更高的带宽,从而优化电源效率,在晶圆级别提升Colossus架构的功率。

Bow IPU中的Wafer-on-Wafer,两个晶圆结合在一起,产生一个新的3D裸片。其中一个晶圆用于AI处理,在架构上与GC200 IPU处理器兼容,拥有1472个独立的IPU-Core tile,能够运行超过8800个线程,具有900MB的处理器内存储,而第二个晶圆拥有供电裸片。

通过在供电裸片中添加深沟槽电容器,位置在处理内核和存储旁,我们能够更高效地供电,从而实现350 TeraFLOPS的AI计算,实现40%的性能提升。通过与台积电紧密合作,我们充分验证了整套技术,包括背面硅通孔(BTSV)和Wafer-on-Wafer(WoW)混合键合中的多项突破性技术。

作为Bow Pod系统的组成部分,最新Bow-2000 IPU Machine采用了与第二代IPU-M2000 machine同样强大的系统架构,但现在配备了四个强大的Bow IPU处理器,可提供1.4 PetaFLOPS的AI计算。

Bow-2000可以完全向后兼容现有的IPU-POD系统,其高速、低时延的IPU结构和灵活的1U外形尺寸保持不变。Bow-2000是整个Bow Pod系列的基础组成部分。Bow-2000可安装在戴尔、Atos、Supermicro、浪潮和联想等领先品牌的主机服务器上,从而组成Bow Pod系统。整个Bow Pod系列包括Bow Pod16(4台Bow-2000和一台主机服务器)、Bow Pod32(8台Bow-2000和一台主机服务器)、Bow Pod64以及更大的旗舰系统Bow Pod256和Bow Pod1024。

最新Bow Pod系统现已上市,并开始在全球范围内发货。

来源:业界供稿

好文章,需要你的鼓励

联想推出DE6600系列:更智能的存储解决方案

联想推出新一代NVMe存储解决方案DE6600系列,包含全闪存DE6600F和混合存储DE6600H两款型号。该系列产品延迟低于100微秒,支持多种连接协议,2U机架可容纳24块NVMe驱动器。容量可从367TB扩展至1.798PiB全闪存或7.741PiB混合配置,适用于AI、高性能计算、实时分析等场景,并配备双活控制器和XClarity统一管理平台。

Allen AI团队推出SAGE:首个能像人类一样“想看多长就看多长“的智能视频分析系统

Allen AI研究所联合多家顶尖机构推出SAGE智能视频分析系统,首次实现类人化的"任意时长推理"能力。该系统能根据问题复杂程度灵活调整分析策略,配备六种智能工具进行协同分析,在处理10分钟以上视频时准确率提升8.2%。研究团队创建了包含1744个真实娱乐视频问题的SAGE-Bench评估平台,并采用创新的AI生成训练数据方法,为视频AI技术的实际应用开辟了新路径。

创业公司如何在严格监管行业中实现生死攸关的创新

两位创始人分享在医疗和殡葬等高度监管行业创业的经验。Enspectra Health历经近十年获得FDA认证推出皮肤成像设备,Earth Funeral则提供人体堆肥服务作为火化和土葬的替代方案。他们探讨了如何在等待监管审批期间进行产品迭代、如何规划资金周期,以及如何在投资者视为禁忌的领域获得风险投资。

AI视觉模型真的能看懂长篇文档吗?中科院团队首次揭开视觉文本压缩的真相

中科院团队首次系统评估了AI视觉模型在文本压缩环境下的理解能力,发现虽然AI能准确识别压缩图像中的文字,但在理解深层含义、建立关联推理方面表现不佳。研究通过VTCBench测试系统揭示了AI存在"位置偏差"等问题,为视觉文本压缩技术的改进指明方向。

“算力+储能”深度融合:超智算发布分布式算力超级节点储能解决方案

联想推出DE6600系列:更智能的存储解决方案

创业公司如何在严格监管行业中实现生死攸关的创新

OpenAI发布GPT-5.2-Codex模型,软件工程自动化能力大幅提升

Waterfox浏览器宣布拒绝AI功能,瞄准Firefox忠实用户

TikTok美国业务出售交易将于下月完成

破局AI数据中心安全瓶颈:Fortinet联合NVIDIA引领隔离式加速新航向

智算中心进化论,科华数据如何做到“更懂”

更高负载、更快建设:2026年数据中心六大趋势

Snowflake数据库更新引发全球大规模服务中断

AI编程初创公司Lovable融资3.3亿美元,英伟达等科技巨头支持

存储集成问题如何破坏基础设施自动化