Triton推理服务器06-安装用户端软件

在前面的文章中,已经带着读者创建好Triton的模型仓、安装并执行Triton推理服务器软件,接下来就是要安装Triton用户端软件,对服务器提出推理请求(requests),才能触发服务器执行推理计算的任务。

由于用户端的功能是在向服务器提出推理需求,本身并不参与计算,因此不用考虑设备性能或者是否装载GPU设备,即便是一台最基本的Windows上网本都能使用,只要安装合适的用户端软件就可以。

为了适应更多种使用场景,Triton用户端支持C++/Python/Java/GO等通用性高的在编程语言,底层还支持HTTP/REST与gRPC通讯协议,甚至还支持SSL/TLS加密选项,以及多种在线压缩(on-wire compression)算法,内容是相当丰富并且多元化,完整的内容可以在https://github.com/triton-inference-server/client开源仓里找到,本文只先提供Python用户端的部分。

与服务器的安装方式类似,NVIDIA提供以下4种安装方式:

- 源代码编译:

这种方式需要从https://github.com/triton-inference-server/client下载源代码,执行步骤在https://github.com/triton-inference-server/client#build-using-cmake环节,通常会遇到的麻烦是步骤繁琐,并且出错率较高,因此并不推荐使用这个方法。

- 可执行文件:

Triton开发团队为使用者提供编译好的可执行文件,包括Ubuntu 20.04、Jetpack余Windows平台,可以在https://github.com/triton-inference-server/server/releases/ 上获取,每个版本都会提供对应NGC容器的版本,如下图:

然后到下面的“Assets”选择合适的版本:

以装载Jetpack 5的Orin为例,就下载tritonserver2.26.0-jetpack5.0.2.tgz(1.13GB) 压缩文件到本机上,然后解压缩到指定目录下就可以,例如${HOME}/triton目录,会生成<backends>、<bin>、<clients>、<include>、<lib>、<qa>等6个目录,用户端的可执行文件在<clients/bin>目录下,目前有将近30个终端功能。

现在要使用image_client这个最基础的识别终端软件,对qa/images/mug.jpg(如下图)这张图片进行推理。

请先确认Triton服务器软件已经启动并且处于等待请求的状态,现在请开启另一个命令终端,输入以下指令提交推理请求:

|

$ $ |

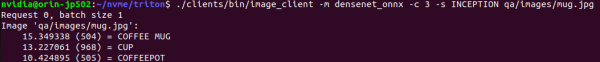

cd ${HOME}/triton ./clients/bin/image_client -m densenet_onnx -c 3 -s INCEPTION qa/images/mug.jpg |

这道指令使用clients/bin/image_client终端,请求服务器使用densenet_onnx推理模型,对qa/images/mug.jpg(图下图)进行识别。这里的参数“-c 3”是要求识别的分类最多可以到3项,指令执行结果如下,表示正确识别图像的3个可能分类:

其他终端软件会在后面文章中说明。

- Docker容器版用户端:

在安装Triton服务器软件一文中已经提过,可以在NGC服务器上可以找到Triton的相关镜像,其中year-xy-py3-sdk里就有提供用户端软件。这里同样在Jetson AGX Orin上用22.09-py3-sdk镜像做示范,请先执行以下指令下载这个镜像并进入这个容器:

|

$ $ |

docker pull nvcr.io/nvidia/tritonserver:22.09-py3-sdk docker run -it --rm --net=host nvcr.io/nvidia/tritonserver:22.09-py3-sdk |

进入容器之后,执行以下指令进行图像推理任务:

|

$ |

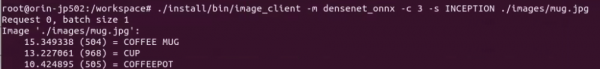

./install/bin/image_client -m densenet_onnx -c 3 -s INCEPTION ./images/mug.jpg |

执行结果应该会看到如下截屏的内容,表示在这里对Triton服务器提出的推理请求,得到正确的计算结果。

同样的,在容器内install/bin目录下也有将近30个编译好的终端可执行文件,内容与前一项压缩文件所提供的内容是一致的,在下一篇文章中进行说明。

- Python版用户端:

由于Python是目前在深度学习领域中最重要的编程语言之一,NVIDIA为Triton提供可直接安装的Python库,只要执行以下指令就能轻松安装:

|

$ |

pip3 install tritonclient[all] attrdict -i https://pypi.tuna.tsinghua.edu.cn/simple |

这个过程会安装以下内容:

- http

- grpc [ service_pb2, service_pb2_grpc, model_config_pb2]

- utils [ Linux 发行版将包括 shared_memory 和 cuda_shared_memory]

如果您在前面下载第2部分的压缩文件并且解压缩,在该目录之下的clients/python里就提供30多个Triton的Python用户端脚本;如果没有下载前面的压缩文件,现在可以之下以下指令去复制Triton项目的client开源仓:

|

$ |

git clone https://github.com/triton-inference-server/client |

然后在client开源仓下的src/python/examples里有30多个Triton的Python用户端脚本。

现在进到Python用户端脚本的目录里,执行以下指令:

|

$ |

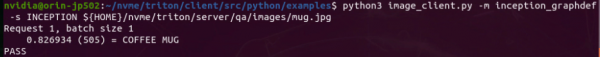

python3 image_client.py -m inception_graphdef -s INCEPTION ${HOME}/triton/server/qa/images/mug.jpg |

执行后会显示如下的结果:

得到推理的结果为“COFEE MUG”为正确的,表示Triton的Python用户端使用环境是正确的。

以上介绍4种安装Triton用户端软件的方式,本文只使用image_client这个最简单的图像分类用户端工具,另外还有几个比较重要的用户端工具,后面会有针对性的深入讲解与示范。【完】

来源:业界供稿

好文章,需要你的鼓励

Aqara智能门锁U400发布:支持Apple Wallet全自动解锁

绿米推出智能门锁U400,采用超宽带技术检测携带iPhone或Apple Watch的用户实现全自动解锁。该产品支持苹果钱包添加家庭钥匙,兼容Siri语音控制。除UWB解锁外,还提供实体钥匙、指纹识别、密码等多种开锁方式。基于Thread协议需配合兼容设备使用,要求iPhone 11及以上版本或Apple Watch Series 6及以上。售价270美元,现已在美国等地上市。

剑桥大学突破性研究:如何让AI在对话中学会真正的自信判断

剑桥大学研究团队首次系统探索AI在多轮对话中的信心判断问题。研究发现当前AI系统在评估自己答案可靠性方面存在严重缺陷,容易被对话长度而非信息质量误导。团队提出P(SUFFICIENT)等新方法,但整体问题仍待解决。该研究为AI在医疗、法律等关键领域的安全应用提供重要指导,强调了开发更可信AI系统的紧迫性。

AI代码编辑器扩展推荐漏洞引发供应链安全风险

热门AI驱动的VS Code衍生工具如Cursor、Windsurf等被发现推荐Open VSX注册表中不存在的扩展程序,为恶意攻击者发布同名恶意软件包创造机会。这些IDE继承了微软扩展市场的官方推荐列表,但这些扩展在Open VSX中并不存在。攻击者可利用此漏洞上传恶意扩展,当开发者安装推荐扩展时可能导致敏感数据泄露。

威斯康星大学研究团队破解洪水监测难题:AI模型终于学会了“眼观六路“

威斯康星大学研究团队开发出Prithvi-CAFE洪水监测系统,通过"双视觉协作"机制解决了AI地理基础模型在洪水识别上的局限性。该系统巧妙融合全局理解和局部细节能力,在国际标准数据集上创造最佳成绩,参数效率提升93%,为全球洪水预警和防灾减灾提供了更准确可靠的技术方案。

AI代码编辑器扩展推荐漏洞引发供应链安全风险

身份暗物质威胁企业网络安全的新挑战

Ambiq推出首款能耗优化NPU芯片组,为电池设备带来先进AI能力

英伟达推出AI推理上下文NVMe SSD存储解决方案

Infinidat最新升级让勒索软件攻击者胆寒

Lightricks-2 AI视频模型实现设备端运行突破

微软收购Osmos数据平台,强化Fabric智能数据工程能力

微软Excel股票历史功能新年故障,用户纷纷寻找替代方案

Infinidat最新升级让勒索软件攻击者不寒而栗

Commonwealth Fusion Systems完成首个反应堆磁体安装并与英伟达达成合作

宏碁游戏产品线扩展平价硝基系列,推出全新显示面板

DayOne数据中心获得20亿美元C轮融资,推进全球建设计划