Triton推理服务器02-功能与架构简介

前面文章介绍微软Teams会议系统、微信软件与腾讯PCG服务三个Triton推理服务器的成功案例,让大家对Triton有初步的认知,但别误以为这个软件只适合在大型的服务类应用中使用,事实上Triton能适用于更广泛的推理环节中,并且在越复杂的应用环境中就越能展现其执行成效。

在说明Triton推理服务器的架构与功能之前,我们需要先了解一个推理服务器所需要面对并解决的问题。

与大部分的服务器软件所需要的基本功能类似,一个推理服务器也得接受来自不同用户端所提出的各种要求(request)然后做出回应(response),并且对系统的处理进行性能优化与稳定性管理。

但是推理计算需要面对深度学习领域的各式各样推理模型,包括图像分类、物件检测、语义分析、语音识别等不同应用类别,每种类别还有不同神经网络算法与不同框架所训练出来的模型格式等。此外,我们不能对任务进行单纯的串行队列(queue)方式处理,这会使得任务等待时间拖得很长,影响使用的体验感,因此必须对任务进行并行化处理,这里就存在非常复杂的任务管理技巧。

下面列出一个推理服务器所需要面对的技术问题:

- 支持多种模型格式:至少需要支持普及度最高的

- TensorFlow的GraphDef与SavedMode中一种以上格式;

- PyTorch的TorchScript格式;

- ONNX开放标准格式;

- 其他:包括自定义模型格式;

- 支持多种查询类型,包括

- 在线的实时查询:尽量降低查询的延迟(latency)时间;

- 离线的批量处理:尽量提高查询的通量(throughput)

- 流水线传输的识别号管理等工作;

- 支持多种部署方式:包括

- 企业的GPU或CPU计算设备;

- 公共云或数据中心:

- 对模型进行最佳缩放处理:让个别模型提供更好的性能;

- 优化多个KPI:包括

- 硬件利用率;

- 模型推理识别时间;

- 总体成本(TCO);

- 提高系统稳定性:需监控模型状态并解决问题以防止停机。

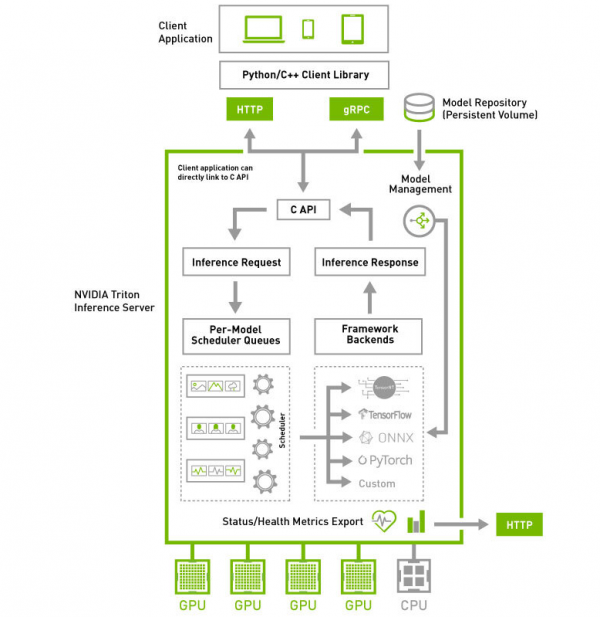

在了解推理服务器所需要解决的关键问题之后,接着来看看下方的Triton系统高阶架构图,就能更清楚每个板块所负责的任务与使用的对应技术。

Triton推理服务器采用属于“主从(client-server)”架构的系统,由图中的四个板块所组成:

- 模型仓(Model Repostory):存放Triton服务器所要使用的模型文件与配置文件的存储设备,可以是本地服务器的文件系统,也可以使用Google、AWS、Azure等云存储空间,只要遵循Triton服务器所要求的规范就可以;

- 客户端应用(Client Application):基于Triton用户端Python/C++/Java库所撰写,可以在各种操作系统与CPU架构上操作,对Triton服务器提交任务请求,并且接受返回的计算结果。这是整个Triton推理应用中代码量最多的一部分,也是开发人员需要花费最多心思的部分,在后面会有专文讲解。

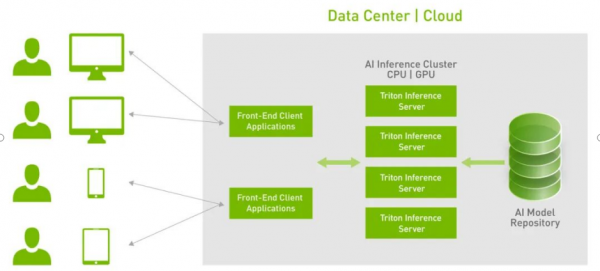

- HTTP/gPRC通讯协议:作为用户端与服务端互动的通讯协议,开发人员可以根据实际状况选择其中一种通讯协议进行操作,能透过互联网对服务器提出推理请求并返回推理结果,如下图所示:

使用这类通讯协议有以下优点:

-

- 支持实时、批处理和流式推理查询,以获得最佳应用程序体验;

- 提供高吞吐量推理,同时使用动态批处理和并发模型执行来满足紧张的延迟预算;

- 模型可以在现场制作中更新,而不会中断应用程序;

- 推理服务器(Inference Server):这是整个Triton服务器最核心且最复杂的部分,特别在“性能”、“稳定”、“扩充”这三大要求之间取得平衡的管理,主要包括以下几大功能板块:

- C开发接口:

在服务器内的代码属于系统底层机制,主要由NVIDIA系统工程师进行维护,因此只提供性能较好的C开发接口,一般应用工程师可以忽略这部分,除非您有心深入Triton系统底层进行改写;

-

- 模型管理器(Model Management):

支持多框架的文件格式并提供自定义的扩充能力,目前已支持TensorFlow的GraphDef与SavedModel格式、ONNX、PyTorch TorchScript、TensorRT、用于基于树的RAPIDS FIL模型、OpenVINO等模型文件格式,还能使用自定义的Python/C++模型格式;

-

- 模型的推理队列调度器(Per-Model Scheduler Queues):

将推理模型用管道形式进行管理,将一个或多个模型的预处理或后处理进行逻辑排列,并管理模型之间的输入和输出张量的连接,任何的推理请求都会触发这个模型管道。这部分还包含以下两个重点:

- 并发模型执行(Concurrent Model Execution):允许同一模型的多个模型和/或多个实例在同一系统上并行执行,系统可能有零个、一个或多个GPU。

- 模型和调度程序(Models And Schedulers):支持多种调度和批量处理算法,可为每个模型单独选择无状态(stateless)、有状态(stateful)或集成(ensemble)模式。对于给定的模型,调度器的选择和配置是通过模型的配置文件完成的。;

-

- 计算资源的优化处理:

这是作为服务器软件的最重要工作之一,就是要将设备的计算资源充分调度,并且优化总体计算性能,主要使用以下三种技术。

- 支持异构计算模式:可部署在纯x86与ARM CPU的计算设备上,也支持装载NVIDIA GPU的计算设备:

- 动态批量处理(Dynamic batching)技术:对支持批处理的模型提供多个内置的调度和批处理算法,并结合各个推理请求以提高推理吞吐量,这些调度和批量处理决策对请求推理的客户端是透明的。

- 批量处理推理请求分为客户端批量处理和服务器批量处理两种,通过将单个推理请求组合在一起来实现服务器批处理,以提高推理吞吐量;

- 构建一个批量处理缓存区,当达到配置的延迟阈值后便启动处理机制;

- 调度和批处理决策对请求推断的客户机是透明的,并且根据模型进行配置。

- 并发模型(Concurrent model)运行:多个模型或同一模型的多个实例,可以同时在一个GPU或多个GPU上运行,以满足不同的模型管理需求;

-

- 框架后端管理器(Framework Backends):

Triton的后端就是执行模型的封装代码,每种支持的框架都有一个对应的后端作为支持,例如tensorrt_backend就是支持TensorRT模型推理所封装的后端、openvino_backend就是支持openvine模型推理所封装的后端,目前在Triton开源项目里已经提供大约15种后端,技术人员可以根据开发无限扩充。

要添加一个新的后台是相当复杂的过程,因此在本系列文章中并不探索,这里主要说明以下Triton服务器对各个后端的管理机制,主要是以下重点:

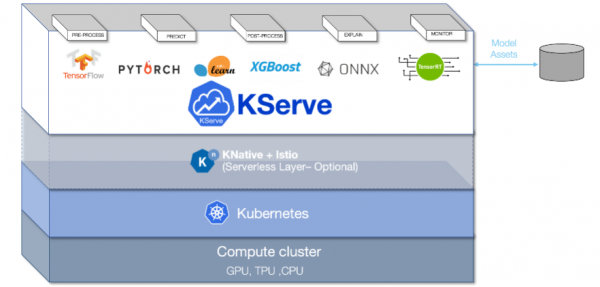

- 采用KFServing的新社区标准gRPC和HTTP/REST数据平面(data plane)v2协议(如下图),这是Kubernetes上基于各种标准的无服务器推理架构;

- 通过配置自动化和自动扩展简化Kubernetes中的推理服务部署;

- 透明地处理负载峰值,即使请求数量显着增加,请求的服务也将继续顺利运行;

- 可以通过定义转换器,轻松地将标记化和后处理等预处理步骤包含在部署中;

- 可以用NGC的Helm命令在Kubernetes中部署Triton,也可以部署为容器微服务,为GPU和CPU上的预处理或后处理和深度学习模型提供服务,也能轻松部署在数据中心或云平台上;

- 将推理实例进行微服务处理,每个实例都可以在Kubernetes环境中独立扩展,以获得最佳性能;

- 通过这种新的集成,可以轻松地在Kubernetes使用Triton部署高性能推理。

以上是Triton推理服务器的高级框架与主要特性的简介,如果看完本文后仍感觉有许多不太理解的部分,这是正常的现象,因为整个Triton系统集成非常多最先进的技术在内,并非朝夕之间就能掌握的。

后面的内容就要进入Triton推理服务器的环境安装与调试,以及一些基础范例的执行环节,透过这些实际的操作,逐步体验Triton系统的强大。【完】

来源:业界供稿

好文章,需要你的鼓励

Aqara智能门锁U400发布:支持Apple Wallet全自动解锁

绿米推出智能门锁U400,采用超宽带技术检测携带iPhone或Apple Watch的用户实现全自动解锁。该产品支持苹果钱包添加家庭钥匙,兼容Siri语音控制。除UWB解锁外,还提供实体钥匙、指纹识别、密码等多种开锁方式。基于Thread协议需配合兼容设备使用,要求iPhone 11及以上版本或Apple Watch Series 6及以上。售价270美元,现已在美国等地上市。

剑桥大学突破性研究:如何让AI在对话中学会真正的自信判断

剑桥大学研究团队首次系统探索AI在多轮对话中的信心判断问题。研究发现当前AI系统在评估自己答案可靠性方面存在严重缺陷,容易被对话长度而非信息质量误导。团队提出P(SUFFICIENT)等新方法,但整体问题仍待解决。该研究为AI在医疗、法律等关键领域的安全应用提供重要指导,强调了开发更可信AI系统的紧迫性。

AI代码编辑器扩展推荐漏洞引发供应链安全风险

热门AI驱动的VS Code衍生工具如Cursor、Windsurf等被发现推荐Open VSX注册表中不存在的扩展程序,为恶意攻击者发布同名恶意软件包创造机会。这些IDE继承了微软扩展市场的官方推荐列表,但这些扩展在Open VSX中并不存在。攻击者可利用此漏洞上传恶意扩展,当开发者安装推荐扩展时可能导致敏感数据泄露。

威斯康星大学研究团队破解洪水监测难题:AI模型终于学会了“眼观六路“

威斯康星大学研究团队开发出Prithvi-CAFE洪水监测系统,通过"双视觉协作"机制解决了AI地理基础模型在洪水识别上的局限性。该系统巧妙融合全局理解和局部细节能力,在国际标准数据集上创造最佳成绩,参数效率提升93%,为全球洪水预警和防灾减灾提供了更准确可靠的技术方案。

AI代码编辑器扩展推荐漏洞引发供应链安全风险

身份暗物质威胁企业网络安全的新挑战

Ambiq推出首款能耗优化NPU芯片组,为电池设备带来先进AI能力

英伟达推出AI推理上下文NVMe SSD存储解决方案

Infinidat最新升级让勒索软件攻击者胆寒

Lightricks-2 AI视频模型实现设备端运行突破

微软收购Osmos数据平台,强化Fabric智能数据工程能力

微软Excel股票历史功能新年故障,用户纷纷寻找替代方案

Infinidat最新升级让勒索软件攻击者不寒而栗

Commonwealth Fusion Systems完成首个反应堆磁体安装并与英伟达达成合作

宏碁游戏产品线扩展平价硝基系列,推出全新显示面板

DayOne数据中心获得20亿美元C轮融资,推进全球建设计划