Jetson Nano 2GB 系列文章(15):Hello AI World 环境安装

上一篇系列文章向大家介绍了 Hello AI World。接下来的这篇文章将讲述 Hello AI World 的环境安装。

首先进入项目网页 https://github.com/dusty-nv/jetson-inference,在系统安装(System Setup)处里有三个部分:

- Setting up Jetson with JetPack

- Running the Docker Container

- Building the Project from Source

第一个部分 “安装 Jetpack” 已经在上一篇系列文章中讲解地非常清楚,因此可以忽略不管;第二个部分 “执行Docker 容器版本”,考虑到大部分初学者对 Docker 比较陌生,如果熟悉 Docker 应用技巧的人,可以自行进入下载合适的版本去使用,本文不做说明。第三个部分是标准的安装流程,也是通用性最高的方法,本文将讲述以这个方式为主进行的安装。在安装过程中需要下载实验中需要用到的一些网络模型,全部合计共 4.7GB 容量,当然也可以只下载系统预设的 2.7GB 容量的模型,因此整个实验建议只是保留 4~6GB 的存储空间给这个项目使用。

现在就开始整个项目的安装流程,按照官网的编译版安装流程,请在 Jetson 设备上打开一个终端,然后执行以下指令:

$ sudo apt-get update

$ sudo apt-get -y install git cmake libpython3-dev python3-numpy

$ git clone --recursive https://github.com/dusty-nv/jetson-inference

$ cd jetson-inference

$ mkdir build && cd build

$ cmake ../

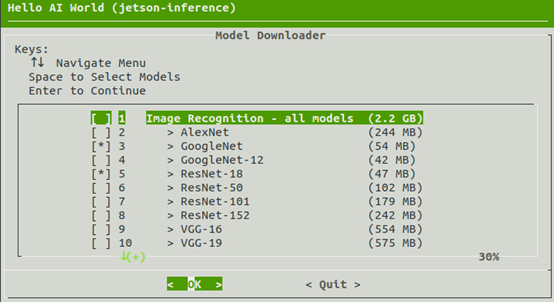

到这个步骤时,由于会执行 “预训练模型下载”与 “ Pytorch 安装”这两个步骤,前一个步骤会跳出一个对话框(如下图),系统预设定选择的模型总共约 2.7GB 容量,您也可以自行调整要下载的内容。

选择 <OK> 之后就开始下载,由于这些由 NVIDIA 预训练好的模型,都存放在国外原厂的网盘空间位置,国内下载可能会受到网速的影响,这部分请自行解决。

这个步骤执行之后,接着会跳出下一个画面,表示要为系统安装 Pytorch 框架,这个部分是为了做模型训练(training)用的,建议也选择执行。

这两个步骤所耗费的时间是最久的,也是无法预测的,请自行处理。

如果前面 Download Models 步骤中,没有将全部模型都下载的话,后面想要使用未下载的模型时,只要到 tools 目录下面执行 download-models.sh 即可,完整指令如下:

$ cd ~/jetson-inference/tools

$ ./download-models.sh

接下来就要开始编译并安装 jetson-inference 项目的代码,如果前面的步骤没有跳到别的地方的话,现在应该在 <~/jetson-inferecne/build> 目录下,前一个步骤 “cmake ..” 指令会在这个目录建立接下来编译所需要的 Makefile 配置文件,检查一下,如果有这个文件就表示可以继续进行下面步骤,全部编译的时间在 Jetson Nano 大约 3 分钟就能完成。

$ make -j$(nproc) # 使用 -j$(nproc)可以最大限度使用 CPU 核,加速编译

$ sudo make install # 要将编译结果写入系统文件夹所以需要用 sudo

$ sudo ldconfig # 立即让编译的结果生效

编译完成之后,可以用 video-viewer 这个工具来简单测试一下,您可以选择以下三种方式的任何一种,测试 jetson-inference 系统安装状况:

# 如果有装上 CSI 摄像头,请执行以下指令,预设输入源就是 CSI 摄像头

$ video-viewer

# 如果有装上 USB 摄像头,在 video-viewer 后面接上 USB 摄像头编号上

$ video-viewer/dev/video1

# 如果还没装上任何一个摄像头,可以用视频文件来测试

$ video-viewer test.mp4

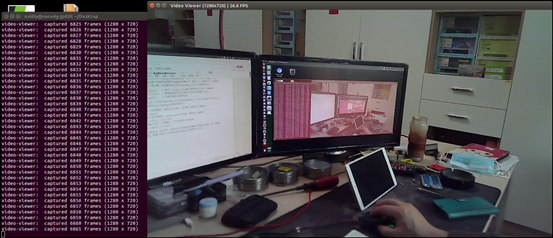

只要能正常执行(如下图),就表示这个开源项目的编译与安装是正常的。

以上就是本篇文章的内容,接下去就要开始按部就班,带着大家进一步开始 Hello AI World 的深度学习之旅。

来源:业界供稿

好文章,需要你的鼓励

ServiceNow斥资10亿美元收购Veza 加速智能体权限管理

ServiceNow宣布将以超过10亿美元收购身份安全平台Veza,这是该公司2025年一系列AI和数据重点收购的最新举措。此次收购正值企业加速部署AI代理之际,而如何管理这些非人类身份的访问权限和输出已成为普遍难题。该交易将为ServiceNow的AI控制塔提供关键的身份治理能力,帮助企业建立统一的控制平面来定义上下文相关的权限、监控代理行为并大规模执行最小权限访问策略。

达尔豪斯大学团队重磅研究:为什么AI社会模拟需要从“沙盒游戏“升级为“开放世界“?

达尔豪斯大学研究团队系统性批判了当前AI多智能体模拟的静态框架局限,提出以"动态场景演化、智能体-环境共同演化、生成式智能体架构"为核心的开放式模拟范式。该研究突破传统任务导向模式,强调AI智能体应具备自主探索、社会学习和环境重塑能力,为政策制定、教育创新和社会治理提供前所未有的模拟工具。

除英伟达和台积电外,其他AI公司都需要靠量补利

在生成式AI热潮中,只有英伟达和台积电真正赚到钱,其他AI产业链公司要么亏损要么利润被稀释。博通虽然在数据中心网络领域有不错的利润率,但为了不被AI浪潮抛弃,也选择进入AI业务。博通拥有730亿美元的AI积压订单,但被迫成为AI系统集成商,进一步稀释利润。第四季度博通收入180亿美元,同比增长28.2%,AI芯片收入达65亿美元。

HSE大学团队发布新成果:让AI图像生成快十倍的“超级加速器“技术

HSE大学研究团队开发出革命性的AI图像生成加速技术——广义对抗求解器(GAS),能将传统需要几十个计算步骤的图像生成过程压缩至4-6步,速度提升十倍而质量几乎不变。该技术通过重新设计求解器架构和引入对抗性训练,在多个数据集上验证了显著的性能提升,为AI图像生成技术的普及应用奠定了重要基础。

除英伟达和台积电外,其他AI公司都需要靠量补利

2025年数据中心芯片领域最热门发展趋势

自动化技术领导者揭示企业对AI认知的关键误区

五分之三企业对Wi-Fi投资信心增强

CIO部署新兴技术指南:Gartner三步法平衡风险与收益

埃森哲与Anthropic合作引领AI集成商崛起之路

Pure Storage和华为存储增长最快,IDC第三季度报告显示

英特尔或以16亿美元收购AI推理芯片初创公司SambaNova

5D记忆晶体将成为未来数据存储主流技术

首届全国独角兽企业大赛总决赛在甬顺利闭幕

为全天候绿电而生,海辰储能发布全球首个原生8小时长时储能解决方案

为AI+而生,海辰储能发布全球首款锂钠协同AIDC全时长储能解决方案