NVIDIA Jetson Nano 2GB 系列文章(14):Hello AI World

在本系列上一篇文章中,给大家介绍了 face_recognition 库的身份识别功能。接下来,我们将用几篇文章为读者讲解 NVIDIA 的 Jetson-inference,这个对于初学者尤为实用。本篇文章就来为大家介绍 Hello AI World。

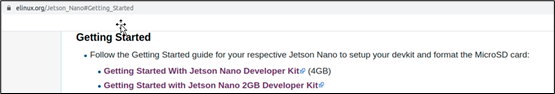

要使用 NVIDIA Jetson Nano 边缘计算设备,就一定要先熟悉官方所提供的入门教程,在 https://elinux.org/Jetson_Nano#Getting_Started 即可找到。(如下图)

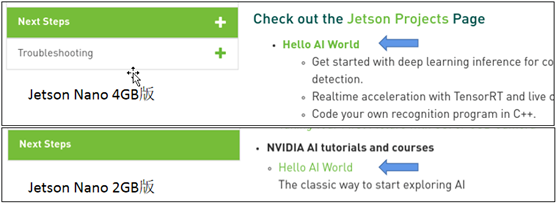

在 Nano 4GB 版与 2GB 版的教程目录中,最下方的 “Next Step”(如下图)都推荐使用者去 “Hello AI World” 项目进行体验。

按照过去的经验,所有应用的 “Hello World” 都只是简单地打印一条信息而已,验证系统是否已经正常安装,其实并无其他意义。

但是 NVIDIA “Hello AI World” 却与之不同,其不仅包含视觉类深度学习的三大主流推理应用:图像分类、物件检测、语义分割,最重要的还在于以下三点:

1. 本项目是开源的,包括 C++ 版本源代码与 Python 版本的源代码

2. 本项目提供非常高阶的接口,重点 API 只有以下 5 个:

(1) imageNet():用来处理图像分类的推理识别计算

(2) detectNet():用来处理物件检测的推理识别计算

(3) segNet():用来处理语义分割的推理识别计算

(4) videoSource():集成 7 种数据源输入类型与 16 种数据格式

(5) videoOutput():集成 5 种输出类型与 16 种数据格式

3. 本项目非常高效地调用了 NVIDIA Jetson 的硬件计算资源,提供了非常优异的性能:(1) imageNet()、detectNet() 与 segNet() 三种推理计算,都自动调用 TensorRT 加速引擎,展现出了非常优异的性能,在 Jetson Nano 上都能得到 20FPS 以上的实时性能。

(2) videoSource() 与 videoOutput() 这两个负责输入/输出的函数,自动调用 Jetson 上的 NVENC / NVDEC 这些硬解码芯片的功能,协助处理视频编解码时的计算,此外也使用高阶技巧,将许多标准的图像处理计算,包括放大/缩小、旋转、颜色空间转换、FFT 计算等,全部有效调用上百个 CUDA 计算核来处理,让整个输入/输出部分变得非常流畅。

因此,本系列的内容,就是对 “Hello AI World” 做深入的挖掘,让大家不仅能够轻松体验 Jetson 设备的深度学习识别性能,更希望大家能够利用好这些已经编译好的库,去开发自己的专属应用。

接下来将正式进入 “Hello AI World” 项目,事实上点击链接之后,就会进入到 Github 的一个仓(repository),链接地址为 https://github.com/dusty-nv/jetson-inference ,首页部分会看到如下面的图片。

在 “Table of Contents” 下面的 “Hello AI World” 的列表,是本系列的主题内容,主要包括“系统安装(System Setup)”、“推理识别(inference)” 与 “模型训练(Training)” 三大部分,由于内容十分丰富,因此需要按部就班地针对个别细节,引导使用者逐步熟悉并掌握深度学习三大应用的技巧。

接下来列出 Hello AI World 项目内容:

1. 系统设置(System Setup)

- 使用 JetPack 设置 Jetson

- 运行 Docker 容器

- 从源代码构建项目

2. 推理识别(Inference)

- 用 ImageNet 对图像进行分类 - 在 Jetson 上使用 ImageNet 程序 - 编写自己的图像识别程序(Python) - 编码自己的图像识别程序(C++) - 运行实时摄像机识别演示

- 用 DetectNet 定位物体- 从图像中检测对象- 运行实时摄像头检测演示- 编写自己的目标检测程序

- 基于 SegNet 的语义切分- 从命令行分割图像- 运行实时摄像机分割演示

3. 模型培训(Training)

- 用 PyTorch 进行迁移学习

- 分类/识别(ResNet-18)- 猫 / 狗数据集再训练- PlantCLEF 数据集的再训练- 收集自己的分类数据集

- 目标检测(SSD Mobilenet)- 再培训 SSD Mobilenet- 收集自己的检测数据集

以上所列出的内容,主要着重于每个功能函数的实验,其中以更换预训练模型选项去改变识别效果,以及调整输入、输出种类为主,主要是为了能够让使用者在两小时内,轻松体验三大应用的推理识别应用,以及 Jetson 的强大性能。

不过大部分初学者经历了体验过程的兴奋感之后,发现还是不知该如何修改代码或调用函数,去执行自己想要开发的应用。因此在我们所安排的系列文章中,所有的范例全部以 Python 代码为主,并且会比较深入地说明代码级别的内容,让大家能更深入掌握使用的技巧,最终能善加利用这个优异的深度学习库去开发自己的应用。

下一篇文章起,我们将带领大家一起来学习如何快速构建 AI 应用。

来源:业界供稿

好文章,需要你的鼓励

ServiceNow斥资10亿美元收购Veza 加速智能体权限管理

ServiceNow宣布将以超过10亿美元收购身份安全平台Veza,这是该公司2025年一系列AI和数据重点收购的最新举措。此次收购正值企业加速部署AI代理之际,而如何管理这些非人类身份的访问权限和输出已成为普遍难题。该交易将为ServiceNow的AI控制塔提供关键的身份治理能力,帮助企业建立统一的控制平面来定义上下文相关的权限、监控代理行为并大规模执行最小权限访问策略。

北大学者带你拖拽3D物体,像玩拼图一样让虚拟世界动起来

北京大学团队开发的DragMesh系统通过简单拖拽操作实现3D物体的物理真实交互。该系统采用分工合作架构,结合语义理解、几何预测和动画生成三个模块,在保证运动精度的同时将计算开销降至现有方法的五分之一。系统支持实时交互,无需重新训练即可处理新物体,为虚拟现实和游戏开发提供了高效解决方案。

除英伟达和台积电外,其他AI公司都需要靠量补利

在生成式AI热潮中,只有英伟达和台积电真正赚到钱,其他AI产业链公司要么亏损要么利润被稀释。博通虽然在数据中心网络领域有不错的利润率,但为了不被AI浪潮抛弃,也选择进入AI业务。博通拥有730亿美元的AI积压订单,但被迫成为AI系统集成商,进一步稀释利润。第四季度博通收入180亿美元,同比增长28.2%,AI芯片收入达65亿美元。

达尔豪斯大学团队重磅研究:为什么AI社会模拟需要从“沙盒游戏“升级为“开放世界“?

达尔豪斯大学研究团队系统性批判了当前AI多智能体模拟的静态框架局限,提出以"动态场景演化、智能体-环境共同演化、生成式智能体架构"为核心的开放式模拟范式。该研究突破传统任务导向模式,强调AI智能体应具备自主探索、社会学习和环境重塑能力,为政策制定、教育创新和社会治理提供前所未有的模拟工具。

除英伟达和台积电外,其他AI公司都需要靠量补利

2025年数据中心芯片领域最热门发展趋势

自动化技术领导者揭示企业对AI认知的关键误区

五分之三企业对Wi-Fi投资信心增强

CIO部署新兴技术指南:Gartner三步法平衡风险与收益

埃森哲与Anthropic合作引领AI集成商崛起之路

Pure Storage和华为存储增长最快,IDC第三季度报告显示

英特尔或以16亿美元收购AI推理芯片初创公司SambaNova

5D记忆晶体将成为未来数据存储主流技术

首届全国独角兽企业大赛总决赛在甬顺利闭幕

为全天候绿电而生,海辰储能发布全球首个原生8小时长时储能解决方案

为AI+而生,海辰储能发布全球首款锂钠协同AIDC全时长储能解决方案