HPE退出云服务器市场 两周前曾说不会退 原创

至顶网服务器频道 10月20日 新闻消息(文/Simon Sharwood with Chris Mellor):HPE宣布不再继续为大型云运营商提供定制服务器的业务。

读过笔者10月5日文章的读者可能会感到惊讶。其时HPE的Carlo Giorgi告诉记者,云服务器业务“……正在重新被打造及被打造成更适合目标用户的业务。云服务器业务仍将为服务提供商提供定制产品,但不会只具有标准的SKU,而且产品结构将取决于计算类型的需要。”

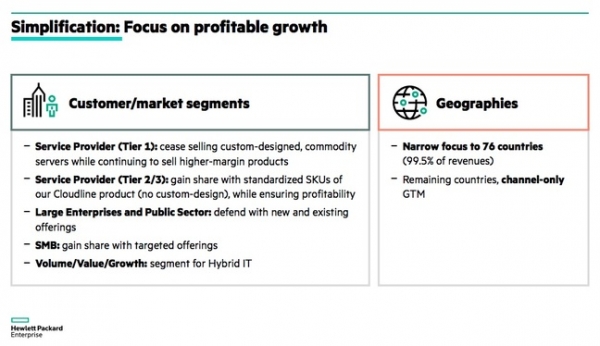

但现在HPE却发布了HPE总裁Antonio Neri本周提交的给金融分析师的幻灯片。他的第三张幻灯片判了服务器的死刑,见下图。

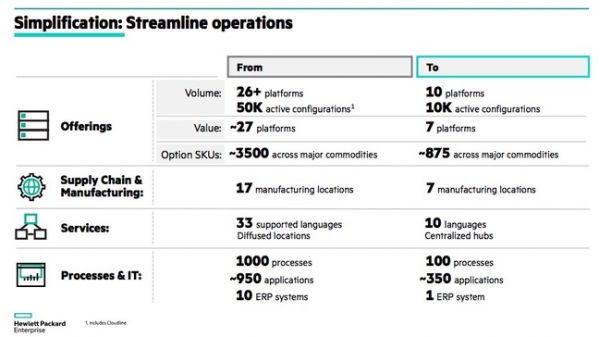

至于HPE为大型云提供的“高利润产品”是什么则没有明说。但如果说是完全新的东西的话,笔者会感到吃惊,因为Neri幻灯片里的第五张概述了HPE公司产品、地点和语言的大幅度整固。这可能也解释了为什么坊间会有HPE计划砍掉5000个工作岗位的 流言。

整套幻灯片在HPE公司未来的发展方向上给出了一些提示,幻灯片提到的计划包括:名为“Project New Stack”的项目,旨在提供“跨云混合即服务平台应用、数据及基础架构组合”;扩展Aruba平台,在云管理网络领域挑战思科的Meraki;作为Aruba解决方案的一部分开发SD-WAN功能,为客户提供单一控制点的Wi-Fi、交换和广域网;扩展Aruba OS下一代校园聚合交换的可编程性。

笔者曾要求HPE澄清其服务器计划,如果HPE这样做的话,笔者会更新此文或发一篇新的文章。

来源:The Register

好文章,需要你的鼓励

AI智能体Sweekar:90年代电子宠物的现代继承者

在2026年CES展会上,一款名为Sweekar的AI电子宠物亮相,被誉为90年代经典Tamagotchi的完美继承者。这款智能宠物从蛋形开始,随着成长会物理性变大,经历婴儿期、青少年期到成年期的完整生命周期。每个阶段都有不同的护理需求和互动方式,从基础语言学习到形成独特个性。与原版相比,Sweekar融入了先进AI技术,提供更丰富的长期体验。该产品将通过Kickstarter众筹,售价150美元。

ETH苏黎世突破性WUSH技术:让AI大模型压缩实现接近零损失的革命性方案

瑞士ETH苏黎世联邦理工学院等机构联合开发的WUSH技术,首次从数学理论层面推导出AI大模型量化压缩的最优解。该技术能根据数据特征自适应调整压缩策略,相比传统方法减少60-70%的压缩损失,实现接近零损失的模型压缩,为大模型在普通设备上的高效部署开辟了新路径。

AI赋能农业:科技如何改造传统乡村世界

西班牙CTIC RuralTech创新中心运用AI等前沿技术解决农业面临的气候变化等重大挑战。通过气候模拟系统和土地使用智能分析,农户可以监测作物、预测不同种植条件下的结果,如同拥有时光机器。草莓生产商利用模拟器预测疾病影响和气候变化效应,奶酪制造商则用AI分析牛奶数据,确定最适合生产特定奶酪的原料。这些技术应用大幅提高了农业可持续性和效率。

机器人终于能读懂你的手势了!弗吉尼亚大学团队让机器人变身“人类动作翻译官“

弗吉尼亚大学团队创建了Refer360数据集,这是首个大规模记录真实环境中人机多模态交互的数据库,涵盖室内外场景,包含1400万交互样本。同时开发的MuRes智能模块能让机器人像人类一样理解语言、手势和眼神的组合信息,显著提升了现有AI模型的理解准确度,为未来智能机器人的广泛应用奠定了重要基础。

从十城抢租到场景落地,擎天租以创新租赁模式推动机器人普惠化

Proteintech选择亚马逊云科技为首选云服务商,构建行业首个AI抗体助手加速科研创新

大模型落地元年:AI Agent如何打破测试“效率墙”,重塑数智化质量基座?

从工具到团队:万智2.5多智能体正在改写企业决策与执行全链路

AI智能体Sweekar:90年代电子宠物的现代继承者

AI赋能农业:科技如何改造传统乡村世界

Disrupt创业大赛六大媒体娱乐初创企业盘点

OpenAI计划第一季度推出全新音频生成模型

Fizz社交应用CEO谈论匿名社交为何有效

Apple Health应用的强大功能及使用技巧大揭秘

VSCO Capture新增视频拍摄功能迎接新年到来

Instagram负责人:AI内容泛滥,为真实媒体加指纹比识别虚假内容更实用

HPE Zerto Software 为企业数智化保驾护航

算启当下 即见未来

HPE ProLiant Gen12正式发布,打造极致可靠、能效优化、智能自驱的新一代计算平台

HPE Gen12:英特尔至强6加持,数据中心和边缘计算的“新宠”

据报道,慧与同埃隆.马斯克的X公司签署价值10亿美元的人工智能服务器大单

HPE谈2025年合作伙伴激励包:Alletra MP、Private Cloud AI、VM Essentials均属于最高倍薪酬类别

HPE CEO谈超算优势、VM Essentials市场机会和财报业绩

HPE计划在2025年全面升级超级计算机阵容

HPE发布用于AI和高性能计算的新超级计算机平台和服务器

HPE的新优势:为什么ProLiant DL145 Gen11服务器是一次“重大突破”