英特尔:64核第五代至强芯片在AI基准测试上比AMD下一代128核EPYC不相上下

AI基准测试是客户进行芯片选型的重要评估手段。随着英特尔和AMD在CPU上运行的AI工作负载领域争夺领导地位,AI基准之战正在升温。

为了证明自己的产品在AI工作负载的表现,不管是英特尔还是AMD纷纷亮出自己在相关基准测试方面的结果。

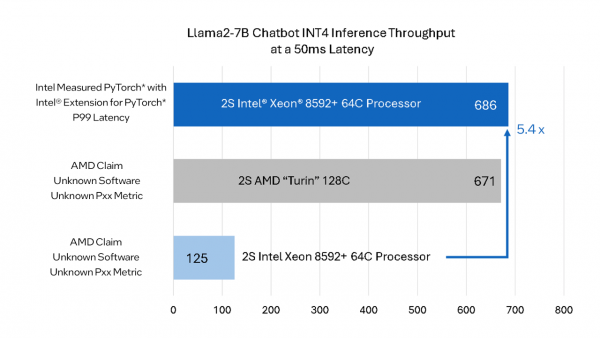

前段时间,在COMPUTEX上,AMD的Zen 5 EPYC Turin在人工智能工作负载上比英特尔至强芯片快5.4倍。

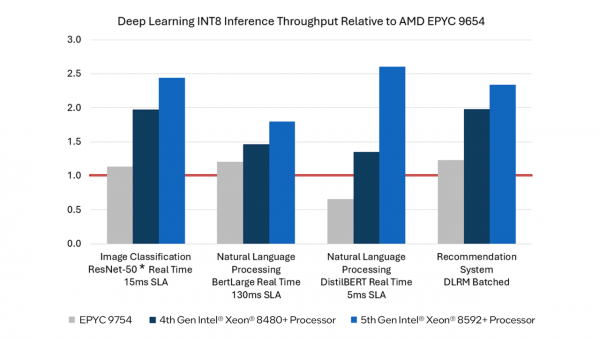

但是近日,英特尔表示,正在上市的第五代至强芯片比AMD即将于2024年下半年上市的3nm EPYC Turin处理器更快。英特尔表示,AMD的基准对Xeon性能的描述“不准确”,并分享了自己的基准来反驳AMD的说法。

英特尔自己的内部测试结果显示,至强的性能表现并不逊色,比AMD的基准测试快5.4倍,这样比较起来,至强比EPYC Turin并不弱,这使得目前正在发售的64核Xeon相对于AMD未来的128核机型具有优势——这的确是一个相当令人印象深刻的说法,而且在性能上也有很大的变化。

英特尔表示,AMD没有透露其用于基准测试的软件细节,也没有透露测试所需的SLA。AMD的测试结果与其内部广泛使用的开源软件(Intel Extension for PyTorch)并不匹配。

如果该基准测试代表真实性能,那么可能存在的差异是英特尔对AMX(高级矩阵扩展)数学扩展的支持。这些矩阵数学函数极大地提高了AI工作负载的性能,目前还不清楚AMD在测试英特尔芯片时是否采用了AMX。值得注意的是,AMX支持BF16/INT8,因此软件引擎通常会将INT4权重转换为更大的数据类型,以驱动AMX引擎。AMD的当前一代芯片不支持原生矩阵运算,目前还不清楚Turin是否也支持。

所以测试结果之所以出现这样的巨大差异,还是在软件调优。英特尔的硬件可利用软件框架和工具包进行加速,并获得出色的大模型推理性能,其中包括PyTorch和英特尔 PyTorch扩展包、OpenVINO工具包、DeepSpeed、Hugging Face库和vLLM。

来源:至顶网计算频道

好文章,需要你的鼓励

AI投资有望在2026年获得真正回报的原因解析

尽管全球企业AI投资在2024年达到2523亿美元,但MIT研究显示95%的企业仍未从生成式AI投资中获得回报。专家预测2026年将成为转折点,企业将从试点阶段转向实际部署。关键在于CEO精准识别高影响领域,推进AI代理技术应用,并加强员工AI能力培训。Forrester预测30%大型企业将实施强制AI培训,而Gartner预计到2028年15%日常工作决策将由AI自主完成。

北大学者革新软件诊断方式:让代码问题的“病因“无处遁形

这项由北京大学等机构联合完成的研究,开发了名为GraphLocator的智能软件问题诊断系统,通过构建代码依赖图和因果问题图,能够像医生诊断疾病一样精确定位软件问题的根源。在三个大型数据集的测试中,该系统比现有方法平均提高了19.49%的召回率和11.89%的精确率,特别在处理复杂的跨模块问题时表现优异,为软件维护效率的提升开辟了新路径。

2026年软件定价大洗牌:IT领导者必须知道的关键变化

2026年软件行业将迎来定价模式的根本性变革,从传统按席位收费转向基于结果的付费模式。AI正在重塑整个软件经济学,企业IT预算的12-15%已投入AI领域。这一转变要求建立明确的成功衡量指标,如Zendesk以"自动化解决方案"为标准。未来将出现更精简的工程团队,80%的工程师需要为AI驱动的角色提升技能,同时需要重新设计软件开发和部署流程以适应AI优先的工作流程。

德国达姆施塔特工业大学团队首次揭秘:专家混合模型AI的“安全开关“竟然如此脆弱

这项由德国达姆施塔特工业大学领导的国际研究团队首次发现,当前最先进的专家混合模型AI系统存在严重安全漏洞。通过开发GateBreaker攻击框架,研究人员证明仅需关闭约3%的特定神经元,就能让AI的攻击成功率从7.4%暴增至64.9%。该研究揭示了专家混合模型安全机制过度集中的根本缺陷,为AI安全领域敲响了警钟。

稚晖君发布全球最小全身力控人形机器人,上纬启元开启个人机器人时代

2026年软件定价大洗牌:IT领导者必须知道的关键变化

Linux 在 2026 年将势不可挡,但一个开源传奇可能难以为继

CES 2026趋势展望:全球最大科技展五大热门话题预测

人工智能时代为何编程技能比以往更重要

AI颠覆云优先战略:混合计算成为唯一出路

谷歌发布JAX-Privacy 1.0:大规模差分隐私机器学习工具库

谷歌量子AI发布新型优化算法DQI:量子计算优化领域的重大突破

缓解电动汽车里程焦虑:简单AI模型如何预测充电桩可用性

Titans + MIRAS:让AI拥有长期记忆能力

Gemini为STOC 2026大会理论计算机科学家提供自动化反馈

夸克AI眼镜持续升级:首次OTA,支持89种语言翻译