英特尔神经拟态计算:Hala Point引领新纪元 原创

近日,英特尔研究院副总裁、英特尔中国研究院院长宋继强接受记者采访,详细介绍了英特尔神经拟态计算技术的发展现状。

七年磨一剑:从Loihi到Hala Point的飞跃

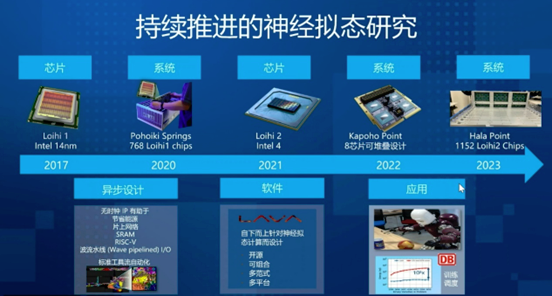

回溯至2017年,英特尔发布了Loihi神经拟态芯片,标志着其在该领域研究的正式启航。Loihi不仅在芯片中首次实现了生物大脑神经元的模拟,还创新性地将计算逻辑与存储逻辑融为一体,即“存算一体化”。这种设计极大提高了能效比,为后续的研究奠定了坚实基础。历经数年,从Loihi到Hala Point,神经元规模从最初的百万级跃升至十亿级,仅用三年时间就实现了超过10倍的增长,这无疑是神经拟态计算领域的一大里程碑。

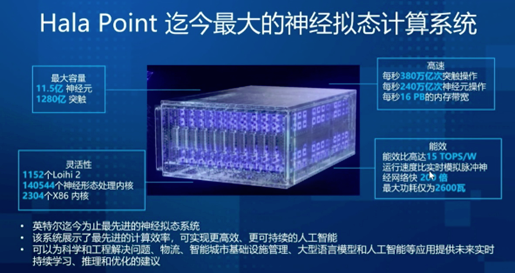

最新的Hala Point系统集成了1152个Loihi 2芯片,拥有11.5亿个神经元,神经元规模已达到人脑的1/80。同时,Hala Point的能效比极高,最大功耗2600W,可达到15TOPS的性能。

Loihi 2芯片是Hala Point系统的核心,相较于初代,其在计算密度、速度、互连特性等方面均有显著提升。得益于Intel 4制程技术,晶体管密度和能效比得到了质的飞跃,预示着未来在Intel 3、Intel 18A等更先进制程下,系统规模和效率还将持续突破。宋继强表示,即使保持现有尺寸,未来系统的神经元规模也将实现翻番甚至更多。

应用探索:从机器人到大规模优化

宋继强表示,神经拟态计算适用于对能效和实时性要求高的应用领域,特别适合解决大规模优化问题,如铁路网调度、物流管理等,其能效比传统CPU与GPU方案提升了3000倍。

同时,神经拟态计算也应用于视觉识别、语音识别等AI领域,并在某些任务上实现了百倍以上的能效提升。未来,神经拟态计算有望应用于更广泛的领域,如绿色AI、可持续AI等。

尽管Hala Point规模庞大,但它并非局限于固定的机器人应用。在实际场景中,只需几片Loihi 2芯片就能满足机器人的智能需求。

此外,虽然脑机接口技术与神经拟态计算并非直接绑定,但Loihi系统有能力处理来自脑机接口的信号,为未来应用打开了一扇窗。

在应用生态构建方面,英特尔神经拟态研究社区(INRC)自2018年成立以来,已汇聚200个成员,覆盖了从学术界到产业界,一半的应用研究集中在机器人、无人机等工业领域,通过多模态传感器的输入,实现感知和操控。

INRC不仅促进了神经拟态计算技术的多样化应用探索,还推动了软件堆栈Lava的开发,旨在兼容多种编程框架,支持与CPU、GPU、FPGA等异构计算的协同工作,为开发者提供了更加开放和灵活的环境。

展望未来,三管齐下

虽然神经拟态计算发展迅速,但商业化应用仍面临一些挑战。首先,需要找到适合其优势的应用场景。其次,软件生态尚需进一步完善,以更好地对接科研和产业应用。此外,神经拟态计算也面临器件层面的挑战,需要持续优化硬件架构,以提升性能。总体而言,神经拟态计算正处于快速发展期,未来应用前景广阔。英特尔将继续投入,推动神经拟态计算技术走向商业化,造福人类。

宋继强表示,面对未来,英特尔在神经拟态计算领域采取了“三管齐下”的策略:继续在硬件架构上创新,结合先进制程工艺提升效能;深化软件优化,以应对不断变化的应用需求;并通过INRC拓展应用边界,推动规模化商用。Hala Point不仅是技术实力的展示,更是对神经拟态计算无限可能的展望,预示着一个更高效、更智能时代的到来。

好文章,需要你的鼓励

亚马逊推出Alexa网页版:生成式AI助手的新选择

亚马逊在CES期间宣布推出Alexa.com网站,用户可像使用其他AI聊天机器人一样与Alexa交互。经过数月早期体验,Alexa+已获得数千万用户。新网站支持语音和文本交互,需登录使用以确保跨设备功能连续性。76%的Alexa+交互为独特任务,包括智能家居控制和第三方集成。Alexa+兼容七年来的设备,正式版将收费每月20美元或包含在Prime会员中。

UCSD团队打造终极仿真世界:让AI智能体在虚拟城市中自立更生的惊人实验

SimWorld是由UCSD等多所顶尖院校联合开发的革命性AI仿真平台,基于虚幻引擎5构建了具备真实物理规律的虚拟城市环境。该平台支持无限扩展的程序化世界生成和自然语言交互,让AI智能体能够在复杂环境中学会生存、合作和竞争,为通用人工智能的发展提供了前所未有的训练平台。

Plaud推出可穿戴AI记录设备NotePin S,CES 2026记者新利器

AI笔记公司Plaud在CES 2026推出新款可穿戴设备NotePin S,可夹在衣领、戴在手腕或挂在脖子上记录对话。该设备通过蓝牙连接手机,配备双麦克风,录制范围约3米,支持一键高亮标记重要时刻。同时发布的还有Plaud Desktop桌面AI记录工具,可原生捕获线上会议内容,无需机器人加入通话。两款产品将所有笔记、会议和对话整合到统一平台管理。

浙江大学团队提出C2DLM:让AI推理更像人类思维的全新语言模型

浙江大学联合华为提出C2DLM,这是一种因果概念引导的扩散语言模型,通过自动提取因果关系并融入注意力机制来增强AI推理能力。相比传统方法,C2DLM在推理任务上平均提升1.31%-12%,训练效率提高3.2倍,为解决语言模型推理能力不足开辟了新路径。

亚马逊推出Alexa网页版:生成式AI助手的新选择

Plaud推出可穿戴AI记录设备NotePin S,CES 2026记者新利器

机器人初创公司推出现实版瓦力机器人及其他伴侣产品

VisIC宣布完成2,600万美元B轮融资

CES 2026 | AMD扩张“边缘统治力” “芯片级异构”塑造汽车、工业边缘应用“新法则”

CES 2026 | NVIDIA新风向: Rubin平台面市 ,系统级“AI工厂”成型,物理AI加速落地

英伟达Vera-Rubin平台推出前六月已淘汰现有AI硬件

英特尔推出首批18A工艺制程的Core Ultra处理器

Rokid在CES 2026推出无屏AI智能眼镜

英伟达物理AI模型为新一代机器人铺路

微软发布 GitHub Copilot 的 C++ 代码编辑工具

至顶AI实验室硬核评测:戴尔Precision 5690移动工作站,部署DeepSeek+LobeChat打造个人超级智能体

成本打到6万以下,手把手教你用4路锐炫显卡+至强W跑DeepSeek

天翼云CPU实例部署DeepSeek-R1模型最佳实践

MWC 2025:英特尔展示基于至强6处理器的基础网络设施

英特尔至强6新品发布,能为数据中心带来哪些改变?

英特尔推出具备高性能和能效的以太网解决方案

英特尔推出搭载至强6处理器的卓越AI和网络解决方案

HPE Gen12:英特尔至强6加持,数据中心和边缘计算的“新宠”

当大家都在期待苹果的机器人时,苹果却先造了个“台灯”

人形机器人开年大戏:Figure AI提分手,波士顿动力上AI,特斯拉加紧量产

英特尔Gaudi 2D AI加速器为DeepSeek Janus Pro模型提供加速