英特尔AI平台在微软Phi-3 AI模型发布当天即实现优化支持

英特尔与微软合作,在其数据中心平台、AI PC及边缘解决方案中支持多种Phi-3模型

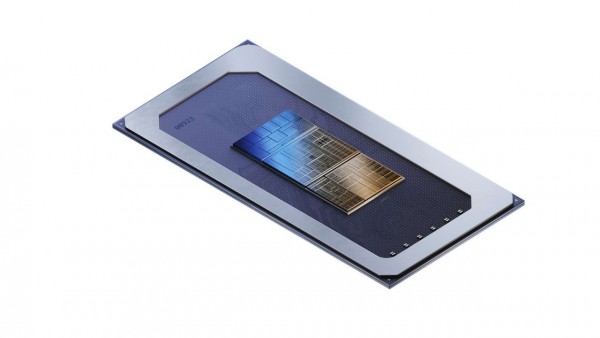

近日,英特尔针对微软的多个Phi-3家族的开放模型,验证并优化了其跨客户端、边缘和数据中心的AI产品组合。Phi-3家族的小型开放模型可在低算力的硬件上运行,且更容易微调以满足特定的用户要求,使开发者能够轻松构建在本地运行的应用。支持该模型的产品组合包括面向数据中心应用的英特尔®至强®处理器、英特尔® Gaudi AI加速器,以及面向客户端的英特尔®酷睿™ Ultra处理器和英特尔锐炫™显卡。

英特尔®酷睿™ Ultra处理器支持Phi-3家族开放模型

“我们为客户和开发者提供强大的AI解决方案,这些解决方案采用了业界最新的AI模型与软件。英特尔与微软等AI软件生态系统领军企业的深入合作,是推动AI无处不在的关键。此次,我们非常高兴能与微软携手,使涵盖数据中心、边缘以及客户端的一系列英特尔硬件产品为多种新的Phi-3模型提供支持。”

——Pallavi Mahajan,英特尔公司副总裁兼数据中心与人工智能软件总经理

重要意义:为了推动AI无处不在,英特尔通过与AI领导者和创新者合作,持续深耕AI软件生态系统。

英特尔与微软合作,其产品组合在发布当天即为Phi-3模型提供支持,其中包含英特尔中央处理器 (CPU)、图形处理单元 (GPU) 和英特尔Gaudi加速器。此外,英特尔与微软在DeepSpeed中共同设计了一款易用的深度学习优化软件套件——加速器抽象层,并拓展了Hugging Face上Phi-3和其他模型的自动张量并行支持。

Phi-3模型的大小非常适用于设备端推理,并让在AI PC和边缘设备上进行微调或定制等轻量级模型开发成为可能。同时,英特尔客户端硬件通过全面的软件框架和工具实现加速,其中包括PyTorch和用于本地研发的英特尔® PyTorch扩展包,以及用于模型开发和推理的OpenVINO™工具包。

未来,英特尔将持续满足企业用户的生成式AI需求,并将继续支持和优化针对Phi-3及其他行业领先语言模型的软件。

访问英特尔开发者博客可了解相关性能与技术。

来源:业界供稿

好文章,需要你的鼓励

清华团队让机器学会“透视眼“:用视频AI破解透明物体深度估计难题

清华团队开发DKT模型,利用视频扩散AI技术成功解决透明物体深度估计难题。该研究创建了首个透明物体视频数据集TransPhy3D,通过改造预训练视频生成模型,实现了准确的透明物体深度和法向量估计。在机器人抓取实验中,DKT将成功率提升至73%,为智能系统处理复杂视觉场景开辟新路径。

R语言重获关注 Tiobe编程语言排行榜重返前十

R语言在Tiobe 12月编程语言流行度指数中重返前十,排名第10位,占比1.96%。作为统计计算专用语言,R语言凭借在统计分析和大规模数据可视化方面的优势重新获得关注。尽管传统软件工程师对其语法和扩展性存在质疑,但R语言在大学和研究驱动行业中仍表现出色,在快速实验、统计建模和探索性数据分析领域具有独特优势。

ByteDance推出全新混合专家模型训练法:让AI专家团队各司其职,大幅提升大语言模型性能

字节跳动研究团队提出了专家-路由器耦合损失方法,解决混合专家模型中路由器无法准确理解专家能力的问题。该方法通过让每个专家对其代表性任务产生最强响应,同时确保代表性任务在对应专家处获得最佳处理,建立了专家与路由器的紧密联系。实验表明该方法显著提升了从30亿到150亿参数模型的性能,训练开销仅增加0.2%-0.8%,为混合专家模型优化提供了高效实用的解决方案。

openGauss熊伟:oGRAC+超节点,AI数据库的下一个五年

R语言重获关注 Tiobe编程语言排行榜重返前十

AWS在re:Invent 2025后仍难构建企业AI完整解决方案

Linux基金会推出自主式AI基金会

GitHub个人访问Token被曝光后威胁激增,攻击者可直达云环境

Manus被收购,枫清科技将获过亿元投资:资本市场重估中国AI智能体

新年新机首选啥?AMD高端锐龙游戏本推荐

GridFree推出首个AI数据中心"电力工厂"独立站点

IDC警告AI内存需求将引发PC市场重大下滑

软银完成对OpenAI的225亿美元投资,持股比例达11%

苹果在2026年笔记本电脑出货量下滑中占据有利地位

2025年最佳AI语音录入应用推荐