第一时间适配!英特尔锐炫GPU在运行Llama 3时展现卓越性能

在Meta发布Llama 3大语言模型的第一时间,英特尔即优化并验证了80亿和700亿参数的Llama 3模型能够在英特尔AI产品组合上运行。在客户端领域,英特尔锐炫™显卡的强大性能让开发者能够轻松在本地运行Llama 3模型,为生成式AI工作负载提供加速。

在Llama 3模型的初步测试中,英特尔®酷睿™Ultra H系列处理器展现出了高于普通人阅读速度的输出生成性能,而这一结果主要得益于其内置的英特尔锐炫GPU,该GPU具有8个Xe核心,以及DP4a AI加速器和高达120 GB/s的系统内存带宽。

英特尔酷睿Ultra处理器和英特尔锐炫显卡在Llama 3模型发布的第一时间便提供了良好适配,这彰显了英特尔和Meta携手为本地AI开发和数百万设备的部署所做出的努力。英特尔客户端硬件性能的大幅提升得益于用于本地研发的PyTorch和英特尔® PyTorch扩展包等丰富的软件框架与工具,以及用于模型部署和推理的OpenVINO™工具包。

在内置英特尔锐炫显卡的英特尔酷睿 Ultra 7上运行Meta-Lama3-8B-Instruct

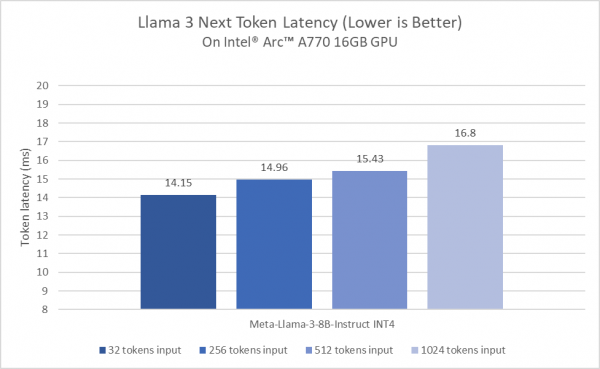

在英特尔锐炫A770上运行Llama 3的下一个Token延迟

上图展示了在搭配PyTorch框架和针对英特尔GPU的优化后,英特尔锐炫A770显卡在运行Llama 3模型时表现出卓越的性能。除此之外,英特尔锐炫显卡亦支持开发者在本地运行包括Mistral-7B-Instruct LLM、Phi2、Llama2等在内的大语言模型。

基于相同的基础安装,开发者可以在本地运行多种模型的主要原因,可以归功于IPEX-LLM,即一个针对PyTorch的大语言模型库。它主要基于英特尔® PyTorch扩展包打造,涵盖时下最新的大语言模型优化和低比特数据压缩(INT4/FP4/INT8/FP8),以及针对英特尔硬件的大多数最新性能优化。得益于如锐炫A系列显卡等英特尔独立显卡上的Xe核心XMX AI加速功能,IPEX-LLM能够显著提高性能,其支持在Windows子系统Linux版本2、原生Windows环境和原生Linux上的英特尔锐炫A系列显卡。

由于所有的操作和模型均基于原生PyTorch框架,开发者可以非常方便地更换或使用不同的PyTorch模型以及输入数据。而上述模型和数据不仅能够在英特尔锐炫显卡上运行,开发者亦能享受到英特尔锐炫显卡加速带来的性能提升。

产品和性能信息

英特尔®酷睿™Ultra处理器:

在英特尔酷睿Ultra 7 155H平台(MSI Prestige 16 AI Evo B1MG-005US)上进行测试,使用32GB LP5x 6400Mhz总内存,英特尔显卡驱动101.5382 WHQL,Windows 11 Pro版本22631.3447,平衡操作系统电源计划,最佳性能操作系统电源模式,极限性能MSI Center模式,已启用核心隔离,基于英特尔2024年4月17日的测试。

英特尔锐炫™A系列显卡:

在英特尔锐炫A770 16GB显卡上进行测试,使用英特尔酷睿 i9-14900K、华硕ROG MAXIMUS Z790 HERO主板、32GB(2x 16GB)DDR5 5600Mhz,Corsair MP600 Pro XT 4TB NVMe。软件配置包括英特尔显卡驱动101.5382 WHQL、Windows 11 Pro版本22631.3447、性能电源策略和核心隔离禁用。基于英特尔2024年4月17日的测试。

注释:

性能因使用情况、配置和其他因素而异。可在性能指数网站上了解更多信息。

性能结果基于所示日期的配置测试,可能不反映所有公开可用的更新。请参阅附件以了解配置详情。没有任何产品或组件可以绝对安全。

基于预生产系统和组件的结果,以及使用英特尔参考平台(内部新系统的内部示例)、英特尔内部分析或架构模拟或建模估算或模拟的结果,仅供参考。结果可能会因将来对任何系统、组件、规格或配置的更改而变化。

成本和结果可能会有所不同。

英特尔技术可能需要启用硬件、软件或服务进行激活。

来源:业界供稿

好文章,需要你的鼓励

让自动驾驶AI学会“聚焦重点“,速度提升7倍却更加安全

来自北京大学多媒体信息处理国家重点实验室和小鹏汽车的研究团队发布了一项重要研究成果,提出了一种名为FastDriveVLA的创新框架,让自动驾驶AI能够像人类司机一样,学会在纷繁复杂的道路场景中快速识别并聚焦于真正重要的视觉信息。

清华团队让机器学会“透视眼“:用视频AI破解透明物体深度估计难题

清华团队开发DKT模型,利用视频扩散AI技术成功解决透明物体深度估计难题。该研究创建了首个透明物体视频数据集TransPhy3D,通过改造预训练视频生成模型,实现了准确的透明物体深度和法向量估计。在机器人抓取实验中,DKT将成功率提升至73%,为智能系统处理复杂视觉场景开辟新路径。

TechCrunch创业战场大赛消费和教育科技领域26强公司榜单

TechCrunch年度创业战场大赛从数千份申请中筛选出200强,其中20强进入决赛角逐10万美元大奖。本次消费科技和教育科技领域共有26家公司入选,涵盖无障碍出行、AI视频制作、服装租赁、护肤推荐、纹身预约等创新应用,以及AI语言学习、个性化数学教育、职场沟通培训等教育科技解决方案,展现了科技创新在日常生活和教育领域的广泛应用前景。

ByteDance推出全新混合专家模型训练法:让AI专家团队各司其职,大幅提升大语言模型性能

字节跳动研究团队提出了专家-路由器耦合损失方法,解决混合专家模型中路由器无法准确理解专家能力的问题。该方法通过让每个专家对其代表性任务产生最强响应,同时确保代表性任务在对应专家处获得最佳处理,建立了专家与路由器的紧密联系。实验表明该方法显著提升了从30亿到150亿参数模型的性能,训练开销仅增加0.2%-0.8%,为混合专家模型优化提供了高效实用的解决方案。

TechCrunch创业战场大赛消费和教育科技领域26强公司榜单

新Mac开箱必备:完美工作桌面升级指南

如何使用ChatGPT新增应用集成功能

谷歌地图AI工具让节日和新年出行规划变得轻松便捷

2025年七大IT灾难回顾

openGauss熊伟:oGRAC+超节点,AI数据库的下一个五年

R语言重获关注 Tiobe编程语言排行榜重返前十

JDK 26:Java 26的新特性详解

AWS在re:Invent 2025后仍难构建企业AI完整解决方案

Linux基金会推出自主式AI基金会

GitHub个人访问Token被曝光后威胁激增,攻击者可直达云环境

Manus被收购,枫清科技将获过亿元投资:资本市场重估中国AI智能体