让AI无处不在 英特尔On技术创新大会秀“肌肉” 原创

美国时间2023年9月19日,一年一度的英特尔On技术创新 大会如期举行。

在这次大会上,英特尔带来了诸多重磅消息和产品发布,令人眼花缭乱。这些消息既包括硬件产品,还有软件产品。英特尔提出了Binging AI Everywhere的口号,从硬件到软件,全面拥抱AI。

01 “芯经济”

在数字经济蓬勃发展的今天,半导体产业的基石作用不言而喻。如今,芯片形成了规模达5740亿美元的行业,并驱动着全球约8万亿美元的技术经济。

英特尔CEO帕特·基辛格在主题演讲中表示,更充足、更强大、更具性价比的处理能力,是经济增长的关键组成。人工智能代表着计算的新时代,促进了“芯经济”的崛起。

世界对计算的需求呈指数级增长,而且这种需求与芯片的面积、成本和功耗成反比。简而言之,这就是摩尔定律。

基辛格表示,五大超级技术力量——计算、连接、基础设施、人工智能、传感和感知,由“芯经济”推动。

的确,芯片驱动的算力正在成为数字经济特别是人工智能产业的重要驱动力。英特尔提出“芯经济”的概念,也是彰显自身所在产业的价值。

如何体现自己的半导体行业领导者地位呢?英特尔从硬件和软件等多个方面切入,积极推动革新。

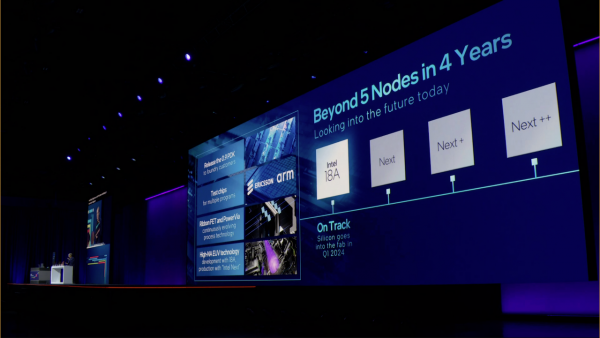

02 四年五个制程节点

谈到摩尔定律,我们就不得不说制程工艺。目前,英特尔的“四年五个制程节点”计划正在稳步推进中,Intel 7已经实现大规模量产,Intel 4已经生产准备就绪,Intel 3也在按计划推进中,目标是2023年年底。

Intel 20A将是首个应用PowerVia背面供电技术和新型全环绕栅极晶体管RibbonFET的制程节点。

今年,英特尔与爱立信、Arm等达成合作,英特尔18A制程继续提速,采用这两项技术的Intel 18A制程节点也在按计划推进中,将于2024年下半年生产准备就绪。

除制程外,英特尔向前推进摩尔定律的另一路径是使用新材料和新封装技术,如玻璃基板(glass substrates),其可以增加单个封装内的晶体管数量,满足AI等数据密集型高性能工作负载的需求,并在2030年后继续推进摩尔定律。

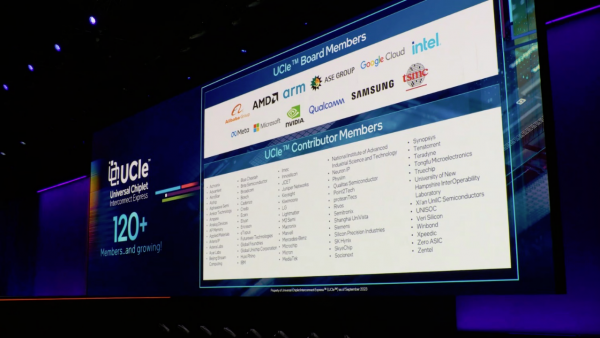

基辛格表示,摩尔定律的下一波浪潮将由多芯粒封装技术所推动,如果开放标准能够解决IP集成的障碍,它将很快变成现实。发起于去年的UCIe标准将让来自不同厂商的芯粒能够协同工作,从而以新型芯片设计满足不同AI工作负载的扩展需求。目前,UCIe开放标准已经得到了超过120家公司的支持。

英特尔展示了基于通用芯粒高速互连开放规范(UCIe)的测试芯片封装。该测试芯片集成了基于Intel 3制程节点的英特尔UCIe IP芯粒,和基于TSMC N3E制程节点的Synopsys UCIe IP芯粒。这些芯粒通过EMIB(嵌入式多芯片互连桥接)先进封装技术互连在一起。英特尔代工服务(Intel Foundry Services)、TSMC和Synopsys携手推动UCIe的发展,体现了三者支持基于开放标准的芯粒生态系统的承诺。

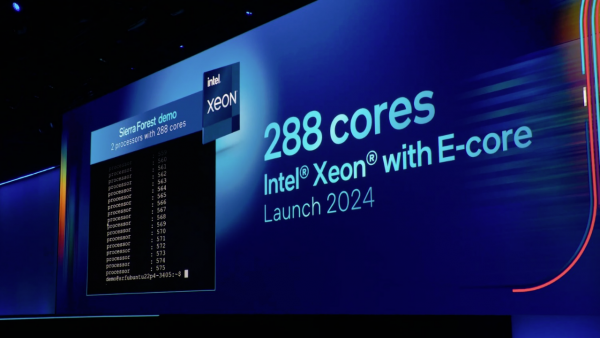

03 下一代英特尔至强处理器

至强处理器是数据中心市场的王者,近期英特尔出货了第一百万片第四代英特尔至强可扩展处理器。

大会上,英特尔宣布第五代英特尔至强处理器将于12月14日发布。具备高能效的能效核(E-core)处理器Sierra Forest将于2024年上半年上市。与第四代至强相比,拥有288核的该处理器预计将使机架密度提升2.5倍,每瓦性能提高2.4倍。

紧随Sierra Forest发布的是具备高性能的性能核(P-core)处理器Granite Rapids,与第四代至强相比,其AI性能预计将提高2到3倍。展望2025年,代号为Clearwater Forest的下一代至强能效核处理器将基于Intel 18A制程节点制造。

基辛格宣布,一台大型AI超级计算机将完全采用英特尔至强处理器和4000个英特尔Gaudi2加速器打造,Stability AI是其主要客户。

而国内阿里巴巴将内置AI加速器的第四代英特尔至强可扩展处理器用于其生成式AI和大语言模型,即“阿里云通义千问大模型”,大幅缩短了模型响应时间,平均加速可达3倍。

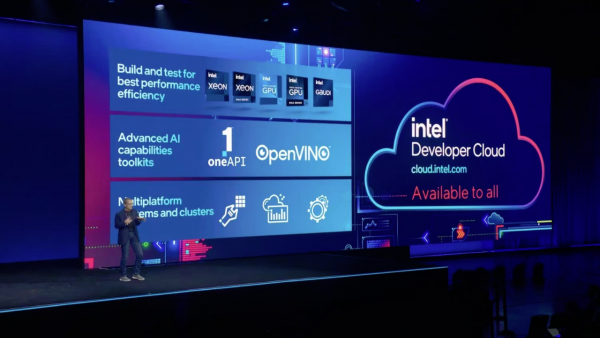

04 软件工具平台全面上线

除了硬件产品,英特尔在软件方面也加大了投入。

英特尔开发者云平台全面上线,英特尔开发者云平台帮助开发者利用最新的英特尔软硬件创新来进行AI开发(包括用于深度学习的英特尔Gaudi2加速器),并授权他们使用英特尔最新的硬件平台,如第五代英特尔至强可扩展处理器和英特尔数据中心GPU Max系列1100和1550。

在使用英特尔开发者云平台时,开发者可以构建、测试并优化AI以及HPC应用程序,他们还可以运行从小规模到大规模的AI训练、模型优化和推理工作负载,以实现高性能和高效率。英特尔开发者云平台建立在oneAPI这一开放的,支持多架构、多厂商硬件的编程模型基础之上,为开发者提供硬件选择,并摆脱了专有编程模型,以支持加速计算、代码重用和满足可移植性需求。

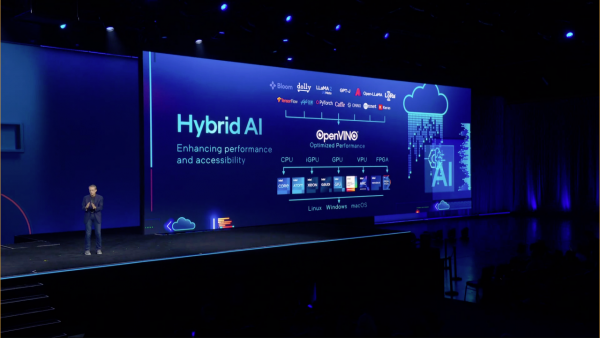

基辛格还宣布了英特尔发行版OpenVINO工具套件2023.1版的发布,OpenVINO是英特尔的AI推理和部署运行工具套件,在客户端和边缘平台上为开发人员提供了优质选择。该版本包括针对跨操作系统和各种不同云解决方案的集成而优化的预训练模型,包括多个生成式AI模型,例如Meta的Llama 2模型。

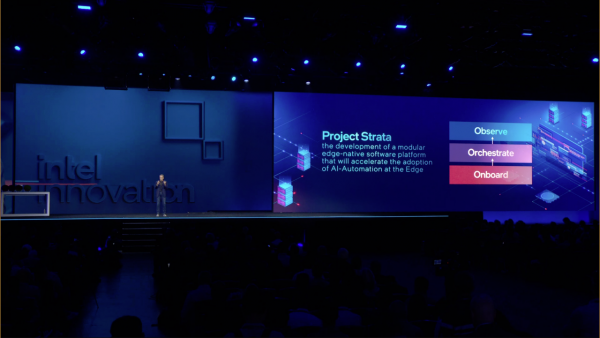

另外,Strata项目以及边缘原生软件平台将于2024年推出,提供模块化构件、优质服务和产品支持。这是一种横向扩展智能边缘(intelligent edge)和混合人工智能(hybrid AI)所需基础设施的方式,并将英特尔和第三方的垂直应用程序整合在一个生态系统内。该解决方案将使开发人员能够构建、部署、运行、管理、连接和保护分布式边缘基础设施和应用程序。

05 前沿科技

除了专注现有产品技术创新,英特尔还面向量子计算、神经拟态等前沿科技开展研究。

基于Loihi 2第二代研究芯片和开源Lava软件框架,英特尔研究院正在推动神经拟态计算的发展。Loihi 2是性能业界领先的神经拟态研究芯片,基于Intel 4制程节点开发,每个芯片最多可包含100万个神经元。

Loihi 2还具有可扩展性,8芯片Loihi 2开发板Kapoho Point,可通过堆叠满足大规模工作负载的需求。英特尔还提供开源、模块化、可扩展的Lava软件框架,助力神经拟态应用的开发。

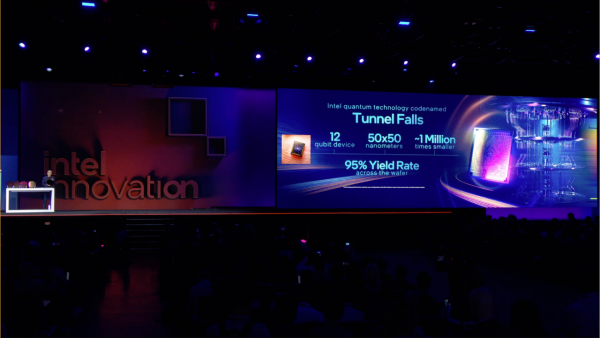

今年6月,英特尔发布包含12个硅自旋量子比特(silicon spin qubit)的全新量子芯片Tunnel Falls,继续探索量子实用性。

在英特尔的晶圆厂里,Tunnel Falls是在300毫米的硅晶圆上生产的,利用了英特尔领先的晶体管工业化制造能力,如极紫外光刻技术(EUV),以及栅极和接触层加工技术。

06 迈向AI PC的新时代

AI将通过云与PC的紧密协作,进而从根本上改变、重塑和重构PC体验,释放人们的生产力和创造力。我们正迈向AI PC的新时代。

全新的PC体验,即将在接下来推出的产品代号为Meteor Lake的英特尔酷睿Ultra处理器上得到展现。该处理器配备英特尔首款集成的神经网络处理器(NPU),用于在PC上带来高能效的AI加速和本地推理体验。酷睿Ultra将在12月14日发布。

酷睿Ultra处理器是英特尔客户端处理器路线图的一个转折点:该款处理器是首个采用Foveros封装技术的客户端芯粒设计。除了NPU以及Intel 4制程节点在性能功耗比上的重大进步外,这款处理器还通过集成英特尔锐炫显卡,带来了独立显卡级别的性能。

07 写在最后

从大会公布的信息看,英格尔现在目前是以AI优先为策略,全面推进自身的变革。

众所周知,英特尔正在推进IDM 2.0,而近期AIGC的浪潮席卷业界。如今英特尔面临的市场环境和客户需求已经发生巨大变化,英特尔必须跟上变化。

基辛格表示,AI代表新时代的到来,创造了巨大的机会。英特尔致力于让AI无处不在,使其更易被所有人使用,并能更便捷地在从客户端和边缘,到网络和云的工作负载中规模化集成。

很显然,英特尔希望借助AI来强化自身的竞争力,从硬件到软件,稳定自身在产业和客户中的位置。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元