浅谈数据中心网络布线发展趋势

长飞集团|长芯盛(武汉)科技有限公司 伍义群

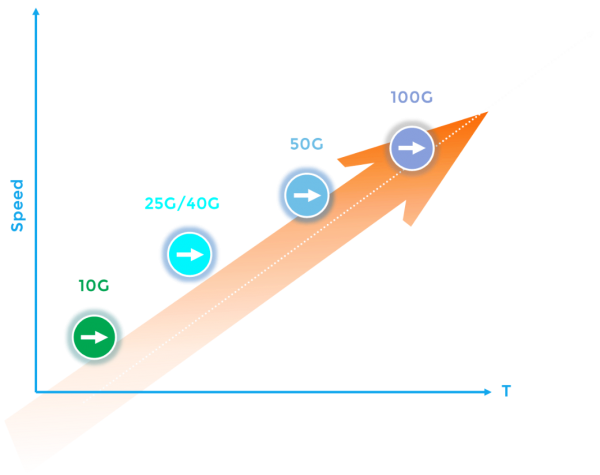

随着数字化和数字化转型的不断推进,我们日常工作、生活中不断的出现新的应用场景,比如:物联网、区块链、无人驾驶、边缘计算,5G通信等,新的场景带来更多的终端设备的入网,这就对我们的数据中心提出了更多的挑战,从而使数据中心的规模越来越大,数据流量程指数倍增长,架构也从南北向主流量变成东西、南北向同时增大,且东西向增速较快,这也带来了数据中心带宽不断升级的需求,从10G、40G到100G、400G,以及不久后的800G及1.6T。

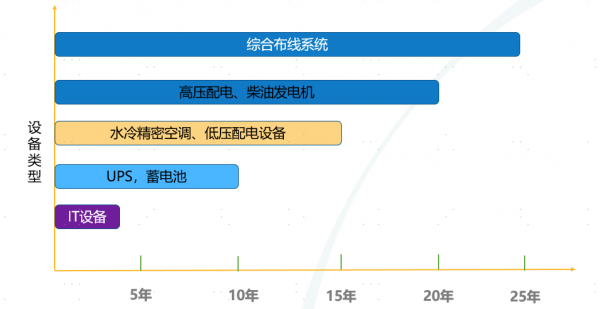

几乎所有IT技术的演进都离不开对网络大带宽、低时延的依赖,在这种需求的推动下,网络服务能力在数据中心规划及建设过程中逐渐成为越来越重要的考量指标,满足数据中心有源设备快速更新迭代的短暂生命周期,是我们需要对布线系统的解决方案提出思考的。

- 数据中心高密度发展趋势

随着数据中心的规模越来越大,制冷技术的不断发展,单机柜的功率密度不断的增加,从3KW/柜,到6KW、12KW/柜到互联网行业超过20KW/柜的容量,整个数据中心的高密度发展,带来了数据中心PUE值的优化结果,大大降低了数中心的整体能耗。

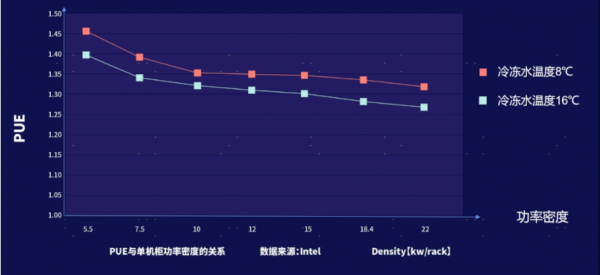

根据Intel报告图-1,可以看出PUE与单机柜功率密度的关系,在冷冻水温稳定在8摄氏度的状态下,5.5Kw/柜时PUE值达到1.45,在水温不变的情况下,单机柜功率提升到10kW时,PUE值降到1.35左右,单机柜10Kw到单机柜22KW之间,PUE值曲线相对比较平滑。在精密空调水温不变的情况下,在合理的范围内提高单机柜服务器功率密度,PUE值则有明显的下降。密度增加PUE值会下降的主要原因是因为换热效率增加了,热损失更小,所以整体的制冷效率提升了,有效提升数据中心的PUE值,以达到节能减耗的目的。

;图-1

从另一个角度来说,提高数据中心单机柜功率密度,有效的利用现有的基础设施,减少重复建设,减少了废弃物污染物的产生,也是有效的节省能源。

在单机柜有限的空间内,放置更多的端口,满足单机柜功率不断扩容的需求,是综合布线系统扩展性的体现,目前,在应对单机柜功率密度不断增加的情况下,各大布线品牌商都推出了各自的高密度的解决方案,像综合布线品牌iCONEC率先推出了1U 96芯、1U 144芯、1U 192芯、1U 240芯、1U 288芯、1U 432芯等多种不同的高密度解决方案,来应对未来行业市场的发展趋势。

- 数据中心的大带宽、低时延的趋势

近些年,应用场景的多样化,带来了终端设备的快速增长,数据中心的流量从南北方向为主,走向了东西方向为主,也给数据中心带来了架构,带宽等诸多方面的挑战。

据研究表明,5G移动网络的大规模部署进一步加剧了蜂窝运营商对更多网络带宽的需求,以满足不断增长的WAN容量需求;与现在的4G移动网络相比,5G的数据吞吐量增加了10倍,通信容量增加了100倍,这也带来了数据中心的流量成指数倍增长,大带宽成为必然的趋势。当前,互联网行业已经在2021年初进入实现部署400G阶段,银行业的数据中心在100G阶段,部分银行已经准备向400G迁移,诸多新建的企业级数据中心,都在计划100G主干,那么800G、1.6T的网络应用将会变得更加迫切。

在大带宽的同时,数据中心网络也需要低时延,来满足用户端的体验度,例如终端用户会要求在合理时间内提供数据和应用,云网络离用户太远,需要层层传输才能到达终端用户,那么云、边协作就就显得非常的重要,让应用和服务离仁和物更近,来解决带宽、时延等这些问题。在很多行业,降低时延就意味着增加收入,谷歌搜索产品和用户体验副总裁提到,0.5秒钟的时延就会造成流量和广告收入减少20%。同样,十分之一秒的时延就能导致亚马逊的销售额降低1%,所以对于服务于时延敏感的业务,必须最小化时延以保持客户满意度。

部分应用场景下时延情况如下:

- 移动网络时延

基站到核心网的时延和物理距离强相关,时延在1到15ms不等。核心网的出口会连接到本地固网,从本地固网到运营商骨干网,再到阿里云数据中心,根据距离的长短,网络时延在1到100ms不等,进入阿里云数据中心后,数据中心内部的时延一般小于2ms。

- 工业互联网

对于工业互联网类的应用,主要是实时控制类的报文的交互,应用层处理时延会更小,很多在5ms以内。

- 竞技类游戏

对于游戏类的应用,主要是终端向游戏服务器发送各种指令,另外一个方向是终端收到服务的数据后展示给用户。这种类型的应用层处理时间比较适中,一般在30ms以内。终端发送指令时延很短,很多时候可以小于1ms,在服务器侧的游戏处理逻辑情况下也很快,一般在5ms内都能处理完,用户终端收到游戏服务器的数据后通过渲染将画面呈现给用户,这个应用层的渲染过程会稍微耗时一些,根据用户终端的处理性能,游戏的炫酷程度,处理时延在5到30ms之间不等。整体上游戏场景下的应用层处理时延在10到30ms。

从综合布线角度出发,为降低数据中心网络时延,可以减少布线长度,减少跳接的次数,采用低损耗的布线解决方案,能够有效的帮助网络减少时延。

- 数据中心布线系统带宽需具备平滑升级能力

数据中心的发展过程中,服务器、光模块等设备更新周期短,迭代快,但布线系统的使用周期长,那么怎样使一次布线,能够匹配多次IT设备的更新周期呢?

那么数据中心的建设初期,就需要考虑未来业务发展的状态,从10G、40G向100G、400G演进,我们应该站在400G的基础上来看当前数据中心的建设需求。那么怎样使数据中心从10G 平滑升级到400G,并且具有延申到800G的可能性?

目前,国内 400G 传输介质的选择仍然是多模光纤占主导地位,市场更倾向于采用 SR8 及 SR4.2 的传输方式,连接器将会采用 MPO/MTP 等方式。

那么400G SR4.2 和SR8 如何选择? 400G SR8 光模块已在市场批量应用,而 SR4.2 光模块尚处于研发阶段,未见有厂商批量交付。 从产品架构上来看,两者整体相同,主要区别在光学设计,400G SR4.2 光模块在光路上采用波分复用技术,技术上较 400G SR8 光模块更复杂,整体价格较高,供应链也存在一定风险。400G SR8目前已有较多国产厂商可以提供, 整体供应风险较低,整体成本较低,且可靠性更好。部分互联网企业已经开始采用MTP16(SR8)的方式部署400G。

从目前来看,400G SR8 光模块是主流技术路线, 无论从成本还是供应链层面来看都更具有优势;但不排除随着技术的发展, 400G SR4.2 等波分复用技术的光模块技术会逐步走向成熟,且需求量逐渐增多,最终在成本上接近400G SR8 光模块并提供支持 800G 波分方案的可能性,另外,SR4.2透镜分光会带来额外信号损耗,以及OM3、OM4光纤在910nm波段未被定义有效带宽,如果未来有采用波分的趋势,那么OM5光纤将是最佳的选择。

实际应用中,采用8芯、12芯、16芯预端接主干作为数据中心传输介质,都可以让布线方案可以做到10G、40G到100G、400G的平滑升级,但是采用多模光纤,MPO/MTP16作为预端接主干光缆,将是当前兼容400G,甚至800G性价比最优的方案。

因此,综合布线系统既要满足当前的使用需求,也要符合未来的发展趋势,在带宽可升级的同时实现空间密度的在线升级,尽可能的延长数据中心的使用寿命,使全生命周期拥有成本最优化。

iCONEC®作为长飞公司旗下唯一专业从事综合布线业务的子品牌,携数据中心解决方案与高密度配线方案亮相此次2023数据中心绿色发展大会。在大会上重点展示G4S光纤配线系统与UDF系列高密度光纤配线系统。iCONEC®基于未来行业细分应用场景和服务,提供高密度、高效可靠、全场景的解决方案。

来源:至顶网计算频道

好文章,需要你的鼓励

让AI记住房间每个角落:悉尼大学团队如何让视频生成拥有“空间记忆“

悉尼大学和微软研究院联合团队开发出名为Spatia的创新视频生成系统,通过维护3D点云"空间记忆"解决了AI视频生成中的长期一致性难题。该系统采用动静分离机制,将静态场景保存为持久记忆,同时生成动态内容,支持精确相机控制和交互式3D编辑,在多项基准测试中表现优异。

西班牙病毒如何将谷歌带到马拉加

33年后,贝尔纳多·金特罗决定寻找改变他人生的那个人——创造马拉加病毒的匿名程序员。这个相对无害的病毒激发了金特罗对网络安全的热情,促使他创立了VirusTotal公司,该公司于2012年被谷歌收购。这次收购将谷歌的欧洲网络安全中心带到了马拉加,使这座西班牙城市转变为科技中心。通过深入研究病毒代码和媒体寻人,金特罗最终发现病毒创造者是已故的安东尼奥·恩里克·阿斯托尔加。

马里兰大学突破性发现:AI推理过程终于有了“身体检查“——ThinkARM框架揭开大型语言模型思维奥秘

马里兰大学研究团队开发ThinkARM框架,首次系统分析AI推理过程。通过将思维分解为八种模式,发现AI存在三阶段推理节律,推理型与传统AI思维模式差异显著。研究揭示探索模式与正确性关联,不同效率优化方法对思维结构影响各异。这为AI系统诊断、改进提供新工具。

生命科学计算测试专委会正式成立,BioProfile框架引领行业标准建设

超智算完成北京核心智算中心资产收购,加速构筑“3+X”全国算力网络新格局

走出“参数崇拜”:联想用“一体多端”重塑“人的尺度”

从“单点突破”到“一体多端”:拆解天禧AI 3.5进化背后三年的进化哲学

openGauss Summit 2025在京召开,加速行业智能化变革,共建繁荣数据库生态

2025联想天禧AI生态伙伴大会:天禧AI一体多端,与开发者共建个人AI生态

西班牙病毒如何将谷歌带到马拉加

LangChain核心库曝出严重漏洞,AI智能体机密信息面临泄露风险

Mill如何与亚马逊和全食超市达成合作协议

TechCrunch创业大赛中的9家顶尖生物技术初创公司

2025年印度科技领域十大重要发展

中科大发布Live Avatar:AI数字人无限聊天不翻车