英特尔坚持在下一代IPU中使用FPGA与ASIC

芯片巨头表明心志:到2024年继续推进ASIC/FPGA多架构发展路线

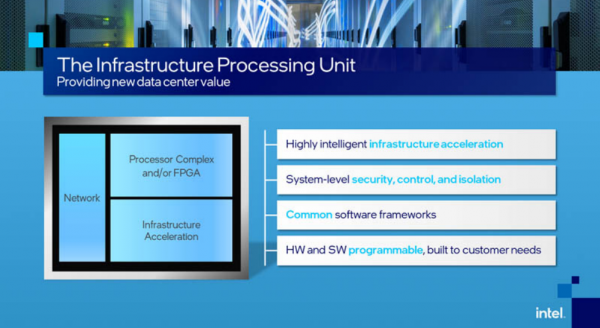

在本周召开的Intel Vision大会上,英特尔再次强调了其双管齐下的ASIC/FPGA基础设施处理单元(IPU)发展战略。此次会上,英特尔还展示了即将推出的400 Gb/秒与800 Gb/秒设备。

根据英特尔以太网事业部总经理Patty Kummrow的解释,该公司一直在关注从超大规模数据中心到边缘计算的各个领域,并感受到了市场对于特定领域处理器(例如IPU)的强劲需求。

她在新闻发布会上表示,“IPU已经从根本上改变了数据中心的架构形式。”

英特尔的IPU(也被称为smartNIC,或者数据处理单元DPU)主要负责承担并加速与网络、存储和安全类应用相关的输入/输出密集型工作负载。

Kummrow解释道,“IPU为我们带来了一系列以往难以想象的优势,其中之一就是将基础设施与租户工作负载剥离开来。当我们把这些基础设施功能拆分出去,并把腾出的CPU核心用于处理租户工作负载时,也就实现了负载加速效果。而IPU就是为承接这些功能所专门构建的硬件方案。”

双管齐下的解决思路

有趣的是,英特尔在最新的产品发展路线图中只提到了更高吞吐量,此外对于下一代IPU的细节几乎没有任何提及。但芯片巨头披露,他们至少会把目前多架构ASIC/FPGA的设计方针延续至2024年。

英特尔的400 Gbps Mount Morgan和Hot Springs Canyon IPU分别计划于2023年底和2024年初发布,同时计划在2025年和2026年推出两款IPU的800 Gbps版本。

英特尔还为即将推出的Mount Evans和Oak Springs Canyon IPU公布了出货日期——“今年晚些时候”。好吧,属于公布了、但又没完全公布。考虑到新款Sapphire Rapids至强处理器和7纳米制程双双落后于计划,芯片巨头在守时方面好像并不是那么靠谱,所以大家姑且一听。

去年的英特尔架构日活动中,Mount Evans首次亮相,也成为芯片巨头第一款基于ASIC的IPU。这款200 Gb/秒 smartNIC专为以性能为最高诉求的超大规模数据中心环境所设计。根据我们掌握的消息,该芯片已经被纳入谷歌和“其他服务供应商”的部署计划。

与此同时,基于Agilex FPGA的Oak Springs Canyon则保持着与ASIC兄弟产品相同的吞吐量,只是受众主要是电信服务商。

根据Kummrow的介绍,这种多面开发的方法能够在客户的性能与灵活性需求间提供最佳平衡点。

例如,在Oak Springs Canyon方面,“客户可以随意进行重新编程,从而在设备上运行不断变化的工作负载。”相比之下,基于ASIC的Mount Evans IPU就没那么灵活,但却能够提供更好的功率/性能比。

她还补充道,“使用ASIC SoC,性能与功率优化水平更高,这是因为所有功能都围绕硬件特性打造而成。”

尽管架构有所区别,但英特尔的AISC与FPGA版IPU采用的是同一种通用编程语言,即基础设施程序员开发套件(IPDK)。

Kummrow总结道,IPDK正是帮助开发人员释放底层硬件价值的关键所在。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元