软硬协同 英特尔XPU全面创新加速HPC与AI融合发展

一场新型冠状病毒肺炎疫情,让全球进入非常时刻,不过“科技力量”的加入让抗击疫情有了更多不一样,比如HPC高性能计算技术在寻找病毒来源、获知病毒结构、筛选抗毒小分子方面发挥了重要的作用。

英特尔副总裁兼高性能计算部总经理Trish Damkroger告诉记者,HPC是实现很多伟大的科学创新的重要工具。几乎所有涉及疫情的研究工作都离不开HPC基础设施。“英特尔至强仍然是算力的基础,是大多数HPC系统的核心所在。因此,英特尔至强处理器被应用在很多抗击疫情的工作当中,是全球超级计算机中部署最广泛的计算架构,持续助力全球医学探索和科学突破。”

如今,高性能计算变得无处不在,HPC基础设施正变得越来越普遍。例如高尔夫运动器材制造商Ping利用高性能计算设计具有更好性能的球杆;铁路公司利用可靠的天气预报系统避免火车脱轨事故;药剂师利用机器学习识别药物中的有害成分;能源类公司通过对电厂机械进行全生命周期的模拟,能够在不大幅提高成本的情况下改进其运行和维护。

Trish表示,低延迟、高带宽、密集计算——这就是 HPC。密集计算,就是一次进行大量计算,所以需要对数据进行快速传输的能力。所谓“快速”是低延迟,而数据的移动有赖于高带宽。“英特尔持续推动E级计算,在 CPU、XPUs、oneAPI工具包、E级DAOS存储和高速网络方面的突出优势正在逐步将这一目标变为现实。”

更多的数据、用户和工作负载类型组合在一起,意味着对性能的要求比以往任何时候都更加复杂。而对于高性能计算的性能优化要在各个关键方面同时进行,而不是某“一个”方面——如CPU速度、内存容量、I/O或内存。

因此,英特尔开发了无与伦比的高性能计算产品组合,涵盖通用计算、专用加速、独特的持久内存和E级存储、高性能互连和创新安全功能,能够轻松为各类使用场景提供适用的平台。

在硬件平台方面,英特尔提供XPU产品,特别是英特尔第三代至强可扩展处理器的推出,高性能计算系统将在性能方面实现巨大的代际飞跃。

得益于核心架构的改进,英特尔第三代至强可扩展处理器每个时钟的指令条数实现20%的跃升,高达40个核心,每个核心可以使用8个内存通道,可以提供6TB的系统内存容量。

虽然相比其他厂商的产品,在核心数方面,英特尔第三代至强可扩展处理器并不占优,但是其在12个重要的高性能计算指标方面,英特尔第三代至强可扩展处理器却实现了20%的性能领先。

而且英特尔第三代至强可扩展处理器是业内唯一内置人工智能加速的CPU,并内置灵活性功能,如Speed Select技术,可以使用单个 CPU 满足更多样化的工作负载需求。

在人工智能表现方面,英特尔第三代至强可扩展处理器在20个流行的机器和深度学习模型各项性能指标表现强于竞争对手。

除了CPU,英特尔也在GPU方面进行布局,比如基于Xe-LP的英特尔服务器显卡SG1,同时,基于Xe-HPG 的产品也即将推出。

同时,Xe-HPC系列的Ponte Vecchio GPU已经启动研发,并根据既定日程的计划正常进行开发。Ponte Vecchio是用于E级存储和人工智能方面的XPU,集成了超1000亿个晶体管,运用多种处理技术制成,并在封装时采用了Foveros和EMIB(嵌入式多芯片互连桥接)技术。

Ponte Vecchio将会支持OCP加速器模块(OAM)规格及子系统,提供高性能计算应用所需的横向与纵向扩展功能。这款GPU的架构包含计算、内存和Fabric,以满足像Aurora这样的全球最先进的超级计算机不断演进的算力需求。

如果说在硬件方面,英特尔提出了丰富的硬件产品,那么在软件方面,oneAPI旨在提供一种简单的跨架构、跨供应商的异构编程模型,该模型开放、统一且基于标准,对于开发者来说同时具备高性能与高效性。

oneAPI的三大支柱分别是:硬件的自由选择、硬件价值的充分实现,以及高性能代码的快速开发。

Trish说,XPU时代已经到来,HPC社区一直对各种技术的应用与创新满怀热情,致力于提升每秒浮点运算次数(FLOPS),从而满足由典型高性能计算工作负载、人工智能及下一个重大技术进步(the NEXT BIG THING)所驱动的迫切的计算需求。

英特尔的oneAPI工具包提供编译器、数据库及分析工具,支持英特尔硬件最新与最优的性能和功能表现,如AMX、VNNI/DL Boost和内存技术,从而让应用及工作负载表现更佳。

“英特尔的一个强大的优势在于我们广泛的软件生态系统。 所以我认为在转向异构的过程中,oneAPI会具有颠覆性的意义——这是一种简单的跨架构、跨供应商的异构编程模型,该模型开放、统一且基于标准。除此之外,我们还引入了IPU和其他计算。因此,在这个竞争激烈的环境中,oneAPI可能是我们最大的机遇。”Trish说。

高性能计算与人工智能的融合是高性能计算行业的一个关键转折点。英特尔至强可扩展处理器是唯一一款针对高性能计算和人工智能融合进行了优化的数据中心CPU,使用AVX512矢量指令集加速高性能计算应用,并通过英特尔的DL Boost技术——VNNI指令,为人工智能应用提供支持。

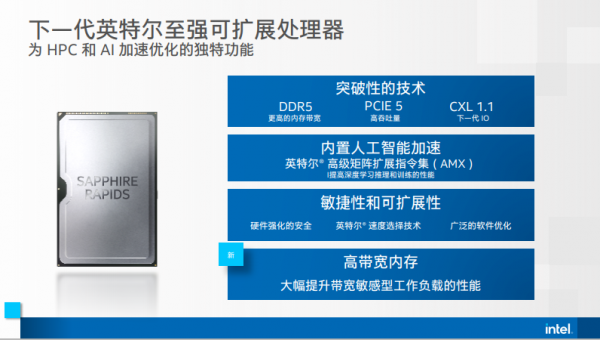

Trish还透露,代号为“Sapphire Rapids”的下一代英特尔至强可扩展处理器可以为加速高性能计算和人工智能工作负载提供独特的功能,其中包括:突破性的内存及吞吐能力——使用DDR5,与DDR4相比增加了内存带宽;对于吞吐密集型的工作负载而言,Sapphire Rapids将会提供高吞吐量,与PCI express 4.0相比,新的PCI express 5.0的吞吐带宽将会实现翻倍。

此外,Sapphire Rapids平台将具有支持行业标准Compute Express Link(CXL)1.1的下一代 I/O,支持跨计算、网络和存储的高级用例。

除了内存及吞吐方面的优化外,Sapphire Rapids还针对高性能计算及人工智能工作负载进行了额外优化,同时还配备了一个全新的内置AI加速引擎——英特尔AMX(高级矩阵扩展),旨在为深度学习推理和训练提供显著的性能提升。Sapphire Rapids也会为数据保护、平台安全以及可扩展虚拟化提供最新的硬件性能强化,其中也包括广泛的软件优化。

近年来,计算性能的增长速度远超内存带宽的限制,从而令内存限制相关的工作负载总量日益增长。英特尔将提供带有高带宽内存(HBM)的Sapphire Rapids版本,这将显著提高CPU的可用内存带宽。额外的内存带宽将大幅提升内存带宽敏感的工作负载的性能,包括:建模与模拟(例如计算流体动力学、气候及天气预报、量子色动力学等)、人工智能(例如深度学习训练和推理)、分析(例如大数据分析)、内存数据库及存储等等。

目前集成高带宽内存的Sapphire Rapids处理器深成功部署在美国能源部在阿贡国家实验室的Aurora超级计算机、以及洛斯阿拉莫斯国家实验室的Crossroads超级计算机上。此外,CINECA、莱布尼茨超级计算中心(LRZ)也已经决定采用了Sapphire Rapids。

来源:至顶网计算频道

好文章,需要你的鼓励

Allen AI团队推出SAGE:首个能像人类一样“想看多长就看多长“的智能视频分析系统

Allen AI研究所联合多家顶尖机构推出SAGE智能视频分析系统,首次实现类人化的"任意时长推理"能力。该系统能根据问题复杂程度灵活调整分析策略,配备六种智能工具进行协同分析,在处理10分钟以上视频时准确率提升8.2%。研究团队创建了包含1744个真实娱乐视频问题的SAGE-Bench评估平台,并采用创新的AI生成训练数据方法,为视频AI技术的实际应用开辟了新路径。

联想推出DE6600系列:更智能的存储解决方案

联想推出新一代NVMe存储解决方案DE6600系列,包含全闪存DE6600F和混合存储DE6600H两款型号。该系列产品延迟低于100微秒,支持多种连接协议,2U机架可容纳24块NVMe驱动器。容量可从367TB扩展至1.798PiB全闪存或7.741PiB混合配置,适用于AI、高性能计算、实时分析等场景,并配备双活控制器和XClarity统一管理平台。

AI视觉模型真的能看懂长篇文档吗?中科院团队首次揭开视觉文本压缩的真相

中科院团队首次系统评估了AI视觉模型在文本压缩环境下的理解能力,发现虽然AI能准确识别压缩图像中的文字,但在理解深层含义、建立关联推理方面表现不佳。研究通过VTCBench测试系统揭示了AI存在"位置偏差"等问题,为视觉文本压缩技术的改进指明方向。

数智时代,openGauss Summit 2025即将发布哪些技术创新破局

“算力+储能”深度融合:超智算发布分布式算力超级节点储能解决方案

联想推出DE6600系列:更智能的存储解决方案

创业公司如何在严格监管行业中实现生死攸关的创新

OpenAI发布GPT-5.2-Codex模型,软件工程自动化能力大幅提升

Waterfox浏览器宣布拒绝AI功能,瞄准Firefox忠实用户

TikTok美国业务出售交易将于下月完成

破局AI数据中心安全瓶颈:Fortinet联合NVIDIA引领隔离式加速新航向

智算中心进化论,科华数据如何做到“更懂”

更高负载、更快建设:2026年数据中心六大趋势

Snowflake数据库更新引发全球大规模服务中断

AI编程初创公司Lovable融资3.3亿美元,英伟达等科技巨头支持