英特尔、第四范式联合研究成果入选国际顶会VLDB

傲腾™持久内存加持 优化万亿维特征在线预估系统

近日,英特尔与第四范式联合实验室以及新加坡国立大学的最新联合研究成果——基于英特尔® 傲腾™持久内存的特征工程内存数据库,被国际顶级数据库学术会议VLDB(Very Large Data Base)作为常规研究论文录取。VLDB与SIGMOD并称为数据库业界的两大最顶级学术会议,收录研究机构以及工业界在数据库领域最前沿、最顶级的研究成果。英特尔与第四范式此次合作录取的论文以解决在线预估系统的业务需求和痛点为目的,针对如何设计底层数据库组件来高效支撑万亿维稀疏特征在线预估系统,以及如何基于英特尔® 傲腾™持久内存进一步解决业务和系统设计的痛点等两方面进行创新性设计和全面优化。

如今,越来越多的企业意识到了AI在企业经营、决策中的重要作用,AI迎来了落地应用爆发期。作为AI落地的关键组件,超高维在线预估系统基于实时提取的超高维特征和预先训练的模型对业务数据进行实时评估,因而被广泛应用在欺诈交易识别、个性化推荐等在线实时推理业务场景中。

为了支撑高性能的实时特征存取需求,业界诞生了诸多实时内存数据库。然而,伴随着业务的持续扩张和数据量的指数级增长,实时内存数据库所存在的潜在弊端与风险使其难以高效、低成本的满足不断增长的业务硬实时需求:

- 高性能特征存取对计算资源消耗巨大:为了保障线上服务的性能,特征工程内存数据库对内存的容量要求极高,企业通常需要配备20-30台机器以满足高性能计算需求所需的内存容量,总体拥有成本(TCO)居高不下。

- 服务中断恢复所需周期长,严重影响企业线上服务质量:企业线上服务对服务质量的要求极高,然而通常情况下服务中断(软硬件错误宕机、例行维护等)往往需要几个小时的恢复时间,业务长时间掉线严重影响线上服务质量。

- 长尾延迟:使用基于内存的特征工程数据库保障了线上服务的高性能,但是数据备份依然会落盘到性能较差的外存储设备上,导致某些场景出现长尾延迟,严重影响服务质量。

为解决以上问题,第四范式自主研发了实时特征工程内存数据库FEDB(Feature Engineering Database)。作为面向AI硬实时场景的分布式特征数据库,FEDB所具备的高效计算、读写分离、高并发、高性能查询等特性,使得特征工程的效率和性能达到最大化。

在充分发挥FEDB价值的基础上,第四范式引入英特尔® 傲腾™持久内存技术,以及创新性的持久化数据结构,全面支撑AI硬实时、低成本、高计算性能等需求的实现。双方基于英特尔® 傲腾™持久内存,使用App Direct Mode,开发优化持久化数据结构,完全摒弃了FEDB原有的基于外存储设备的数据持久化架构,不仅充分利用了持久内存大容量、持久性的特性,而且将持久化操作带来的性能损耗降至最小。

该工作主要的创新性优化技术包括“持久化智能指针”以及利用原子操作“持久化比较并交换”(Atomic Persistent Compare-And-Swap")的解决方案。一方面,持久化智能指针巧妙地利用了64位操作系统中64位宽指针不被使用的低4位来标记目标地址的数据是否已持久化;另一方面,针对“比较并交换操作”(CAS),传统指令缺少持久化语义,因而无法在持久内存中直接作为带有持久化特性的原子操作来使用的难点,双方引入了新的“读前持久化”(flush-before-read)概念,利用持久化智能指针,保证“持久化比较并交换” (Persistent CAS)正确性的同时,最大化减少持久化带来的性能损耗。

此项工作的研究成果表明,基于英特尔® 傲腾™持久内存的FEDB可有效满足企业超高维稀疏特征在线预估场景的需求,在保证线上推理服务超高性能的同时,大幅降低了企业AI整体投入成本,提升了线上服务的质量,进一步扫清了企业AI规模化应用的障碍。

- 英特尔® 傲腾™持久内存的加持满足特征工程数据库对大内存的需求。下图显示了在论文实验中使用的机器配置,在10TB数据的业务场景中,基于持久内存的FEDB的硬件成本仅为基于纯内存版本的41.6%。

硬件成本比较(10TB业务数据)

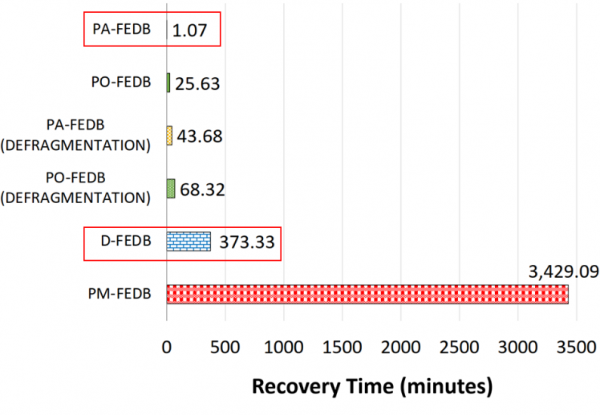

- 在服务中断情况下实现数据快速恢复,服务恢复时间减少99.7%,全面降低对线上服务质量的影响。如在论文中描述的结果(见下图,PA-FEDB为基于持久内存优化的FEDB,D-FEDB为内存版本的FEDB),在实际业务场景中,其数据恢复时间从原来的六个小时缩短至一分钟左右。

数据恢复时间比较

持久内存(PA-FEDB)vs. 纯内存(D-FEDB)

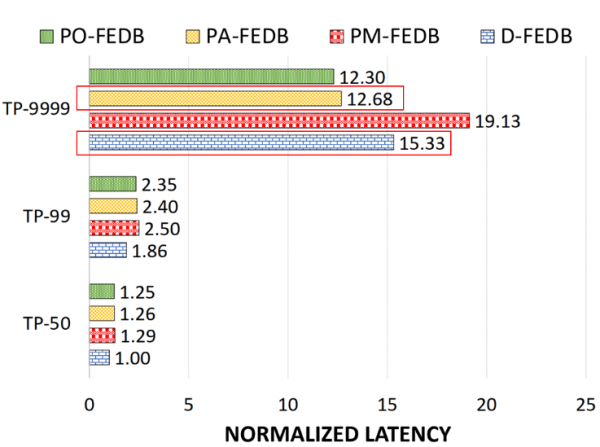

- 基于英特尔® 傲腾™持久内存进行持久化数据结构设计的FEDB舍弃了原有纯内存方案以及基于外存储设备的备份机制,实现了长尾延迟(TP-9999)接近20%的改善(见下图,PA-FEDB为基于持久内存优化的FEDB,D-FEDB为内存版本的FEDB )。

长尾延迟TP-9999比较

持久内存(PA-FEDB)vs. 纯内存(D-FEDB)

未来,英特尔与第四范式联合实验室还将在软硬一体技术、面向AI的高性能计算等方面展开深入合作,结合英特尔领先的软硬件产品以及第四范式在AI领域的深厚积累、研发优势,推动AI技术的创新和落地,加速企业规模化AI应用进程,共同引领AI产业化发展。

来源:业界供稿

好文章,需要你的鼓励

Cyera获得4亿美元融资专攻AI数据安全,估值达90亿美元

人工智能和数据安全公司Cyera宣布完成4亿美元后期融资,估值达90亿美元。此轮F轮融资由贝莱德领投,距离上次融资仅6个月。随着95%的美国企业使用生成式AI,AI应用快速普及带来新的安全挑战。Cyera将数据安全态势管理、数据丢失防护和身份管理整合为单一平台,今年推出AI Guardian扩展AI安全功能。

上海AI实验室研究者想出妙招:让AI像优秀学生一样高效思考,告别“想太多“毛病

上海AI实验室开发RePro训练方法,通过将AI推理过程类比为优化问题,教会AI避免过度思考。该方法通过评估推理步骤的进步幅度和稳定性,显著提升了模型在数学、科学和编程任务上的表现,准确率提升5-6个百分点,同时大幅减少无效推理,为高效AI系统发展提供新思路。

SAP推出全新AI功能助力零售业数字化转型

SAP在2026年全国零售联盟大展上发布了一系列新的人工智能功能,将规划、运营、履约和商务更紧密地集成到其零售软件组合中。这些更新旨在帮助零售商管理日益复杂的运营,应对客户参与向AI驱动发现和自动化决策的转变。新功能涵盖数据分析、商品销售、促销、客户参与和订单管理等领域,大部分功能计划在2026年上半年推出。

MIT团队让机器人终于不再“卡顿“:一种让机器人像人一样流畅反应的突破性技术

MIT团队开发的VLASH技术首次解决了机器人动作断续、反应迟缓的根本问题。通过"未来状态感知"让机器人边执行边思考,实现了最高2.03倍的速度提升和17.4倍的反应延迟改善,成功展示了机器人打乒乓球等高难度任务,为机器人在动态环境中的应用开辟了新可能性。

SAP推出全新AI功能助力零售业数字化转型

Gmail推出个性化AI收件箱与智能搜索等多项新功能

CISA警告HPE OneView和微软Office漏洞正被活跃利用

谷歌削减Android开源代码发布频率至每年两次

高通CES 2026:扩展IE-IoT产品组合推进边缘AI发展

恩智浦发布S32N7处理器系列,加速AI驱动汽车发展

n8n自动化平台严重漏洞可让攻击者完全控制服务器

微软将在Copilot中直接集成购买按钮功能

Snowflake收购Observe拓展AI驱动监控能力

丰田升级SUV产品线,RAV4新增信息娱乐系统

可信开源软件现状报告:AI重塑技术栈基线

思科修复ISE安全漏洞,公开概念验证代码已发布