英特尔EMIB技术助力实现芯片间互连互通

当今智能手机、电脑和服务器中的大多数芯片都是由多个较小芯片密封在一个矩形封装中来组成的。

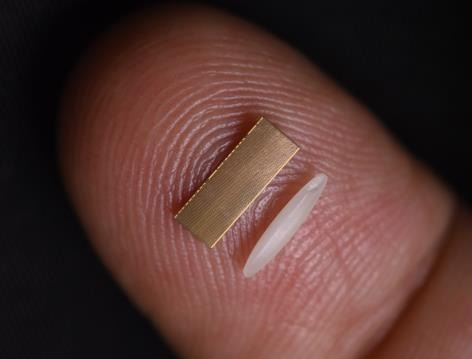

这些通常而言包括CPU、图形卡、内存、IO等在内的更多芯片是如何进行通信的?一种被称为EMIB(嵌入式多芯片互连桥接)的英特尔创新技术将带给你答案。它是一种比一粒米还小的复杂多层薄硅片,可以让相邻芯片以惊人的速度来回传输大量数据,高达每秒数GB。

英特尔EMIB(嵌入式多芯片互连桥接)技术帮助实现包括CPU、图形卡、内存、IO及其它多个芯片间的通信。EMIB是一个比一颗香米粒还小的复杂多层薄硅片,可以在相邻芯片间传输大量数据。(本图已获Walden Kirsch/英特尔公司授权)

当前,英特尔EMIB加速了全球近100万台笔记本电脑和FPGA(现场可编程门阵列)设备之中的数据流。随着EMIB技术更加主流化,这个数字将很快飙升,并覆盖更多产品。例如英特尔于11月17日发布的“Ponte Vecchio”通用GPU,就采用了EMIB技术。

为了满足客户的独特需求,这种创新技术允许芯片架构师以前所未有的速度将专用芯片组合在一起。传统的被称为中介层(interposer)的竞争设计方式,由内部封装的多个芯片放置在基本上是单层的电子基板上来实现的,且每个芯片都插在上面,相比之下,EMIB硅片要更微小、更灵活、更经济,并在带宽值上提升了85%。如此可以让你的产品,包括笔记本电脑、服务器、5G处理器、图形卡等运行起来快得多。下一代EMIB还可以使这个带宽值提高一倍甚至三倍。

好文章,需要你的鼓励

亚马逊全新通用型EC2 M8a实例正式发布

AWS与AMD联合发布Amazon EC2 M8a实例,搭载第五代AMD EPYC处理器,最高频率4.5GHz。相比M7a实例性能提升30%,性价比提升19%。支持最高192个vCPU和768GB内存,网络带宽达75Gbps,EBS带宽60Gbps。适用于Web托管、微服务架构、数据库等通用工作负载,已在美国俄亥俄、俄勒冈和欧洲西班牙区域上线。

香港中大联合牛津等名校:AI视频已能完美骗过人工智能检测,连顶级模型都认不出真假

香港中文大学等顶尖院校联合研究发现,当前最先进的AI视频生成技术已能制作出连顶级检测系统都无法识别的假视频。研究团队开发了Video Reality Test平台,测试结果显示最强生成模型Veo3.1-Fast的假视频仅有12.54%被识别,而最强检测系统Gemini 2.5-Pro准确率仅56%,远低于人类专家的81.25%。研究还发现检测系统过度依赖水印等表面特征,音频信息能提升检测准确性,但技术发展已对信息真实性判断带来严峻挑战。

IBM推出SAP迁移管理工具应对2027年系统升级截止期

IBM发布了适用于SAP的IBM咨询应用管理套件,利用生成式和代理AI简化并加速现代化进程。SAP传统ECC系统支持将于2027年结束,但目前仅45%的组织已迁移到新的S/4HANA系统。IBM的工具可创建符合客户标准的特定代码更改,提供主动监控和影响分析。然而分析师指出,迁移工具未能解决核心问题:价值创造,因为客户需要处理多年积累的ECC系统定制化技术债务。

Google DeepMind让AI画图快了一半,“预览模式“让创作者告别漫长等待

Google DeepMind团队提出了革命性的"扩散预览"模式,通过ConsistencySolver技术实现AI图像生成的"预览+精修"工作流程。该技术能在5-10步内生成高质量预览图像,与传统40步完整生成保持高度一致性,用户体验测试显示总体时间节省近50%,大大提高了创作效率和创意探索的自由度。

企业AI价值实现的五大人力准备障碍

企业AI PC普及将在2026年放缓

AI闪耀中国!联想天禧AI亮相吴晓波科技人文秀

亚马逊全新通用型EC2 M8a实例正式发布

IBM推出SAP迁移管理工具应对2027年系统升级截止期

博通AI硬件收入激增65%,VMware业务稳健增长

英伟达发布Nemotron 3开源模型助力可扩展多智能体系统

从AI到模拟对抗,网络安全桌面演练今年有了新变化

Equity 2026年预测:AI智能体崛起、重磅IPO与风投行业变革

英伟达护城河难撼动,Gemini无法击败OpenAI

山河为证,荣誉加冕,华为乾崑助传祺向往S9首次智行中国顺利收官

全国首批10城菁彩Vivid影厅启幕,《山河故人》重映见证影像新纪元