英特尔Xe DG1离散GPU芯片已在实验室内得到验证

过去几年以来,英特尔公司一直不遗余力地强调其进军离散GPU市场的计划,目标自然是阻击已经在消费级PC以及数据中心领域大放异彩的AMD与英伟达显卡。从历史角度来看,英特尔公司其实习惯于藏起前瞻性产品的细节信息,并在临近上市时突然公布,从而获得爆炸式的宣传效果。但作为GPU市场上的后发者,英特尔与PC游戏以及技术爱好者社区进行了直接接触,解答并提出关于离散GPU计划的问题,甚至先后披露了上市策略、下一代GPU架构、即将实现的功能与性能目标乃至未来显卡设计的渲染图。这一系列操作下来,实在让人有点不太适应。

英特尔离散GPU概念图。

英特尔曾经表示,计划在2020年年内正式进军离散GPU市场。为此,芯片巨头当然需要提前准备,确保已经完成能够接受验证测试与试用的内部可用芯片方案。就目前来看,英特尔方面似乎做好了战斗准备。事实上,在最近的财报电话会议上,英特尔公司CEO Bob Swan确认了其下一代离散GPU(从技术角度讲,这也是英特尔首款离散GPU)已经完成工厂试生产并开始接受初步通电验证。

在会议当中,Swan表示“今年第三季度,我们还发布了首款10纳米Agilex FPGA。2020年,我们将继续通过多款振奋人心的新产品扩展10纳米产品组合,其中包括AI推理加速器、5G基站SOC、用于服务器存储及网络的至强CPU,外加一款离散GPU。本季度,我们已经成功完成了首款离散GPU,即DG1的通电测试。”Swan又进一步补充称,这一成就堪称“重要的发展里程碑”。

几个月之前,泄露的英特尔显卡驱动程序信息让我们得以一窥下一代Rocket Lake处理器的真容,其指向的正是第12代英特尔GPU。当时,人们猜测新一代GPU将包含128到512个处理单元,用于提供低功耗与高功耗两种图形解决方案。其中一款GPU将带有DG1标识,因此目前芯片巨头强调的离散解决方案可能正是上述设计的一款衍生产品。当然,作为第一款离散GPU,DG1有可能只是入门级产品,甚至是单纯的开发工作。

就在Swan发布声明的同时,Twitter上也出现了英特尔图形技术团队几位主要成员的神秘推文。英特尔公司高级副总裁、首席架构师兼架构、图形与软件总经理Raja Koduri在Twitter上发文称,“ It’s been quite a Dash”。有人猜测,大写Dash中的“D”肯定有着某种含义。截至目前,大多数关注者已经认定DG1代表的是“离散GPU 1号”,但D也有可能代表Dash、也就是破折号。英特尔公司图形与视觉技术高层总监Chris Hook则在推文中指出,“它活了!”这显然是取自小说《弗兰肯斯坦》中,科学怪人在通电后获得生命的重要瞬间。

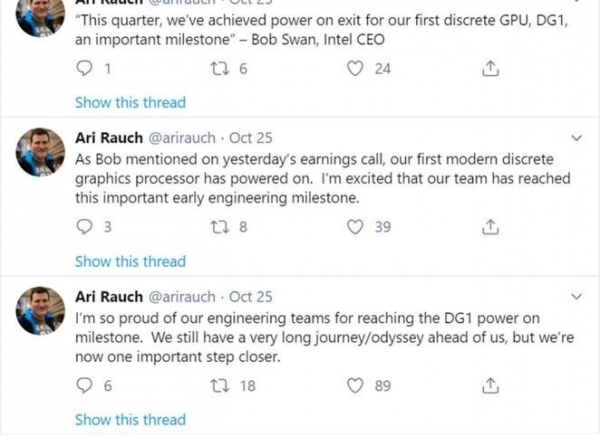

英特尔公司图形技术与产品集团副总裁Ari Rauch则就离散GPU发表了多条推文,他的表述可就直白多了。一条推文提到,“我为我们工程技术团队达成的DG1发展里程碑感到自豪。我们还有很长的路要走,但现在的这一步无疑至关重要。”其他英特尔人士也发表了类似的观点。

英特尔公司Ari Rauch接连发推。

由于Swan在今年第三季度(截至9月30日)的财报电话会议上披露了DG1项目,我们可以假定英特尔已经在10月之前完成了这款离散GPU的开机通电验证。换句话说,又是近一个月过去,英特尔方面可能已经开始在该GPU上运行3D应用进行实际测试。当然,这一切都只是猜测。

无论实际情况如何,英特尔公司的离解GPU计划确实在不断推进;而且几乎可以肯定的是,目前的所有努力,都是为了实现芯片巨头定下的2020年发布离散Xe GPU的目标。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元