瞄准数据中心应用场景 英特尔推出全新PAC加速卡 原创

至顶网服务器频道 09月30日 新闻消息(文/李祥敬): 随着市场对大数据和人工智能(AI)需求的增长,FPGA的可再编程技术可以满足数据中心应用的处理要求,适应其不断变化的工作负载。借助可再配置的逻辑、内存和数字信号处理模块,FPGA可通过适当编程来执行任何类型的功能,同时实现高吞吐量和实时性能,因而适用于许多关键的企业和云应用。

近日,英特尔推出了采用英特尔Stratix 10 SX FPGA(英特尔超强大的FPGA)的全新英特尔可编程加速卡(PAC),以扩充其现场可编程门阵列(FPGA)加速平台产品组合。借助面向英特尔至强CPU及FPGA的加速栈,这款高带宽卡可为数据中心开发人员提供强大的平台,用于部署基于FPGA的加速工作负载。

据悉,HPE将成为首家将采用Stratix 10 SX FPGA的英特尔PAC,和面向英特尔至强可扩展处理器及FPGA的英特尔加速栈,整合至其服务器产品的OEM。

英特尔可编程解决方案事业部产品市场总监Sabrina Gomez表示,这是英特尔第二款可编程加速器产品,可以极大地丰富我们面向数据中心可编程加速器平台整个产品的组合。“所谓丰富的话并不是要取代之前的加速卡产品,因为这些不同代的产品能力、大小和功耗设计是不一样的,互为补充,并不是有了这款功能更强大的产品就取代了之前一代的产品。”

与之前宣布的采用英特尔Arria 10 FPGA的英特尔PAC一样,全新采用Stratix 10 SX FPGA的英特尔PAC支持设计合作伙伴生态系统,他们致力于交付广泛应用工作负载的加速IP。采用Stratix 10 SX FPGA的英特尔PAC是一种外形更大的卡,专为内嵌处理和内存密集型工作负载而构建,如流分析和视频转码。而外形较小的采用Arria 10 FPGA的英特尔PAC适用于回溯测试、数据库加速和图像处理等工作负载。

Sabrina介绍说,全新英特尔可编程加速卡(PAC)使用了Stratix 10的FPGA,它的密度是前一代产品的两倍,可以支持280万个逻辑单元。而且,它使用的是支持DDR4 DIMM的内存,内存的密度也比以前更大。

相比采用Arria 10 FPGA的英特尔PAC,此次推出的PAC的应用场景更多广泛,比如人工智能、基因组学、风险管理等。“全新的产品给了客户更大的选择能力。客户可以根据他所需要的性能、带宽、功耗以及体积的要求,选择适合他们自己的加速卡产品。”Sabrina说。

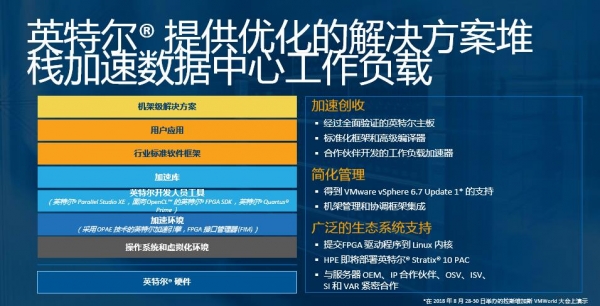

面向英特尔至强CPU及FPGA的加速栈支持行业领先的操作系统、虚拟化和编排软件,它能够为软件开发人员提供一种通用接口,帮助他们更快速实现商用、简化管理以及利用日益扩大的加速器工作负载生态系统。

本解决方案包括:

- 英特尔过验证的采用英特尔Stratix 10 SX FPGA的英特尔可编程加速卡(PAC)。

- 英特尔以及合作伙伴的AFU都可以连接的量产级别FPGA接口管理器(FIM)。

- 面向英特尔至强CPU及FPGA的加速栈,包括一套常用的API和开源驱动程序,它们能够与行业领先操作系统、虚拟化及协调软件无缝配合。该加速栈支持英特尔可编程加速卡(PAC)产品家族。

- 支持本地,网络连接的工作负载;初始合作伙伴包括Adaptive Microware和Megh Computing,更多合作伙伴正在加入进来。

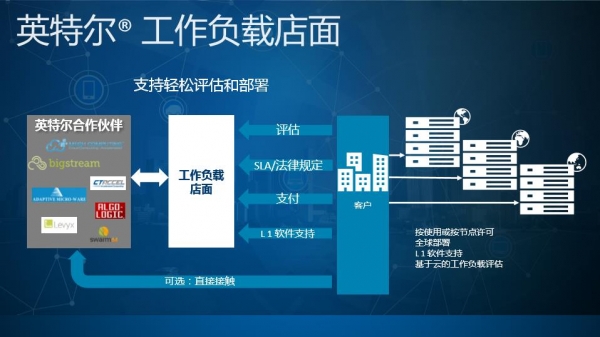

- 通过加速负载商店,提供的工作负载帮助客户简化评估过程。

通过这种优化的解决方案堆栈,加速数据中心工作负载,企业可以获得三种好处:一个是能够更快地实现创收、第二个是管理简化、第三个是更广泛的生态系统支持。

为了实现广泛的合作伙伴支持,英特尔支持FPGA驱动程序提交到Linux内核,这样可以获得广泛的Linux支持,也可以支持很多不同的操作系统。英特尔还与合作伙伴推出了工作负载店面,帮助客户对工作负载进行评估和部署,进而实现工作负载按使用或按节点许可,优化自身的工作负载。“第一阶段评估是为了让大家能够更容易地采纳我们的产品,第二个阶段是让用户更容易地部署我们的产品。”

对于未来加速卡的发展前景,Sabrina表示,企业级数据中心应用是很大的市场,未来云端也会有更多FPGA的部署,加速产品的市场规模还是非常大的,而且英特尔处在一个很有利的位置。“目前,英特尔加速卡还是以数据中心应用为主,但是未来会扩展到更多的行业,包括联网、基础设施、物联网、边缘计算等等。FPGA加速市场还是很光明的。”

最后,Sabrina总结说,全新PAC加速卡是英特尔第二代的加速产品,丰富了整个加速平台产品的组合。这款产品可以提高数据中心的效率,降低数据中心的能耗,以及总的拥有成本(TCO)。另外,它支持内嵌处理以及内存需要比较大的一些应用,比如说编解码和流分析、视频编解码等。全新的加速工作负载将显著增强数据中心的功 能,并提高其容量。最后,英特尔PAC加速卡有很广泛的合作伙伴支持,英特尔软件堆栈和生态系统支持在数据中心内无缝集成,并支持从芯片到协调层的整个过程,从晶片到编排层都有端到端的支持。

好文章,需要你的鼓励

软银完成对OpenAI的225亿美元投资,持股比例达11%

软银集团已完成对OpenAI的400亿美元投资,向其转账225亿美元。此次投资使软银获得约11%的OpenAI股份,成为仅次于微软的第二大投资者。OpenAI将利用这些资金推进Starlink数据中心项目,计划到2029年在美国部署100亿瓦的计算能力。为完成此次投资,软银出售了部分投资组合资产,包括英伟达和T-Mobile股票,并以ARM股份作抵押获得贷款。

MBZUAI和法国综合理工学院最新突破:让AI写作比人工快4倍的神奇算法

MBZUAI和法国综合理工学院联合开发的SchED算法能让AI写作速度提升3-4倍。该算法通过监测AI生成文本的置信度,采用进度感知的动态阈值策略,在保持99.8%-100%原始质量的同时显著减少计算时间。实验覆盖多种任务类型,证明了算法的有效性和鲁棒性。

苹果在2026年笔记本电脑出货量下滑中占据有利地位

TrendForce将2026年笔记本市场预测下调至1.73亿台,同比下降5.4%。报告指出,若内存短缺未改善,下滑幅度可能达10.1%。尽管面临挑战,苹果预计将在2026年春季推出低成本MacBook,并凭借供应链效率和规模优势减少影响。IDC警告称,由于AI数据中心需求激增导致内存芯片严重短缺,PC出货量可能下滑9%,平均售价将上涨4-8%。

西安交通大学突破性发现:让AI“忽略“功能词,视觉语言模型免费获得超强防御力

西安交通大学研究团队发现,AI视觉语言模型容易受到功能词(如"是"、"的"等)的干扰而遭受攻击。他们开发了功能词去注意力(FDA)机制,让AI减少对这些词汇的关注。测试显示,该方法可将攻击成功率降低18%-90%,而正常性能仅下降0.2%-0.6%。FDA无需额外训练即可集成到现有模型中,为AI安全防护提供了简单有效的解决方案。