稳定高效扩展灵活 杰和发布四路服务器GCR2524MP-RF

ZD至顶网服务器频道 04月21日 新闻消息: 2017年4月20日,杰和在深圳发布了稳定高效、灵活扩展的全新四路服务器GCR2524MP-RF,这是继2016年10月发布2U双子星、四子星服务器后在服务器市场上的又一力作。

厚积薄发,以技术驱动市场

近年来,高性能计算(HPC)已逐渐成为全球成长最快的市场之一。根据IDC预测,该市场将继续增长,从2014年的210亿美元增长到2019年的310亿美元。各个行业和领域对快速计算、数字模拟和制定更明智决策的需求持续推动着高性能计算的快速发展。

作为一家领先的云计算、大数据、物联网设备和解决方案提供商,杰和拥有强大的技术创新和研发能力,在ICT领域有着深厚的技术积累和行业经验。在2015、2016年连续荣膺英特尔DCG、CTE服务创新奖,是英特尔重要合作伙伴。

为了更好地服务市场,杰和近年紧随业界前沿推出多款主流新品,为整个服务器市场的发展注入了新型血液。本次发布的杰和四路服务器GCR2524MP-RF新品具有多项RAS特性,能够为客户提供极具竞争力的关键业务服务器解决方案。在计算性能方面能提供业界领先的高效体验,同时在稳定性、可靠性、扩展性和管理等多方面均有突破,可广泛应用于数据库、商业智能分析、在线交易和虚拟化等关键业务应用场景。专业可信的杰和服务器将成为客户应对时代挑战、赢得未来商机的卓越之选。

稳定高效,扩展灵活的四路服务器

互联网+时代,随着云计算、大数据、Web等技术趋势对各行各业乃至社会生活的不断渗透,企业对数据中心的需求不断发展,数据中心规模越来越大,如何在确保经济性的同时,获得高效、稳定、扩展灵活、高性价比的性能,满足自身对Web 技术和基础架构横向扩展的需求,成为每个企业必须面对的问题。

杰和四路服务器GCR2524MP-RF稳定高效、扩展灵活,能够为客户提供极具竞争力的关键业务服务器解决方案,在计算性能方面能提供业界领先的极致体验,同时在稳定性、可靠性、扩展性和管理与节能等多方面树立业界新标杆,可广泛应用于数据库、商业智能分析、在线交易和虚拟化等关键业务应用场景。

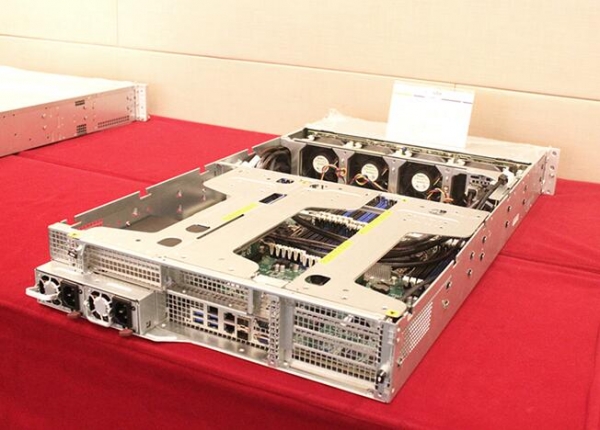

杰和四路服务器GCR2524MP-RF支持最新至强?处理器E5 4600 v4 家族,在系统计算能力、扩展能力和RAS 特性方面具备卓越设计,最大核心数提升83%,有效保证用户业务连续性和数据安全。透过杰和GIM系统管理套件,IT管理者可以随时随地借助基于Web的图形用户管理界面管理和监控服务器的状态,及时发现和排除服务器故障。值得关注的是,GCR2524MP-RF配备的硬盘、电源、风扇以及I/O等关键部件均采用全冗余设计,一旦出现故障,用户可不宕机换件,确保业务的连续性。

杰和GCR2524MP-RF具备强大的内存扩展能力,最大支持48个内存插槽,可扩展至3TB 内存容量(LRDIMM),支持 4 颗 NVMe 接口,可连接2.5寸PCIE SSD 硬盘,大幅提升系统IO吞吐能力,有效简化系统的维护难度;提供 7 个 PCI-E 3.0 扩展插槽,满足面向未来IT的企业级应用需求。此外,还集成 2 个高性能千兆网卡,2个万兆网卡(可选),轻松应对虚拟化应用对网络带宽的苛刻要求。

以客户需求为中心,构建完善营销体系

以客户需求为中心,打造稳定可靠、性能卓越、品质出众的产品,为客户提供专业可信的解决方案,一直是杰和服务器的宗旨,四路服务器GCR2524MP-RF就是这一宗旨的重要体现。

业务的发展离不开伙伴的支持,杰和国内营销中心总监杨坚表示"营销体系的设计是杰和进入企业级市场的关键一步。"未来,杰和除进一步强化与英特尔的合作外,也将通过 "客制化+分销"模式进行市场覆盖。分销渠道方面,基于共长、赋能、让利的营销宗旨,加大市场投入,优化政策,做好支撑;客制化方面将深入了解客户需求,提供"深度定制、快速交付"的产品和解决方案。杰和还将持续提升品牌影响力,支持和帮助合作伙伴的市场拓展,与合作伙伴共同做大渠道市场,最终打造完整的营销体系。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元