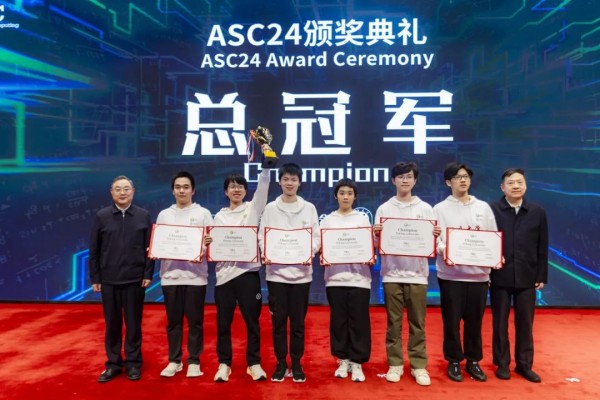

ASC24世界大学生超算竞赛落幕,北京大学、中山大学分获冠亚军

4月13日, 历时5天的2024 ASC世界大学生超级计算机竞赛(ASC24)总决赛在上海落下帷幕。经过激烈的角逐,北京大学、中山大学分获冠亚军。

ASC24总冠军 北京大学

ASC24超算大赛历时近六个月,全球共有300余支高校代表队报名参加,经过预赛选拔出的25支队伍晋级本周在上海大学举行的总决赛,现场决赛队伍数量也创下历年之最。决赛要求各参赛队伍在3000瓦功耗约束下设计安装小型超算集群,运行优化国际通行基准测试HPL&HPCG、大模型推理优化、渗流数值模拟、火星大气模拟、新型材料结构计算等前沿科学与工程应用,并参加英文答辩。总决赛期间,25支队伍还通过抽签分为五组完成超级团队赛,通过跨团队合作,共同挑战地震波模拟赛题。

ASC24总决赛竞赛现场

总决赛争夺异常激烈,最终北京大学代表队发挥出色,在火星大气模拟、大模型推理优化、神秘应用新型材料电子结构计算等多个赛题表现突出,反映出全面、深刻的超算系统与应用理解能力以及出色的性能优化能力,夺得总冠军。中山大学代表队在渗流数值模拟、火星大气模拟、HPL&HPCG等多个赛题中都取得优异成绩,获得亚军。

ASC24亚军 中山大学

台湾新竹清华大学代表队在极具挑战性的渗流数值模拟赛题中,充分利用集群计算资源,在功耗约束下成功完成应用的大规模并行优化,以最短运行时间出色完成所有测试算例,取得全场最佳成绩,获得e Prize计算挑战奖。

ASC24 e Prize计算挑战奖 台湾新竹清华大学

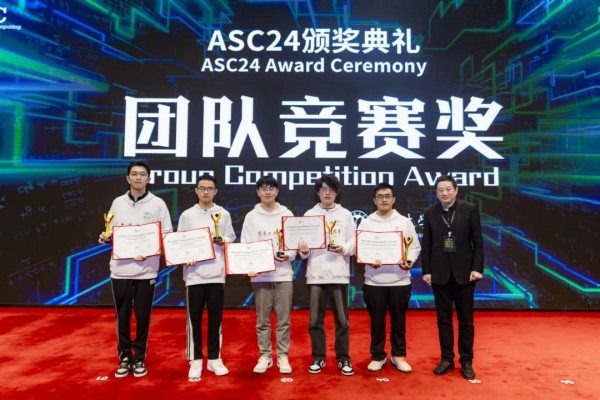

由上海大学、南方科技大学、齐鲁工业大学、西南石油大学、香港理工大学等队组成的超级团队对地震波模拟赛题实现了高效优化,获得了超级团队奖。

ASC24 超级团队奖

上海大学、南方科技大学、齐鲁工业大学、西南石油大学、香港理工大学

此外,浙江大学代表队获得了最高计算性能奖。而山西大学、上海交通大学、北京航空航天大学等队伍凭借在单项赛题上的优异表现获得了应用创新奖。

ASC24最高计算性能奖 浙江大学

ASC24应用创新奖

山西大学、上海交通大学、北京航空航天大学

ASC专家委员会主席、图灵奖获得者、田纳西大学杰出教授杰克?唐加拉(Jack Dongarra)表示:“ASC激励下一代的高性能计算科学家和工程师们,使用最尖端的技术提供创新的解决方案。ASC竞赛是世界上最大的超算竞赛,致力于培养下一代青年人才,在超算和人工智能领域探索、创新和合作。”

Jack Dongarra ASC24闭幕式致辞

上海大学党委书记成旦红表示:“上海大学高度重视超算技术的研发和应用,积极培养相关领域的优秀人才。未来上海大学将聚焦超算领域建设和发展,不断强化学科交叉、平台建设和成果转化,持续优化专业设置和人才培养体系。”

上海大学党委书记成旦红致辞

中国科学院院士、上海大学校长刘昌胜表示:“通过承办此次ASC大赛,希望能够搭建更加广阔的超算技术交流舞台,不断推动超级计算技术发展,赋能AI for Education新范式,为科研创新、社会进步和人才培养做出更大贡献。”

中国科学院院士、上海大学校长刘昌胜致辞

ASC世界大学生超级计算机竞赛(ASC Student Supercomputer Challenge)由中国发起组织,并得到亚洲及欧美相关专家和机构支持,旨在通过大赛平台推动各国及地区间超算青年人才交流和培养,提升超算应用水平和研发能力,发挥超算的科技驱动力,促进科技与产业创新。ASC超算大赛迄今已举行至第十一届,吸引来自全球六大洲上万名大学生报名参赛,是全球最大规模的大学生超算竞赛。

ASC24全体成员赛场合影

来源:业界供稿

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元

图灵奖得主Jack Dongarra出席ASC24总决赛,与超算同学面对面交流鼓励

ASC24世界大学生超算竞赛落幕,北京大学、中山大学分获冠亚军

ASC24总决赛进入冲刺,渗流数值模拟、火星大气模拟及神秘应用大比拼

ASC24超算竞赛挑战大模型推理,大学生直面大模型落地考验

新起点 ASC24世界大学生超级计算机竞赛开启下一个十年之旅

ASC24超算大赛4月将在上海总决赛,大模型推理和渗流模拟成为赛题

第十届ASC世界大学生超算竞赛落幕,北京大学、中国科大分获冠亚军

第十届ASC超算总决赛正赛首日,冲击179亿参数大模型训练!

第十届ASC超算大赛在合肥顺利落幕

10周年精彩看点不断 ASC22世界超算大赛启动