Orin开发套件08-用DS容器执行Python范例

前面一篇文章已经带着大家将DeepStream容器配置Python使用环境,本文的重点就是继续执行实际的开发操作。

由于前面开启容器时,透过“-v”指令将容器外路径与容器内形成映射,因此实际代码文件是存放在主机上(容器外),我们可以在主机上使用gedit这个较为便利的编辑器去修改代码,然后在容器内执行应用,如此搭建起实用性更高的开发环境。

在DeepStream范例中的test2是识别功能最丰富的经典范例,不仅能识别对“Car”与“Person”配置唯一的编号进行跟踪功能,还能为“Car”物体进一步分析“厂牌”、“颜色”、“车型”等属性,我们还可以将这些信息改成中文显示。

另一个runtime_source_add_delete项目则是实现“动态添加/删减视频源”的功能,通常在面对“不均衡”监控的时候,会需要这项功能的辅助。

例如“医院的门诊与急诊”的流量在正常工作时间是门诊大于急诊,下班之后的流量就刚好反转,如果能根据时间去调整输入源的增减,就会有很高的实用性;都市中很多道路车流量在上下班高峰期是反转的,如果中控室的监控屏幕数量有限的时候,也可以根据不同状态去调整视频流的来源。

这并不意味着我们得去调整设备的数量,而是调整输入源的“接收开关”,例如道路交通的监控有100台摄像头,是保持24小时全年午休地拍摄并传输数据,而中控室如果只有50个显示屏幕,就只要切换接收输入源的开关就可以。

现在就用容器版DeepStream的Python环境,来执行这两个应用。

- DeepStream-test2项目

这个项目将DeepStream关于物体识别的绝大部分人工智能功能都集于一身,包括以下三大类组件

- 1个具备四类别的物体检测器(object detector)作为一阶段检测器;

- 1个跟踪器(tracker);

- 3个基于“Car”类别的图像分类器(image classifier)作为二阶段分类器。

三者的合作关系如下:

- 将读入的图像传给一阶段检测器进行物体检测计算;

- 将识别出的物体传送给跟踪器去赋予唯一的编号;

- 如果识别的类别为“Car”,则将物体位置坐标分别传送给3个二阶段分类器,对坐标内图形进行“厂牌”、“颜色”、“车型”等属性识别;

- 最后将上面的信息合成回原始图像,然后进行输出作业。

这里使用的检测器与3个二阶段分类器模型都在samples/models下,如以下的路径名:

- Primary_Detector:一阶段监测器

- Secondary_CarColor:识别车辆颜色的二阶段分类器

- Secondary_CarMake:识别车辆厂牌的二阶段分类器

- Secondary_VehicleTypes:识别车辆种类的二阶段分类器

如果前面建立的Python容器环境没有删除的话,现在就可以执行以下指令进入容器内去执行这个范例:

|

$ $ |

sudo xhost +si:localuser:root docker start ds_python && docker exec -it ds_python bash |

进入容器后,执行以下指令:

|

$ $ |

cd sources/deepstream_python_apps/apps/deepstream-test2 ./deepstream_test_2.py ../../../../samples/streams/sample_720p.h264 |

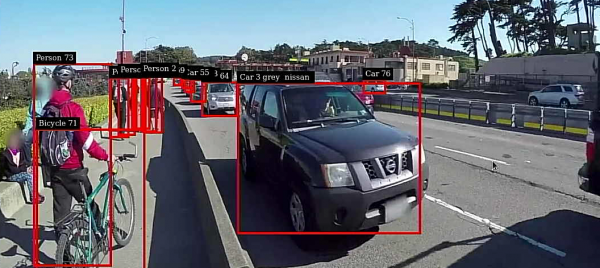

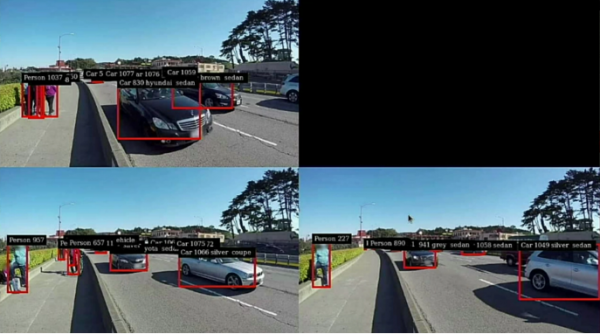

下图就是执行的效果,可以看到每个识别到的物体都有唯一的识别号,在“Car 3”后面还有“gray”与“nissan”等颜色与厂牌的信息。

不过这个容器版有个还未解决的问题,就是“中文显示”的部分,如果有更精通操作系统的朋友可以试着解决这个中文显示问题。

- runtime_source_add_delete项目

这个项目也是基于deepstream-test2多神经网络组合识别项目基础上,使用以下的动态处理函数,因此没有固定的通道结构:

- create_uridecode_bin:作为“多输入源路径解析”功能;

- stop_release_source:停止指定编号数据源,并释放相关资源的内存空间;

- delete_sources:首先删除现有stream中已经End of Stream的数据源,如果没有随机删除一个视频源。如果全部视频源都被删除时,就结束应用;

- add_sources:随机增加数据源,如果数量达到MAX_NUM_SOURCES,10s后删除一个视频源;

- bus_call:总线管理机制,作为触发事件的管理机制。

为了简化运行,这个示例只接收1个H.264视频文件当作4个输入源使用,每10秒添加的视频都会从头开始播放,系统就是为每个输入源设置唯一的编号,作为新增与删除的依据。

|

$ $ $ |

cd sources/deepstream_python_apps/apps/runtime_source_add_delete export DS_ROOT=/opt/nvidia/deepstream/deepstream/ ./deepstream_rt_src_add_del.py file://$DS_ROOT/samples/streams/sample_720p.mp4 |

接下去就会执行以下的7个画面变化:

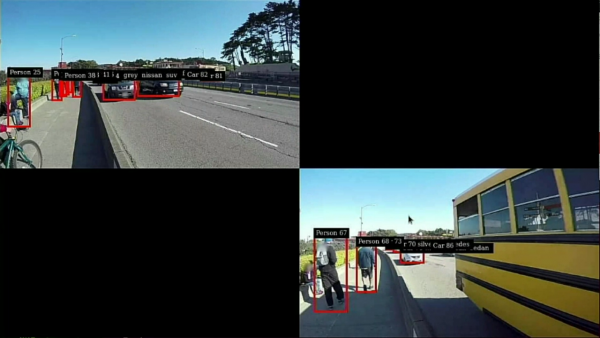

- 显示第一个输入源的检测结果:

- 10秒后添加第二个输入源的检测结果:

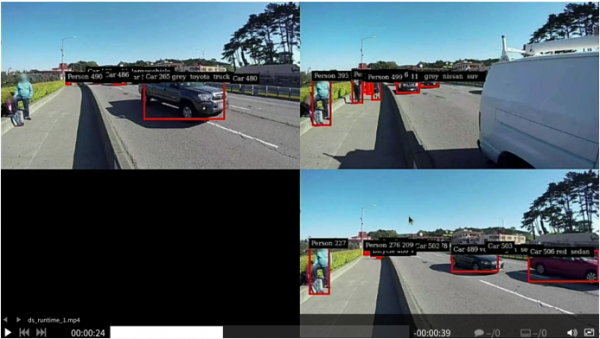

- 再10秒后添加第三个输入源的检测结果:

- 再10秒后添加第四个输入源的检测结果:

- 再10秒后随机删除一个输入源:

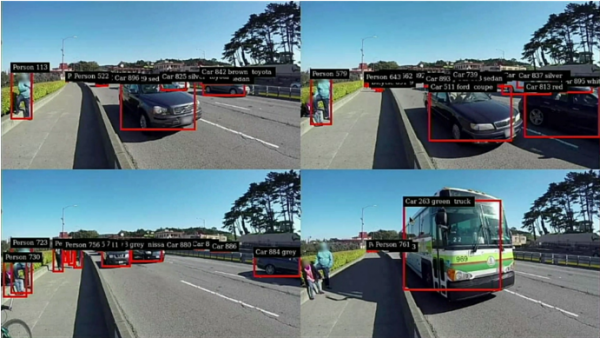

- 再10秒后又随机删除一个输入源:

- 再10秒后又随机删除一个输入源:

- 再10秒后删除最后一个输入源。

可以修改deepstream_rt_src_add_del.py文件的以下两个粗体下划线的参数,调整输出总数量与间隔时间:

- 第48行:MAX_NUM_SOURCES = 4

- 第278行:GLib.timeout_add_seconds(10, delete_sources, g_source_bin_list)

之后请自行尝试修改的结果。

来源:业界供稿

好文章,需要你的鼓励

Aqara Hub M200为HomeKit带来Matter支持和新自动化选项

Aqara Hub M200是进入Aqara生态系统的新入口,作为支持Matter的Zigbee 3.0中枢,可将传感器、开关、按钮等配件通过Matter共享到HomeKit。相比Hub M3设计更紧凑,支持2.4和5GHz双频Wi-Fi。M200充分利用Zigbee协议的低成本优势,让用户以更实惠的价格构建智能家居,同时享受完整的HomeKit功能。对于HomeKit用户来说,这是一个稳定可靠的桥接方案。

腾讯AI实验室新突破:让AI像专家一样精准理解和编辑复杂图片

腾讯AI实验室联合港校提出RePlan框架,解决复杂图像编辑中的指令理解和精确定位难题。该方法采用"计划-执行"架构,让视觉语言模型先推理制定区域级编辑计划,再通过创新的注意力机制精确执行。仅用1000个样本训练就超越了大规模数据训练的模型,在新建的IV-Edit基准上表现出色。

LG智能电视强制安装Copilot快捷方式引发用户不满

LG电视通过系统更新强制安装微软Copilot快捷方式引发争议。虽然LG承诺将允许用户删除该图标,但仍计划在webOS系统中深度整合Copilot功能。三星等厂商也在推进类似AI功能。专家指出,智能电视内置聊天机器人会增加隐私追踪的复杂性,加剧系统臃肿问题。当前智能电视行业正通过用户追踪和广告实现软件盈利,消费者应关注隐私保护问题。

AI机器人终于学会了“立体视觉“:香港科技大学团队让计算机像人类一样理解3D世界

这项由香港科技大学等机构联合完成的研究首次让AI获得了原生的3D空间理解能力。N3D-VLM系统能够像人类一样准确感知物体的立体位置关系,先精确定位物体的3D边界框,再进行空间推理。研究团队还开发了巧妙的数据生成方法,将2D标注转换为278万个3D样本,并构建了全新的N3D-Bench测试基准。实验显示该系统在空间推理任务上准确率超过90%,远超现有方法,为机器人、自动驾驶等领域提供了重要技术突破。

千问C端事业群成立后首推平价AI眼镜:低至1999元,搭载千问AI助手

Aqara Hub M200为HomeKit带来Matter支持和新自动化选项

LG智能电视强制安装Copilot快捷方式引发用户不满

Palo Alto Networks与谷歌云签署数十亿美元AI合作协议

OpenAI 获百亿美元融资与AI投资热潮持续升温

Meta计划2026年发布新一代图像视频AI模型

数字孪生联盟推出四个全新测试平台

BT:英国量子技术发展下一阶段取决于网络建设

Kodiak AI利用自动驾驶技术和物联网连接变革货运行业

Oracle和OpenAI数据中心项目获密歇根州监管机构批准

Optera室温光谱烧孔光学存储技术突破

英特尔助火山引擎“优化”AI云技术内核

分析:NVIDIA第二季度财报再次超出预期背后的新问题

Jetson百万开发者故事 | 校企合作推动实现多项工业场景下AI边缘计算应用

Jetson百万开发者故事 | NVIDIA Jetson助力水产养殖企业打造自动化流水线

Jetson百万开发者故事 | 基于Jetson Nano的便携式岩石分类检测系统:地质学家的新利器

Jetson百万开发者故事 | 让AI成为铁路客运站自动扶梯安全管控的关键

Jetson百万开发者故事 | Jetson开发者突破百万,从TK1到Orin我都经历了啥

百万Jetson开发者故事

Jetson百万开发者故事 | NVIDIA Jetson如何成为可移动智能脑机交互平台

全新NVIDIA Jetson Orin NX 16GB大幅提升边缘AI性能

Triton推理服务器13-模型与调度器(3)