TAO系列12-将模型部署到Jetson设备

前面我们花了很多力气在TAO上面训练模型,其最终目的就是要部署到推理设备上发挥功能。除了将模型训练过程进行非常大幅度的简化,以及整合迁移学习等功能之外,TAO还有一个非常重要的任务,就是让我们更轻松获得TensorRT加速引擎。

将一般框架训练的模型转换成TensorRT引擎的过程并不轻松,但是TensorRT所带来的性能红利又是如此吸引人,如果能避开麻烦又能享受成果,这是多么好的福利!

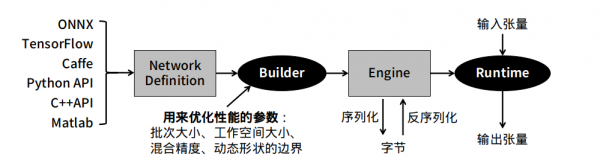

- 一般深度学习模型转成TensorRT引擎的流程

下图是将一般模型转成TesnorRT的标准步骤,在中间”Builder”右边的环节是相对单纯的,比较复杂的是”Builder”左边的操作过程。

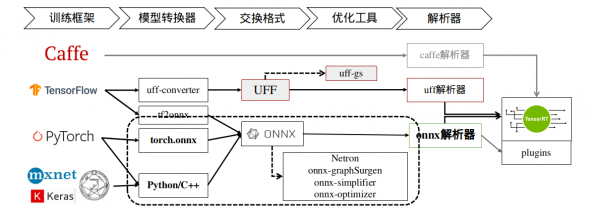

下图就上图 ”Network Definition” 比较深入的内容,TensorRT提供Caffe、uff与ONNX三种解析器,其中Caffe框架已淡出市场、uff仅支持TensorFlow框架,其他的模型就需要透过ONNX交换格式进行转换。

这里以TensorRT所提供的YOLOv3范例来做范例,在安装Jetpack 4.6版本的Jetson Nano设备上进行体验,请进入到TesnorRT的YOLOv3范例中:

|

$ |

cd /usr/src/tensorrt/samples/python/yolov3_onnx |

根据项目的README.md指示,我们需要先为工作环境添加依赖库,不过由于部分库的版本关系,请先将requirements.txt的第1、3行进行以下的修改:

|

1 2 3 4 5 6 |

numpy==1.19.4 protobuf>=3.11.3 onnx==1.10.1 Pillow; python_version<"3.6" Pillow==8.1.2; python_version>="3.6" pycuda<2021.1 |

然后执行以下指令进行安装:

|

$ |

python3 -m pip install -r requirements.txt |

接下来需要先下载download.yml里面的三个文件,

|

$ $

$ |

wget https://pjreddie.com/media/files/yolov3.weights wget https://github.com/pjreddie/darknet/raw/f86901f6177dfc6116360a13cc06ab680e0c86b0/data/dog.jpg |

然后就能执行以下指令,将yolov3.weights转成yolov3.onnx:

|

$ |

./yolov3_to_onnx.py -d /usr/src/tensorrt |

这个执行并不复杂,是因为TensorRT已经提供yolov3_to_onnx.py的Python代码,但如果将代码打开之后,就能感受到这750+行代码要处理的内容是相当复杂,必须对YOLOv3的结构与算法有足够了解,包括解析yolov3.cfg的788行配置。想象一下,如果这个代码需要自行开发的话,这个难度有多高!

接下去再用下面指令,将yolov3.onnx转成yolov3.trt加速引擎:

|

$ |

./onnx_to_tensorrt.py -d /usr/src/tensorrt |

以上是从一般神经网络模型转成TensorRT加速引擎的标准步骤,这需要对所使用的神经网络的结构层、数学公式、参数细节等等都有相当足够的了解,才有能力将模型先转换成ONNX文件,这是技术门槛比较高的环节。

- TAO工具训练的模型转成TensorRT引擎的工具

用TAO工具所训练、修剪并汇出的.etlt文件,可以跳过上述过程,直接在推理设备上转换成TensorRT加速引擎,我们完全不需要了解神经网络的任何结构与算法内容,直接将.etlt文件复制到推理设备上,然后用TAO所提供的转换工具进行转换就可以。

这里总共需要执行三个步骤:

- 下载tao-converter工具,并调试环境:

请根据以下Jetpack版本,下载对应的tao-converter工具:

|

|

Jetpack 4.4:https://developer.nvidia.com/cuda102-trt71-jp44-0 Jetpack 4.5:https://developer.nvidia.com/cuda110-cudnn80-trt72-0 Jetpack 4.6:https://developer.nvidia.com/jp46-20210820t231431z-001zip |

下载压缩文件后执行解压缩,就会生成tao-converter与README.txt两个文件,再根据README.txt的指示执行以下步骤:

- 安装libssl-dev库:

|

$ |

sudo apt install libssl-dev |

- 配置环境,请在 ~/.bashrc 最后面添加两行设置:

|

|

export TRT_LIB_PATH=/usr/lib/aarch64-linux-gnu export TRT_INCLUDE_PATH=/usr/include/aarch64-linux-gnu |

- 将tao-convert变成可执行文件:

|

$ $ $ |

source ~/.bashrc chmod +x tao-converter sudo cp tao-converter /usr/local/bin |

- 安装TensorRT的OSS(Open Source Software)

这是TensorRT的开源插件,项目在https://github.com/NVIDIA/TensorRT,下面提供的安装说明非常复杂,我们将繁琐的步骤整理之后,就是下面的步骤:

|

$ $ $ $ $ $ $

$ $

$ |

export ARCH=请根据设备进行设置,例如Nano为53、NX为72、Xavier为62 export TRTVER=请根据系统的TensorRT版本,例如Jetpack 4.6为8.0.1 git clone -b $TRTVER https://github.com/nvidia/TensorRT TRToss cd TRToss/ git checkout -b $TRTVER && git submodule update --init --recursive mkdir -p build && cd build cmake .. \ -DGPU_ARCHS=$ARCH \ -DTRT_LIB_DIR=/usr/lib/aarch64-linux-gnu/ \ -DCMAKE_C_COMPILER=/usr/bin/gcc \ -DTRT_BIN_DIR=`pwd`/out \ -DTRT_PLATFORM_ID=aarch64 \ -DCUDA_VERSION=10.2 make nvinfer_plugin -j$(nproc) sudo mv /usr/lib/aarch64-linux-gnu/libnvinfer_plugin.so.8.0.1 /usr/lib/aarch64-linux-gnu/libnvinfer_plugin.so.8.0.1.bak sudo cp libnvinfer_plugin.so.8.0.1 /usr/lib/aarch64-linux-gnu/libnvinfer_plugin.so.8.0.1 |

这样就能开始用tao-converter来将 .etlt文件转换成TensorRT加速引擎了。

- 用tao-converter进行转换

- 首先将TAO最终导出(export)的文件复制到Jetson Nano上,例如前面的实验中最终导出的文件ssd_resnet18_epoch_080.etlt,

- 在Jetson Nano上执行TAO的ssd.ipynb最后所提供的转换指令,如下:

|

$ $ |

%set_env KEY= tao converter -k $KEY \ -d 3,300,300 \ -o NMS \ -e ssd_resnet18_epoch_080.trt \ # 自己设定输出名称 -m 16 \ -t fp16 \ # 使用export时相同精度 -i nchw \ ssd_resnet18_epoch_080.etlt |

这样就能生成在Jetson Nano上的ssd_resnet18_epoch_080.trt加速引擎文件,整个过程比传统方式要简便许多。【完】

来源:业界供稿

好文章,需要你的鼓励

Red Hat为英伟达Vera Rubin AI平台定制RHEL操作系统

基于与英伟达的持续合作,红帽承诺为英伟达新发布的Vera Rubin平台提供"零日"支持。该企业开源软件公司旨在缩小英伟达硬件平台发布与其支持软件堆栈正式发布之间的时间差。Vera Rubin平台专为降低AI推理成本而设计,基于新的CPU、GPU和数字处理单元构建。红帽将发布定制版RHEL操作系统,支持英伟达GPU驱动和CUDA工具包,预计2026年下半年推出。

德国机构首创免训练人脸质量评估技术:Vision Transformer也能当“质检员“

德国弗劳恩霍夫研究院提出ViTNT-FIQA人脸质量评估新方法,无需训练即可评估图像质量。该方法基于Vision Transformer层间特征稳定性原理,通过测量图像块在相邻层级间的变化幅度判断质量。在八个国际数据集上的实验显示其性能可媲美现有最先进方法,且计算效率更高,为人脸识别系统提供了即插即用的质量控制解决方案,有望广泛应用于安防监控和身份认证等领域。

谷歌发布用于智能体购物的新协议标准

谷歌在全国零售联合会会议上宣布推出通用商务协议,这是一个专为AI代理购物设计的开放标准。该协议与Shopify、Target、沃尔玛等公司合作开发,能让AI代理在产品发现到售后支持的整个购买流程中无缝协作。谷歌将在搜索AI模式中应用该协议,用户可直接从美国零售商处结账并使用Google Pay支付。此外,谷歌还推出面向零售商的企业级客户体验套件。

临床AI大模型的人格面具:布朗大学揭示医疗角色扮演的双刃剑效应

布朗大学联合图宾根大学的研究团队通过系统实验发现,AI医疗助手的角色设定会产生显著的情境依赖效应:医疗专业角色在急诊场景下表现卓越,准确率提升20%,但在普通医疗咨询中反而表现更差。研究揭示了AI角色扮演的"双刃剑"特性,强调需要根据具体应用场景精心设计AI身份,而非简单假设"更专业等于更安全",为AI医疗系统的安全部署提供了重要指导。