TAO系列04-启动器CLI指令集与配置文件

在开始使用TAO模型训练工具之前,我们必须先对其操作原理有个基础的理解,因为这套工具能支持30多种神经网络的深度学习,并且横跨视觉类与对话类两种不同领域,究竟是如何做到的?

前面介绍的内容中提过,在TAO工具使用两个不同的Docker容器,去面对视觉类与对话类的模型训练,分别是基于Tensorflow与PyTorch框架。

不过英伟达将复杂的调用工作进行高度的抽象化处理,以启动器CLI指令作为统一的执行接口,并且为每个神经网络提供对应的配置文件组,透过指令集与配置文件的组合,将操作的逻辑变得非常简单,开发人员只要熟悉这套指令集,就能非常轻松地驾驭所有TAO支持的神经网络,进行高效率的模型训练任务。

因此在操作TAO工具之前,首先得对CLI指令集与配置文件有个初步的了解。

- 启动器CLI指令集:

这个指令集的语法非常简单,主要是下面三部分所组成:

tao <task> <sub-task> <args>

- task:包括TAO所支持的神经网络算法以及基础的控制指令,主要分为以下三类:

- 视觉类神经网络:augment、bpnet、classification、dssd、emotionnet、efficientdet、fpenet、gazenet、gesturenet、heartratenet、lprnet、mask_rcnn、multitask_classification、retinanet、ssd、unet、yolo_v3、yolo_v4、yolo_v4_tiny、converter、detectnet_v2、faster_rcnn等

- 对话类神经网络:speech_to_text、speech_to_text_citrinet、text_classification、question_answering、token_classification、intent_slot_classification、punctuation_and_capitalization、spectro_gen、vocoder、action_recognition、n_gram等

- 控制指令类:包括list、stop、info三个功能指令,分别执行列出、终止处理启动器的进程,以及显示TAO的基础信息。

上面所有的信息,可以用tao info --verbose指令,查询到不容版本容器所支持的神经网络类型。

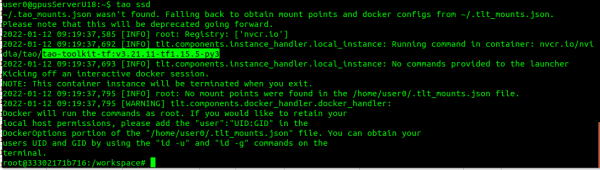

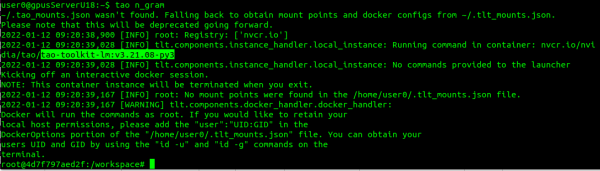

当我们单纯执行tao <task>的时候,就会进入对应的容器里,例如:

- tao ssd 会进入视觉类的容器,这里是tao-toolkit-tf:v3.21.11-tf1.15.5-py3

- tao n_gram 进入对话类容器,这里是tao-toolkit-lm:v3.21.08-py3

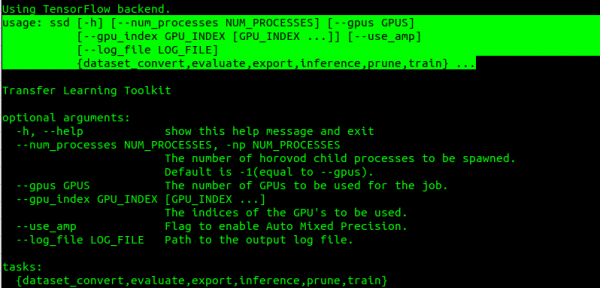

- sub-task与args:主要是指TAO所支持的神经网络算法(task)而不同,最简单的方法就是执行 tao <task> --help 去查询个别task后面所需要的<args>。例如:

- 执行tao ssd --help会显示以下信息:大部分视觉类的参数是类似

- 执行tao n_gram --help会显示以下信息:大部分对话类参数是类似

以下6种指令是所有模型都具备的功能:

- dataset_convert:将数据集转换成指定格式

- evaluate:模型评估

- export:导出模型

- inference:推理识别

- prune:修剪模型

- train:训练模型

到这里应该能够感受到这个CLI指令集的便利之处,开发人员只要好好记住这组指令,不需要撰写任何C++或Python代码,甚至不需要了解任何一个神经网络的结构与算法,就能非常轻松地面对这么多种复杂的模型训练任务。

- 视觉类神经网络配置文件:

这里需要透过TAO提供的范例来说明配置文件的细节,这里以视觉类的范例为主,请执行下列指令下载范例文件:

|

$ $

$ $ |

wget --content-disposition https://api.ngc.nvidia.com/v2/resources/nvidia/tao/cv_samples/versions/v1.3.0/zip -O cv_samples_v1.3.0.zip unzip -u cv_samples_v1.3.0.zip -d ./cv_samples_v1.3.0 rm -rf cv_samples_v1.3.0.zip && cd ./cv_samples_v1.3.0 |

在cv_samples_v1.3.0文件夹里有20+个子目录,每个子文件夹就对应一个神经网络,下面都有个别的specs子目录,里面就存放对应的配置文件。

每个项目应该是由不同的技术人员所处理,在文件格式与命名方式也不尽相同,大部分是.txt纯文件格式,有些则使用.yaml或.json格式,因此需要针对个别项目,去深入了解每个配置文件里的各项参数。

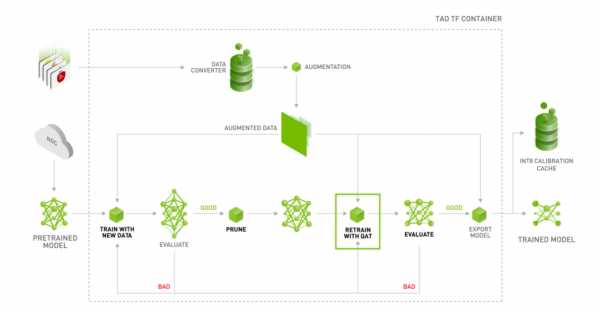

下面是TAO视觉类模型训练工具的工作流图,每个项目里的配置文件,都是为不同阶段的任务提供所需要的参数。

这里以英伟达发展的detectnet_v2神经网络作为范例,里面的配置文件内容比较完整,包括以下7个文件:

- detectnet_v2_tfrecords_kitti_trainval.txt

- detectnet_v2_train_resnet18_kitti.txt

- detectnet_v2_retrain_resnet18_kitti.txt

- detectnet_v2_retrain_resnet18_kitti_qat.txt

- detectnet_v2_inference_kitti_etlt_qat.txt

- detectnet_v2_inference_kitti_tlt.txt

- detectnet_v2_inference_kitti_etlt.txt

这些文件是配合整个执行流程的步骤:

- 格式转换:由于这个训练的容器是基于Tensorflow框架,因此执行训练前需要先将数据集转换成tf_record格式,就会用到detectnet_v2_tfrecords_kitti_trainval.txt配置文件。其他项目里xxx_tfrecords_kitti_xxx.txt主要就是作为这个用途。

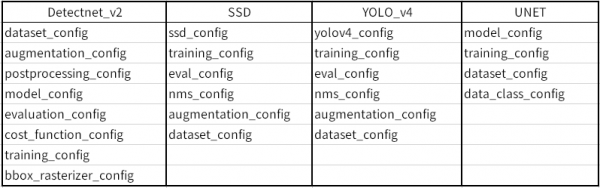

- 训练模型:所有项目里的xxx_train_xxx.txt文件,都是该项目进行第一次训练时所需要配置文件,不过每个项目的配置中都不尽相同,以下列出4个项目提供参考:

这里的参数设定,是整个TAO训练模型过程中技术含量最高的环节,我们所能修改的部分大概就是“training_config”组里的”batch_size_per_gpu”与“num_epochs”这两个参数,以及确认“dataset_config”组里的每一个“target_class_mapping”对应是否正确。

其他参数的调整是需要对个别神经网络的结构预与算法有足够了解,如果没有把握的话,建议就使用英伟达已经优化过的参数。

- 评估模型:也使用前面一个配置文件。如果不满意评估结果(例如mAP低于0.5),可以试着加大num_epochs,或者从头检查数据集的图像与标注;如果满意结果的话,就可以继续往下执行。

- 修剪模型:TAO使用比较简单的调整阈值(threshold),而不改变其他参数

- 模型再训练:这个步骤用到的xxx_retrain_xxx.txt配置文件,与第一次训练使用的配置文件中的最大不同点,在于“pretrained_model_file”的部分,第一次训练使用NGC下载的预训练模型,而再训练的部分是使用步骤4修剪步骤所生成的模型,其他设定值是一样的。

- 评估再训练的模型:与步骤3相同。如果对评估结果并不满意,请回到步骤4重复进行;如果感到满意,就能接续往下执行推理识别,验证模型的效果。

后面的推理验证与导出模型的步骤,留在实际项目执行的时候再做说明。到此应该能清楚,在TAO模型训练阶段,需要的就是xxx_tfrecords_xxx.txt、xxx_train_xxx.txt与xxx_retrain_xxx.txt这三个配置文件,后面两个文件的内容几乎一样,只有调用的预训练模型不一样,这样就能让事情变得更加单纯。

整个TAO训练工具的内容,主要就是围绕着CLI指令集与配置文件的组合处理,如此一来,开发人员只要掌握这两个部分,就能轻松驾驭大部分的模型训练任务【完】

来源:业界供稿

好文章,需要你的鼓励

CIO对2026年AI发展的五大预测

2025年,企业技术高管面临巨大压力,需要帮助企业从持续的AI投入中获得回报。大多数高管取得了进展,完善了项目优先级排序方法。然而,CIO仍面临AI相关问题。支离破裂的AI监管环境和宏观经济阻力将继续推动技术高管保持谨慎态度。随着AI采用增长的影响不断显现,一些CIO预期明年将带来劳动力策略变化。

Anthropic最新CJE技术:让AI评判AI不再瞎猜,终结LLM评估乱象

这篇论文提出了CJE(因果法官评估)框架,解决了当前LLM评估中的三大致命问题:AI法官偏好倒置、置信区间失效和离线策略评估失败。通过AutoCal-R校准、SIMCal-W权重稳定和OUA不确定性推理,CJE仅用5%的专家标签就达到了99%的排名准确率,成本降低14倍,为AI评估提供了科学可靠的解决方案。

云成本管理变得更加便捷

FinOps基金会周四更新了其FinOps开放成本和使用规范云成本管理工具,新版本1.3更好地支持多供应商工作流。该版本新增了合同承诺和协商协议数据集,增加了跨工作负载成本分摊跟踪列,以及云支出和使用报告时效性和完整性的元数据可见性。随着云和AI采用推动企业IT预算增长,技术供应商正在关注将成本与价值联系起来的努力。大型企业通常使用三到四家云供应商,小企业可能使用两家,同时还有数据中心、SaaS和许可等服务。

NVIDIA团队让立体视觉AI实现“真正“实时运行:速度提升10倍却不牺牲精度

NVIDIA团队开发出Fast-FoundationStereo系统,成功解决了立体视觉AI在速度与精度之间的两难选择。通过分而治之的策略,该系统实现了超过10倍的速度提升同时保持高精度,包括知识蒸馏压缩特征提取、神经架构搜索优化成本过滤,以及结构化剪枝精简视差细化。此外,研究团队还构建了包含140万对真实图像的自动伪标注数据集,为立体视觉的实时应用开辟了新道路。

分析:NVIDIA第二季度财报再次超出预期背后的新问题

Jetson百万开发者故事 | 校企合作推动实现多项工业场景下AI边缘计算应用

Jetson百万开发者故事 | NVIDIA Jetson助力水产养殖企业打造自动化流水线

Jetson百万开发者故事 | 基于Jetson Nano的便携式岩石分类检测系统:地质学家的新利器

Jetson百万开发者故事 | 让AI成为铁路客运站自动扶梯安全管控的关键

Jetson百万开发者故事 | Jetson开发者突破百万,从TK1到Orin我都经历了啥

百万Jetson开发者故事

Jetson百万开发者故事 | NVIDIA Jetson如何成为可移动智能脑机交互平台

全新NVIDIA Jetson Orin NX 16GB大幅提升边缘AI性能

Triton推理服务器13-模型与调度器(3)