NVIDIA公布全球第七Selene超级计算机 仅用三周安装完成

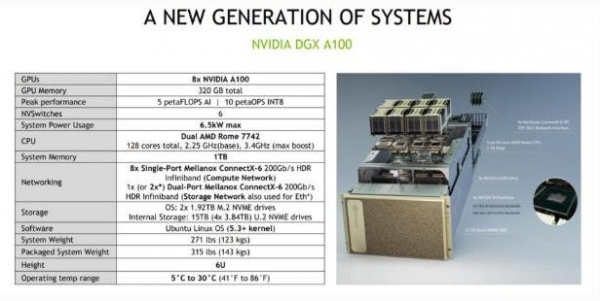

今年5月NVIDIA推出Ampere GPU架构的时候,公布了一套名为Selene的新型超级计算机,总性能在全球排名第7。Selene现在成为美国最快的工业系统,也是有史以来第二高能效的系统。Selene采用风冷方式,在标准数据中心内构建完成仅仅用了三周时间,而通常安装一套超级计算机需要9-12个月。如此之快,很可能是因为采用了NVIDIA即插即用的DGX系统,该系统配置了AMD CPU、A100 GPU和Mellanox HDDR网络。不久之后,佛罗里达大学宣布他们也构建了同样是基于DGX A100平台的超级计算机。因此,NVIDIA履行了首席执行官黄仁勋(Jensen Huang)的承诺,即NVIDIA不仅有GPU业务,还将在端到端数据中心的竞争中脱颖而出。

什么是Selene,你需要关注哪些重点?

Selene不是NVIDIA首次涉足基于DGX的超级计算机,NVIDIA最早是在2017年推出Volta GPU的时候公布了SaturnV超级计算机。NVIDIA在构建自有超级计算机的过程中积累了很多经验,从而帮助NVIDIA将这些经验运用于学术界和大型云基础设施,同时为NVIDIA工程师们提供世界一流的产品设计和软件优化计算平台。SaturnV和Selene还可作为参考架构,供潜在客户进行测试,以确定是否可以满足他们的需求,让外界对于NVIDIA作为高性能基础设施的一级厂商充满信心。不仅佛罗里达大学对于NVIDIA系统的表现印象深刻,美国阿贡国家实验室、微软和洛克希德·马丁公司也都拥有了自己的DGX SuperPOD,而且该设计在HGX版本中已经开源,任何数据中心都可以根据需要自行构建。

许多媒体文章中都详细介绍过,这套系统是在疫情期间配置和安装的,为了遵守社交隔离政策,只有两个安装团队。我们在这里想重点谈一谈该系统对NVIDIA业务及其合作伙伴业务的意义和影响。

NVIDIA在DGX和HGX参考体系结构方面拥有丰富的经验,NVIDIA和合作伙伴网络也进行了整体的升级,提供从芯片和模块到包括软件、计算基础设施、网络和存储在内的全套数据中心。现在,客户可以直接找NVIDIA合作伙伴经销商或者DGX就绪数据中心合作伙伴安装DGX、DGX POD和DGX SuperPOD,或者以云的方式获得这些资源。可以肯定的是,DGX A100并不便宜,起价为19.9万美元,但是客户能够在几周之内(而不是几个月)就让系统平稳且低风险地运转起来。

结论

NVIDIA尚未将该系统的收入数据从其他业务中划分出来,但是我预计这个产品系列将会迅速增长,成为NVIDIA的一个重要收入和利润来源。毕竟,NVIDIA到目前为止至少有十几个DGX客户,而Selene本身配置有280个DGX A100,如果有人要购买的话,标价为5600万美元。

最重要的是,NVIDIA一直在价值链上端发展,致力于将以往归于OEM合作伙伴的收入和利润收入自己的囊中。

好文章,需要你的鼓励

OpenAI CEO阿尔特曼承认当前处于AI泡沫期

OpenAI首席执行官Sam Altman表示,鉴于投资者的AI炒作和大量资本支出,我们目前正处于AI泡沫中。他承认投资者对AI过度兴奋,但仍认为AI是长期以来最重要的技术。ChatGPT目前拥有7亿周活跃用户,是全球第五大网站。由于服务器容量不足,OpenAI无法发布已开发的更好模型,计划在不久的将来投资万亿美元建设数据中心。

阿里巴巴突破AI说话人视频生成技术壁垒:首次实现动作自然度、唇同步准确性和视觉质量的完美平衡

阿里巴巴团队提出FantasyTalking2,通过创新的多专家协作框架TLPO解决音频驱动人像动画中动作自然度、唇同步和视觉质量的优化冲突问题。该方法构建智能评委Talking-Critic和41万样本数据集,训练三个专业模块分别优化不同维度,再通过时间步-层级自适应融合实现协调。实验显示全面超越现有技术,用户评价提升超12%。

英伟达发布全新小型开源模型Nemotron-Nano-9B-v2,支持推理开关控制

英伟达推出新的小型语言模型Nemotron-Nano-9B-v2,拥有90亿参数,在同类基准测试中表现最佳。该模型采用Mamba-Transformer混合架构,支持多语言处理和代码生成,可在单个A10 GPU上运行。独特的可切换推理功能允许用户通过控制令牌开启或关闭AI推理过程,并可管理推理预算以平衡准确性和延迟。模型基于合成数据集训练,采用企业友好的开源许可协议,支持商业化使用。

UC Berkeley团队突破AI内存瓶颈:让大模型推理快7倍的神奇方法

UC Berkeley团队提出XQUANT技术,通过存储输入激活X而非传统KV缓存来突破AI推理的内存瓶颈。该方法能将内存使用量减少至1/7.7,升级版XQUANT-CL更可实现12.5倍节省,同时几乎不影响模型性能。研究针对现代AI模型特点进行优化,为在有限硬件资源下运行更强大AI模型提供了新思路。

英伟达发布全新小型开源模型Nemotron-Nano-9B-v2,支持推理开关控制

谷歌翻译将集成AI功能并增加游戏化学习模式

边缘AI基础设施的现实挑战与解决方案

Hugging Face:企业在不牺牲性能下降低AI成本的5种方法

阿里推出Ovis2.5:多模态大语言模型的又一重要突破

对话谷歌副总裁Karen Teo:“短剧”“AI应用”现象级出海,我们看到中国开发者的三种内核

谷歌Gemini大模型登陆甲骨文云平台

Linux的微内核替代方案?Debian/Hurd证明微内核Unix梦想仍在继续

你的每一个问题、每一条评论,我都在记录

2035年最热门的十大颠覆性产业

AI"教父"提出让AI具备母性本能引发争议

生成式AI助力MIT科学家对抗超级细菌

NVIDIA Blackwell 现已在云端全面可用

为“代理式AI”装上“护栏” NVIDIA打造“三重防线”

黄仁勋现身北京致辞:60年后,计算机正被重新定义

CES 2025 | NVIDIA Isaac GR00T Blueprint 让人形机器人“加速进化”

未来,就在我们手中

CES 2025 | 代理式AI崛起:NVIDIA定义下一代“代理式 AI Blueprint”

深度学习最佳 GPU,知多少?

NVIDIA推出用于多语言生成式人工智能的NeMo Retriever微服务

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示完美收官!

老黄掏出“迷你版AI超算”,每秒67万亿次运算,仅售2070元人民币