NVIDIA与众多技术领导企业一同构建GPU加速的ARM服务器,开创多样化高性能计算架构新纪元

与Arm、Ampere、Cray、富士通、HPE、Marvell携手构建GPU加速服务器,以满足从超大规模云到边缘、从模拟到AI、从高性能存储到百万兆级超级计算等多样化需求

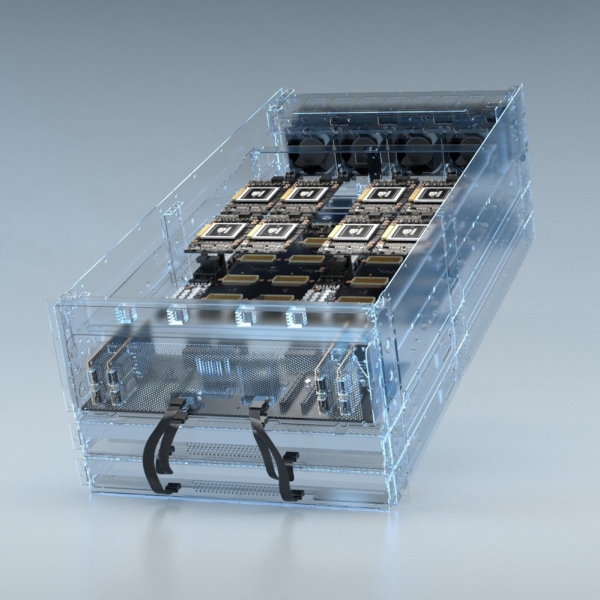

NVIDIA于今日发布一款参考设计平台,使企业能够快速构建GPU加速的Arm服务器,以满足日益多样化的科学和工业应用需求。这开辟了高性能计算的新纪元。

NVIDIA创始人兼首席执行官黄仁勋在2019国际超级计算大会(SC19)上宣布推出这款参考设计平台。该平台由硬件和软件基础模块组成,能够满足高性能计算(HPC)社区对于类型更加多样化的CPU架构日益增长的需求。通过该平台,超级计算中心、超大型云运营商和企业能够将NVIDIA加速计算平台的优势与最新的Arm服务器平台相结合。

为了构建这一参考平台,NVIDIA与Arm及其生态合作伙伴(包括Ampere、富士通和Marvell)联手,以确保NVIDIA GPU与Arm处理器之间的无缝协作。该参考平台还得益于与HPE旗下公司Cray和HPE这两家早期采用Arm服务器的供应商之间的紧密合作。此外,许多高性能计算软件公司已使用NVIDIA CUDA-X库来构建可在Arm服务器上运行、并可通过GPU实现的管理和监控工具。

黄仁勋表示:“高性能计算正在崛起。机器学习和AI领域的突破正在重新定义科学研究方法,并且可能带来激动人心的新架构。从超大规模云到百万兆级超级计算,NVIDIA GPU与ARM的组合让创新者们能够为不断增加的新应用创建系统。”

Arm IP产品部门总裁Rene Haas表示:“ Arm正在与生态合作伙伴一同努力,为百万兆级的Arm系统级芯片提供前所未有的性能和效率。我们与NVIDIA合作,将CUDA加速带入到Arm架构当中,这对于高性能计算社区来说,具有里程碑式的意义。为了应对全球最复杂的研究,挑战并推动嵌入式系统、汽车和边缘细分市场的进一步发展,高性能计算社区已经在部署Arm技术。”

今年早些时候,NVIDIA宣布为Arm带来CUDA-X软件平台。NVIDIA此次发布这一参考平台正是对此前承诺的兑现。根据这一承诺,NVIDIA正在提供其Arm兼容软件开发套件的预览版本。该版本包含NVIDIA CUDA-X库和加速计算开发工具。

联合整个高性能计算生态中的合作伙伴

除了使自己的软件兼容Arm之外,NVIDIA还与 GROMACS、LAMMPS、MILC、NAMD、Quantum Espresso和Relion等领先的高性能计算应用开发商密切合作,为ARM提供GPU加速的应程序用。为了让Arm平台上的应用实现GPU加速,NVIDIA及其高性能计算应用生态合作伙伴编译了大量代码。

为了构建Arm生态,NVIDIA与领先的Linux发行商Canonical、Red Hat、SUSE,以及业内领先的高性能计算基础工具供应商展开合作。

几家世界级的超级计算中心已开始测试GPU加速Arm计算系统,其中包括美国的橡树岭国家实验室和桑迪亚国家实验室、英国布里斯托大学以及日本理化学研究所。

好文章,需要你的鼓励

Anthropic发布入门级Claude Haiku 4.5混合推理模型

Anthropic发布了面向成本敏感用户的Claude Haiku 4.5大语言模型,定价为每百万输入令牌1美元,输出令牌5美元,比旗舰版Sonnet 4.5便宜三倍。该模型采用混合推理架构,可根据需求调整计算资源,支持多模态输入最多20万令牌。在八项基准测试中,性能仅比Sonnet 4.5低不到10%,但在编程和数学任务上超越了前代Sonnet 4。模型响应速度比Sonnet 4快两倍以上,适用于客服聊天机器人等低延迟应用场景。

上海AI实验室推出科学推理大模型:让AI像科学家一样思考

上海AI实验室联合多家顶尖机构开发出全球首个科学推理大模型SciReasoner,该模型在2060亿科学数据上训练,支持103个科学任务,能够像科学家一样进行逻辑推理并展示思考过程。它实现了化学、生物学、材料科学等多领域知识整合,在分子设计、性质预测、文献分析等方面表现出色,为科学研究提供了强大的AI助手工具。

微软与Nscale签署价值240亿美元数据中心合同

英国初创公司Nscale将为微软建设四个AI数据中心,总计部署约20万个GPU,合同价值高达240亿美元。首个数据中心将于明年在葡萄牙开建,配备1.26万个GPU。德州数据中心规模最大,将部署10.4万个GPU,容量从240兆瓦扩展至1.2吉瓦。所有设施将采用英伟达最新Blackwell Ultra显卡。

南洋理工大学团队突破:让AI学会在复杂光影中完美合成图像,无需额外训练就能处理水面倒影和阴影效果

南洋理工大学研究团队开发出SHINE方法,这是一种无需额外训练就能实现高质量图像合成的新技术。该方法通过巧妙引导现有AI模型的潜能,能够在复杂光影条件下完美合成图像,包括准确的阴影生成和水面倒影效果。研究团队还创建了ComplexCompo基准测试集,验证了SHINE在各种挑战性场景中的卓越性能,为图像编辑技术的发展开辟了新方向。

深度解密Testin云测AI测试“三驾马车”——(AGI+RAG+多模态)技术栈

思科人工智能研究:人工智能就绪型企业在价值竞赛中遥遥领先

从“支撑工具”到“智能中枢”,端点科技的“AI原生ERP”进化

全球计算机系统领域“奥运会”SOSP公布最佳论文 “星绽”OS入选

Anthropic发布入门级Claude Haiku 4.5混合推理模型

微软与Nscale签署价值240亿美元数据中心合同

谷歌将在印度建造150亿美元AI数据中心枢纽

Eightfold联合创始人获3500万美元融资,打造员工数字孪生AI查询平台

新加坡交通部门采用光纤局域网升级关键铁路基础设施

Oracle推动智能体AI在ERP和供应链领域应用

微软英伟达等巨头400亿美元收购数据中心推高AI泡沫

Google Veo 3.1视频生成模型升级,图像转视频能力增强

NVIDIA Blackwell 现已在云端全面可用

为“代理式AI”装上“护栏” NVIDIA打造“三重防线”

黄仁勋现身北京致辞:60年后,计算机正被重新定义

CES 2025 | NVIDIA Isaac GR00T Blueprint 让人形机器人“加速进化”

未来,就在我们手中

CES 2025 | 代理式AI崛起:NVIDIA定义下一代“代理式 AI Blueprint”

深度学习最佳 GPU,知多少?

NVIDIA推出用于多语言生成式人工智能的NeMo Retriever微服务

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示完美收官!

老黄掏出“迷你版AI超算”,每秒67万亿次运算,仅售2070元人民币