IBM凭借Granite,被Forrester评为语言AI基础模型的“强劲表现者”

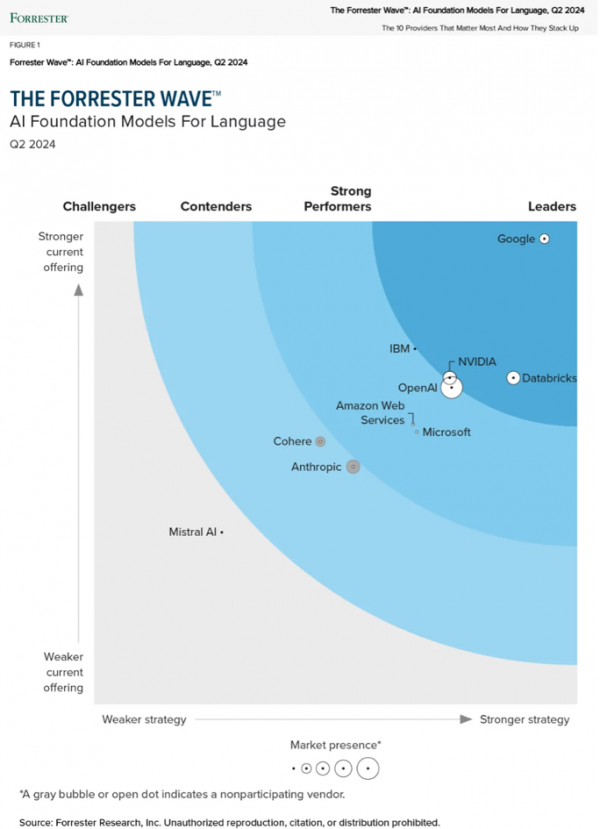

(2024年6月26日,北京)近日,IBM凭借其旗舰Granite系列模型,在2024年第二季度的《Forrester Wave™:语言AI基础模型》报告中,被评为“强劲表现者”。点击链接即可免费下载报告副本。

随着企业从生成式AI的试验阶段转向生产阶段,他们正在寻找基础模型的最佳选择,他们希望这些模型能够提供可信、性能优越且成本效益高的生成式AI。企业认识到,如果基础模型不可信,他们就无法扩展生成式AI。

IBM® Granite™ 是IBM的旗舰基础模型系列,基于仅解码器的Transformer架构。这些模型在涵盖互联网、学术、代码、法律和金融等领域的可信企业数据上进行训练,可以在IBM watsonx™、RedHat®、其他模型市场以及Hugging Face和GitHub等开源平台上获取。

IBM对AI信任和可靠性的承诺和方法,受到Forrester的认可

虽然大多数模型提供商专注于提高性价比,但IBM在设计和交付各种用例和应用的模型时,优先考虑信任和透明性,同时仍能实现合适的性价比。IBM痴迷于帮助客户取得生成式AI使命的成功,其实现这一承诺的方法是:正确地构建人工智能,提供正确的人工智能。

Forrester认为,Granite系列模型为企业用户提供了对基础训练数据的一些最稳健和清晰的洞察。这对于有效地改进特定用例和领域的模型行为,以及保护企业免受训练数据中任何未授权内容带来的风险至关重要。

这一认可验证了IBM在交付企业级基础模型方面的差异化方法,帮助客户加速生成式AI在其业务工作流程中的应用,同时减轻与基础模型相关的风险。

此外,Forrester给出的关于潜在改进领域的建设性反馈也非常及时,因为IBM正以开源创新重振其模型策略,从而在现有产品的强大基础上,可以迅速扩大市场影响力,为众多企业客户、合作伙伴和开发人员提供服务,并取得了显著的进展。

2024年,IBM在促进基础模型的增长和转型之旅中,积极寻求来自Forrester等行业专家、客户和人工智能生态系统的意见,凭借开放的心态和演绎推理不断探索。

IBM凭借其差异化的模型方法,在现有产品中排名第二:

- 开放:将一流的IBM模型和高性能的开源模型引入IBM的watsonx基础模型库。

- 可信:在受信任和受管控的数据上训练模型,从而可以自信地将生成式AI应用于业务应用程序。

- 针对性:模型专为企业而设计,并针对特定的业务领域和用例进行优化。

- 赋能:为客户提供具有价格竞争力的模型选择,以构建最适合其独特业务需求和风险状况的AI。

IBM Granite模型在此次Forrester Wave评估中,在内容语料库过滤、知识产权、模型透明度和一致性方面获得了满分。Granite模型受隐私和负责技术办公室的管控,根据AI伦理和原则进行训练和调优,并采用了IBM Research®创新的AI对齐技术。

由于这些固有特性以及watsonx这一强大可靠的AI和数据平台的支持,以及通过红帽® OpenShift®的混合部署选项,IBM模型在企业就绪性、治理和安全性、应用程序开发和模型管理方面获得最高评分。这也与最近斯坦福透明度指数的结果一致,该指数认可Granite模型在开放性和可信度方面的优异表现。

Forrester对于IBM Granite的洞察:

- Granite模型系列为企业用户提供强大且清晰的底层训练数据洞察,这对于有效优化模型在特定用例和领域中的行为,以及保护企业免受训练数据中未授权内容相关风险至关重要。

- IBM非常适合那些寻求从模型训练数据和AI平台能力中获得100%供应商赔偿保障的客户,这些能力可以帮助其AI团队构建解决方案。

- 企业客户不仅可以获得包含赔偿条款的模型,还可以获得一些专为开发高度可管理的人工智能解决方案而设计的最佳企业工具。

IBM继续通过引入第三方模型来扩展其基础模型库,以增强多模态和多语言能力,并提供自带模型(BYOM)的选项。此方法与其Granite模型系列的研究开发和开放创新相辅相成。

- Meta:2024年4月,IBM宣布在watsonx平台上推出Meta的下一代开放大型语言模型(LLM)Llama 3,以帮助企业推动其AI创新之旅。Llama 3的加入进一步深化了IBM与Meta在AI开放创新方面的合作。两家公司还共同创建了AI联盟,该联盟由行业领先组织、初创企业、学术界、研究机构和政府部门组成。自2023年底成立以来,该联盟的成员和合作伙伴已超过100个。

- Mistral:在2024年的THINK大会上,IBM宣布与Mistral AI建立了新的战略合作伙伴关系。IBM将很快在IBM® watsonx.ai™平台上为客户提供Mistral系列商业模型,支持本地部署和IBM Cloud®。这包括Mistral-Large的最新版本,这是市场上领先的AI模型之一。IBM期待继续与Mistral AI进行开源合作,包括他们广受欢迎的开源混合专家模型系列Mixtral,以及IBM InstructLab优化的Mistral 7B变体Merlinite。

- 沙特数据与人工智能管理局(SDAIA):在THINK大会上,IBM首次推出SDAIA开发的ALLaM,这是一款开放的阿拉伯语大型语言模型(LLM),并将其集成到watsonx平台上。这一举措突显了这两个组织如何通过新技术(如生成式AI)合作,推动中东地区的转型。

请阅读最近在IBM THINK大会上宣布的与第三方模型合作伙伴关系相关的更多消息。IBM业务发展和战略合作伙伴团队还将继续签署特定的商业和独立软件供应商协议,以扩展平台上的模型选择。 正如 Forrester 所言,在基础模型方面,选择和灵活性将成为企业决策的关键因素。

来源:业界供稿

好文章,需要你的鼓励

中科院与字节跳动联合发布DAComp:人工智能在数据分析上竟然还不如人类想象的聪明

中科院与字节跳动联合发布DAComp基准测试,发现即便是最先进的AI模型在企业级数据工程和分析任务中表现远不如预期。测试显示最强模型的成功率仅20%,揭示了AI在系统协调、商业洞察等方面的重大局限性,为企业数字化转型提供了重要参考。

Ant Group团队打造实时视频生成新突破:23.1帧的流畅画面如何炼成

浙江大学和Ant Group联合团队开发了名为"Reward Forcing"的视频生成技术,通过EMA-Sink智能记忆系统和Re-DMD动感优化机制,解决了AI视频生成中的"画面回跳"和动作呆板问题,实现了23.1帧每秒的实时生成速度,在多项测试中超越现有技术,为实用化AI视频应用奠定基础。

AI“下半场”:算力筑基、推理向实、Agent 织网、科学破界

近30位行业领袖共聚北京,同台纵论AI技术底座与智能体新范式

2025年,AI有这10大趋势

一份榜单,读懂2025中国AI公司、人物与产品

让图像生成既快又稳的秘密武器

Empromptu获200万美元融资,助力企业构建AI应用

Linux基金会宣布成立智能体AI基金会,Anthropic、OpenAI、Block加入

Tricentis投入智能体AI技术应对企业未测试代码风险

FDA批准首个AI工具用于MASH临床试验

Relation与诺华达成过敏性疾病靶点发现合作

CIO应当制定IT治理"宪法"的时候到了

利雅得航空与IBM合作打造全球首家AI原生航空公司