首创技术:维谛Vertiv作为英伟达NVIDIA独家制冷合作伙伴,引领AI应用快速发展

面对AIGC的快速发展,维谛Vertiv(NYSE: VRT)与英伟达NVIDIA专家团队共同针对高密数据中心制冷方案进行研发测试,并发布实测数据:

GPU型高密数据中心的冷板液冷和风冷的创新风液混合制冷方案中大约 75% 的 IT 负载可通过冷板液冷技术实现有效冷却。

维谛Vertiv与英伟达NVIDIA专家团队在配置Vertiv™Liebert®PCW,Vertiv™ Liebert®XDU液冷装置, Vertiv™ Liebert®AFC的数据中心进行能耗分析。

这一方案不但可以帮助用户每年降低10%的能源成本,还可以减少相同比例的范围2碳排放量。

当前许多数据中心处于风冷、液冷混合转型的需求阶段,此次实验环境以较常见的中型1000-2000kW机房进行分析。该机房内包含50 个高密度机柜(Racks),除了原有的风冷装置Vertiv™ Liebert® PCW外,液冷系统由 Vertiv™ Liebert® AFC 冷水机组,以及两个配备液体-液体热交换器的 Vertiv™ Liebert® XDU 冷却液体分配单元组成。

实测结果显示IT负载从100%风冷转型为75%液冷的方案时,服务器风扇用电量降低最多达到80%,使总体使用效率(Total Usage Effectiveness, TUE)提高15%以上。

*TUE 指标的计算方法,把非直接应用 IT 侧的风扇和其他设备的用电量,与储存和运算所需的 IT 用电量分开,从而更真实反映 IT 能源使用效率。此实验的另一个重要发现是,在比较液冷和风冷系统的效率、或评估液冷方案的效率时,TUE 是比 PUE 更准确、更有价值的指标。

共研未来数据中心新型制冷方案 与英伟达NVIDIA 持续合作

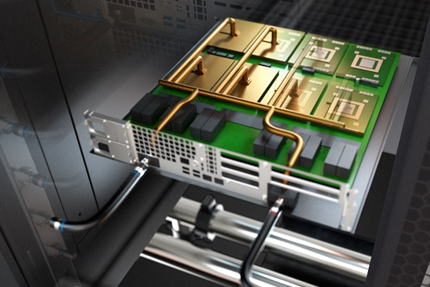

为共同迎接未来智算中心的挑战,维谛Vertiv 参与了英伟达NVIDIA 重要的COOLERCHIPS 计划,并被指定为唯一的制冷系统合作伙伴。

历经三年努力,英伟达NVIDIA 与维谛Vertiv 共同提出的机架式混合冷却系统方案,是业界首次将两种液冷技术:冷板液冷和浸没液冷耦合到同一系统中的解决方案。

这项创新系统预计可冷却运行环境高达 40 ℃的机架式数据中心,单机柜IT功率可达 200kW,是目前常规服务器单机柜功率的 25 倍。与传统风冷相比,两种液冷混合冷却模式的成本更低,运作效率可提高 20%,且更安静、碳足迹更少。

通过与英伟达NVIDIA 合作,进行实际数据中心测试和新型液冷方案系统设计,不但与维谛Vertiv 自身解决方案开发愿景一致,更显示出我们始终致力于研发创新产品,适应制冷产业趋势和确立颠覆性且革新的技术领导地位。未来我们仍将扩展数据中心冷却技术的生态体系,与英伟达NVIDIA 等一流合作伙伴共同开发降低数据中心能耗、达成零碳排放的创新方案。

更多详细信息,请关注“维谛技术(Vertiv)”

关于维谛技术(Vertiv)

维谛技术(Vertiv,NYSE:VRT)致力于保障客户关键应用的持续运行、发挥最优性能、业务需求扩展,并为此提供硬件、软件、分析和延展服务技术的整体解决方案。维谛技术(Vertiv)帮助现代数据中心、边缘数据中心、通信网络、商业和工业设施客户所面临的艰巨挑战,提供全面覆盖云到网络边缘的电力、制冷和IT基础设施解决方案和技术服务组合。Architects of Continuity™恒久在线,共筑未来!如需了解更多信息,欢迎访问Vertiv.com,售前热线400-887-6526。

好文章,需要你的鼓励

让AI记住房间每个角落:悉尼大学团队如何让视频生成拥有“空间记忆“

悉尼大学和微软研究院联合团队开发出名为Spatia的创新视频生成系统,通过维护3D点云"空间记忆"解决了AI视频生成中的长期一致性难题。该系统采用动静分离机制,将静态场景保存为持久记忆,同时生成动态内容,支持精确相机控制和交互式3D编辑,在多项基准测试中表现优异。

西班牙病毒如何将谷歌带到马拉加

33年后,贝尔纳多·金特罗决定寻找改变他人生的那个人——创造马拉加病毒的匿名程序员。这个相对无害的病毒激发了金特罗对网络安全的热情,促使他创立了VirusTotal公司,该公司于2012年被谷歌收购。这次收购将谷歌的欧洲网络安全中心带到了马拉加,使这座西班牙城市转变为科技中心。通过深入研究病毒代码和媒体寻人,金特罗最终发现病毒创造者是已故的安东尼奥·恩里克·阿斯托尔加。

马里兰大学突破性发现:AI推理过程终于有了“身体检查“——ThinkARM框架揭开大型语言模型思维奥秘

马里兰大学研究团队开发ThinkARM框架,首次系统分析AI推理过程。通过将思维分解为八种模式,发现AI存在三阶段推理节律,推理型与传统AI思维模式差异显著。研究揭示探索模式与正确性关联,不同效率优化方法对思维结构影响各异。这为AI系统诊断、改进提供新工具。

生命科学计算测试专委会正式成立,BioProfile框架引领行业标准建设

超智算完成北京核心智算中心资产收购,加速构筑“3+X”全国算力网络新格局

走出“参数崇拜”:联想用“一体多端”重塑“人的尺度”

从“单点突破”到“一体多端”:拆解天禧AI 3.5进化背后三年的进化哲学

openGauss Summit 2025在京召开,加速行业智能化变革,共建繁荣数据库生态

2025联想天禧AI生态伙伴大会:天禧AI一体多端,与开发者共建个人AI生态

西班牙病毒如何将谷歌带到马拉加

LangChain核心库曝出严重漏洞,AI智能体机密信息面临泄露风险

Mill如何与亚马逊和全食超市达成合作协议

TechCrunch创业大赛中的9家顶尖生物技术初创公司

2025年印度科技领域十大重要发展

中科大发布Live Avatar:AI数字人无限聊天不翻车