时代的弃儿与最后一击 思杰(Citrix)退出中国市场的理所当然 原创

你还记得Xen吗?

你还在使用虚拟化吗?

自从Citrix被Cloud Software Group收购退市后,曾经的虚拟化巨头其实某种意义上已经名存实亡。

Cloud Software Group为大规模企业提供关键任务软件。思杰、TIBCO、NetScaler、Jaspersoft、ibi和ShareFile都是Cloud Software Group旗下的品牌。

云原生时代的弃儿

政治与经济总是息息相关,在众所周知的中美之间的PK中,IT产业肯定是首当其中。

我们熟悉的国外厂商纷纷抽身中国市场,一方面是中美博弈的结果,另一方面则是整个IT市场的变革。

而今天,思杰(Citrix)宣布退出中国市场,似乎预示了传统IT架构的落幕。为什么这么说?

虚拟化技术出现于20世纪60年代,此前一直是一门小众的技术,直至x86架构的出现与之完美融合,进而在21世纪前后迎来爆发。

这些年,我们每一个人都可以觉察到数字生活的巨大变化。而这背后是整个IT技术的变化,比如云计算、大数据、人工智能、5G等。

就拿思杰(Citrix)所在的虚拟化市场来说,其直接面对K8S容器技术的冲击。

这种冲击是颠覆性的。经过几年的技术发展和大规模实践,越来越多企业将基于虚拟机的应用程序迁移到容器。

虽然虚拟化也是一种硬件和软件的解耦,但是这种解耦还不够彻底,而容器技术则站在应用角度实现了颗粒度更细的资源利用。

记得在容器技术刚刚出现的时候,业界也在讨论虚拟化与容器孰优孰劣,就像当初公有云与私有云的讨论。

其实不光思杰(Citrix),我们看到被博通收购的VMware的处境也并不乐观。

总之,淘汰思杰(Citrix)和VMware的是时代,因为云时代的云原生才是客户想要的。不管是思杰(Citrix)还是VMware,他们只能奋起直追。

来自国产替代的最后一击

另外对于退出中国市场这件事,其实也没啥可说的。

思杰(Citrix)提供的本地部署的软件以及云端交付的服务,而中国特色的中国市场让思杰(Citrix)水土不服。

虽然思杰(Citrix)也可以国内的伙伴有很多合作,但是随着整个信创(国产替代)的推进,思杰(Citrix)的市场一再被挤压。

原有生产业务加快从国外虚拟化平台迁移到国产信创体系上,国内关键行业客户往往倾向寻求与VMware功能及产品结构对标的虚拟化平台,以降低业务迁移过程中的风险与迁移成本。

在这种趋势下,国内厂商发展迅速,如浪潮、深信服、EasyStack易捷行云、ZStack云轴科技。

而国内公有云大厂,如华为、阿里、腾讯等,他们也转向了自研或者云原生。

Gartner的《中国语境:2023Q2服务器虚拟化市场指南》报告认为,越来越多的企业正在从国外的供应商(如:VMware)向中国供应商转移。在中国,技术重点已经转移到容器化和自动化。

写在最后

下一个离开中国市场的企业会是谁呢?

这是一个充满不确定性的时代,挑战与机遇总是并存。当一扇门关闭的时候,往往一扇窗也就打开了。

题外话:笔者曾多次参加Citrix在美国举行的Synergy大会,以及思杰中国在位于北京东方广场办公楼办公室举办的新闻发布会,并参观思杰设在南京的研发中心。

对于思杰(Citrix)退出中国,除了唏嘘,还有什么呢?

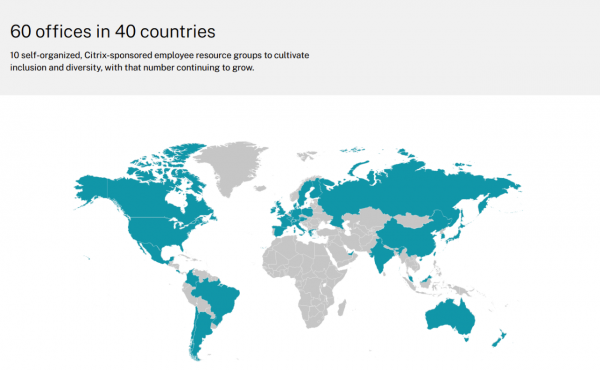

对了,看了下Citrix的官网,这张地图是不是需要更换了。

好文章,需要你的鼓励

CES 2026:日立与英伟达、谷歌云、Nozomi Networks达成合作协议

日立公司在CES 2026技术展上宣布了重新定义人工智能未来的"里程碑式"战略,将AI直接应用于关键物理基础设施。该公司与英伟达、谷歌云建立重要合作伙伴关系,并扩展其数字资产管理平台HMAX,旨在将AI引入社会基础设施,变革能源、交通和工业基础设施领域。日立强调其独特地位,能够将AI集成到直接影响社会的系统中,解决可持续发展、安全和效率方面的紧迫挑战。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

2026年科技行业多元化发展前景与挑战预测

科技行业女性从业者比例从2015年的16%增至2025年的22%,进步缓慢。尽管各种倡议不断推进,但多元化员工仍面临离职率高、薪酬差距和发展机会不足等问题。2025年经济不确定性导致企业削减多元化项目,美国政策变化也产生连锁反应。随着AI技术快速发展,缺乏多元化团队将导致技术偏见,影响产品质量和市场表现。2026年将成为科技行业多元化发展的关键节点。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

CES 2026:日立与英伟达、谷歌云、Nozomi Networks达成合作协议

2026年科技行业多元化发展前景与挑战预测

智能体AI推动云安全策略根本性变革

Salesforce推出AI能力框架助力企业数字化转型

大众汽车牵手高通打造智能网联座舱体验

Ruby 4.0.0发布:引入ZJIT编译器和Ruby Box隔离技术

Meta签约三家核能公司为AI数据中心提供6.6吉瓦电力

大多数开发者不信任AI生成代码却不检查

大规模数据中心安全防护中人员因素的关键作用

HPE OneView严重漏洞遭野外攻击利用

安联保险与Anthropic达成全球合作加速负责任AI应用

智能硬件助力Apple Home:Flic物理按钮控制解决方案