AMD争夺AI“制霸权” ——第四代AMD EPYC处理器 手握AI摘“星辰” 原创

在一家大型电商公司中,有一个名为"星辰"的产品推荐团队。他们的任务是为每一个用户寻找属于他们的那颗“星”——最适合他们的产品。

在寻找产品的过程中,最大的挑战就是如何在亿万商品中,找到最符合每个用户需求和喜好的那一款。他们尝试过各种方法,但总是无法达到理想的效果。于是,他们决定尝试使用大模型。

随着大模型的阶段性部署,"星辰"搭建起一座连接用户和商品的桥梁,帮助用户在繁杂的商品海洋中找到他们的宝藏。同时星辰团队也收获了他们的成果.....近年来,大模型的发展取得了巨大的突破,许多"星辰"这样的企业都因大模型收获了成功。然而,AI入局带来的算力需求“跳变”,为AI的算力供给提出了新的要求——AI时代,应用正倒逼着AI算力加速扩展。

目前,支持AI计算的硬件多种多样,CPU、GPU、FPGA、ASIC都在在AI领域中都扮演着至关重要的角色,在AI领域,它们的作用就像是一场接力赛中不同赛道的选手。GPU主要负责“冲刺”,而CPU则是起跑选手,负责启动和协调整个比赛。

然而,随着AI进一步优化计算,对CPU的性能提出了更高的要求。

AMD EPYC处理器恰恰就可以满足这一要求。甚至,AMD EPYC新一代处理器正逐步突破数据中心的极限,提供更强大的性能、效率和可扩展性进一步为AI赋能。

现在,CPU在AI计算中的作用越来越大。在业内,一群AI研究人员得出了结论——“是时候让CPU再次攻克AI了”。

AMD携EPYC 争霸“AI江山”

AMD很早就推出了拥有超高性能的EPYC系列处理器,如今它又在AI计算领域展现出新的活力。

EPYC堪称AMD历史上最成功的产品系列之一,经历了初代Naples(那不勒斯),二代Rome(罗马),三代Milan(米兰)的潮流风暴后,四代Genoa(热那亚)等系列的相继推出,则将EPYC一副“壮丽之城”的图景展现在人们面前。

2022年,AMD发布了Zen 4架构的AMD EPYC处理器“Genoa”,采用了先进的5nm工艺,最多可达到96核心192线程,配备了12通道DDR5内存和160条PCIe 5.0总线。更大的内存总线,可以令更多数据在内存中进行快速加载,从而有效减少因数据传输而造成的时延;更多的PCIe总线意味着在单台服务器上可以接入更多AI计算板卡,意味着在更小数据中心空间内可以提供出更高密度的AI算力。

在今年6月份举办的“数据中心与AI技术首映”上,AMD针对云原生负载进行性了优化,带来了以吞吐量为导向,拥有最高终端密度和效率的AMD EPYC 9704处理器“Bergamo”。

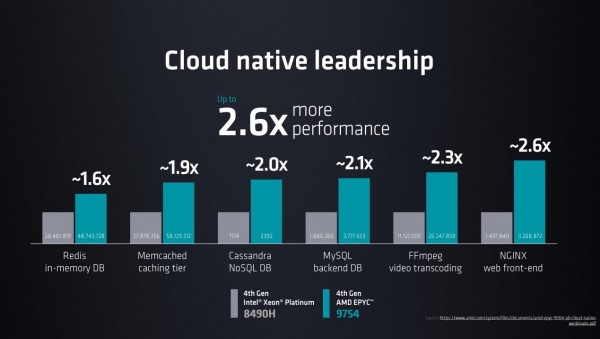

如果说Genoa是专注于通用的工作负载,Bergamo则专注于云服务器和数据中心,适用于云原生工作负载。搭载了820亿颗晶体管的Bergamo,能够最高支持 128 个 Zen 4c 核心,兼容x86 ISA 指令,可相对满足深度云计算的应用需求。针对云原生应用,从数据上看,与至强铂金8490H相比,Bergamo的性能优势更是最高达到惊人的2.6倍。事实上,更多的核心数量,对AI应用的处理能力更强。更高的加速主频,则为AI计算提供了更高的管理和控制能力。

Bergamo EPYC 9704系列处理器包括EPYC 9754、EPYC 9754S、EPYC 9734三个型号。其中,EPYC 9754和EPYC 9754S两款拥有高达128核心,前者256路线程,后者则为128路线程,热功耗均为360W,默频2.25GHz,最高可加速至3.1GHz。EPYC 9734则拥有112个核心,224路线程,热功耗为320W,默频和加速频率也降至2.2GHz和3.0GHz,三款产品的L3缓存均为256MB。

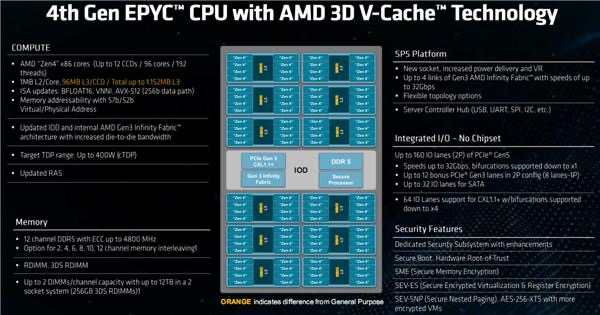

同样在本次活动上,AMD还带来了针对更高性能计算的“Genoa-X”,它将每个CCD上额外堆叠了64MB 3D缓存,那么12个CCD就是768MB,总的三级缓存达到了惊人的1152MB,这也是处理器缓存史上第一次突破1GB,如果算上6MB一级缓存(每核心独享64KB)、96MB二级缓存(每核心独享1MB),Genoa-X的缓存总量达到了1254MB,性能堪称恐怖!

Genoa-X配备了3D V-Cache技术,能够使其在更加繁重的工作负载中释放出更高性能,让更多数据以更高的效能在CPU中传递,从而有效提升AI以及需要更多缓存处理计算的能力。3D V-Cache技术采用业界首创的Hybrid bond加穿透硅通孔技术(TSV)工艺,可以让L3缓存垂直堆叠,在不改变处理器面积的前提下,可使L3缓存(SRAM)总数增加三倍。

同时,更高的Cache能在更短的时钟周期内,对AI应用进行有效处理。资料显示,采用3D V-Cache的Genoa-X 系列可以在Ansys CFX中每天完成更多的设计任务,从而大幅加速产品开发。

拥有这样性能的第四代AMD EPYC处理器,几乎都是当前技术条件下所能达到的极致。

第四代AMD EPYC处理器 处处透着“领先”

第四代AMD EPYC处理器性能卓越的主要原因之一体现在Zen 4及Zen 4c架构方面。

AMD Zen架构诞生于2017年,迄今已经先后有了14nm Zen、12nm Zen+、7nm Zen 2、7nm Zen 3,以及5nm Zen 4 Genoa处理器产品。Genoa拥有先进的5nm工艺、Zen 4架构,凭借成熟的Chiplet布局,做到最多96核心192线程,还有12通道DDR5内存、160条PCIe 5.0总线。

技术的持续突破和迭代,使得AMD处理器在近年来得到了“井喷式”的增长,无论是产品性能,还是产品的功耗,AMD处理器都做到了空前的高度。

随着AMD沿袭对创新和品质的追求,在“Zen”架构的强势加持下,AMD走出了一条近乎完美的处理器之路。

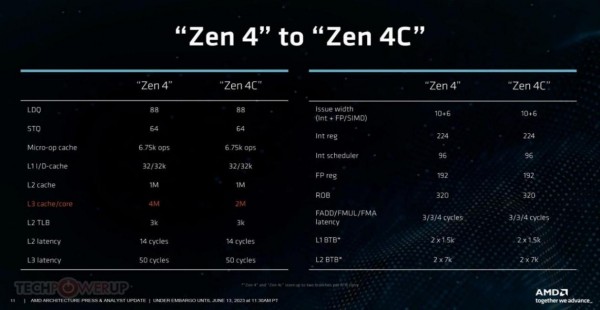

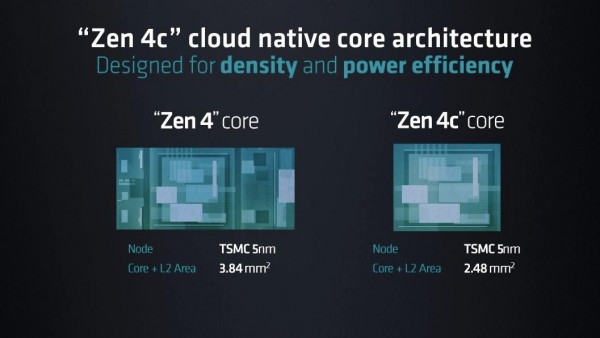

Zen 4c架构的Bergamo让我们看到了AMD“Zen”架构“再下一城”。Bergamo首次采用Zen 4c核心,它与Zen 4都基于同样的ISA指令集和IPC性能,几乎所有的微架构指标都一模一样。

Zen 4c核心的专用L2缓存,大小与Zen 4核心相同,这意味着L2 SRAM单元占用着相同的面积,而AMD通过让L2控制逻辑电路更紧凑来减少L2缓存的区域面积,而在不包含L2和相关电路的区域,核心面积极大程度缩小。相比Zen4, Zen 4c设计面积缩小了35%,每瓦性能显著提高。Zen 4c核心针对性能和功耗的最佳平衡点进行了优化,这为我们提供了更好的密度和能效。

第四代AMD EPYC处理器的强大性能不言而喻,但AMD并未满足于此,正进一步拓展EPYC处理器生态,与其他厂商的硬件配合,展现出无与伦比的强大效果。

NVIDIA的DGX高性能计算平台,就一直在使用顶级的EPYC处理器,可以加速各种类型的AI工作负载,如数据分析、训练和推理等。

第四代AMD EPYC处理器强大的性能已领先业界一步,无疑已经成为AI计算领域综合能力最强的选择之一。这个充满变数的AI时代,在提升算力的未来道路上,第四代AMD EPYC处理器必将颠覆市场格局!

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元

AMD 发布新一代 AMD RDNA(TM) 4 架构,推出 AMD Radeon(TM) RX 9000 系列显卡

苏姿丰的十年历程回顾:AMD如何从英特尔廉价替代品成长为x86领域的有力竞争者

面临AMD及自身内部挑战,英伟达Green 500主导地位受到威胁

微软率先拿下HBM驱动的AMD CPU供货

基于 AMD 加速器的 El Capitan 首次登全球超算500强榜首

突发!AMD大爆雷!

AMD Versal家族再添新成员 ——打破AI内存桎梏 支持CXL 3.1

AMD超低时延金融加速卡 帮你跑赢高频交易“竞速赛”!

要超越英伟达,AMD还须十年时间

深度剖析:聊聊英特尔与AMD各自不同的CPU整合思路