Triton推理服务器05-安装服务器软件

在前一篇文章已经带着读者创建一个Triton的推理模型仓,现在只要安装好服务器端与用户端软件,就能进行基本的测试与体验。

为了简化过程,我们使用NVIDIA Jetson AGX Orin设备进行示范,所有步骤都能适用于各种基于NVIDIA Jetson智能芯片的边缘设备上,也适用于大部分装载Ubuntu 18以上操作系统的x86设备上,即便设备上没有安装NVIDIA的GPU计算卡也能使用,只不过上我们的提供的内容都是基于GPU计算环境,对于纯CPU的使用则需要用户自行研读说明文件。

现在就开始安装Triton服务器软件,NVIDIA为Triton服务器提供以下三种软件安装的方式:

- 源代码编译:

这种方式需要从https://github.com/triton-inference-server/server下载源代码,然后安装依赖库,再用cmake与make工具进行编译。通常会遇到的麻烦是步骤繁琐,并且出错率较高,因此并不推荐使用这个方法。

有兴趣者,请自行参考前面下载的开源仓里的docs/customization_guide/build.md文件,有关于Ubuntu 20.04、Jetpack与Windows等各种平台的编译细节。

- 可执行文件:

Triton开发团队为使用者提供编译好的可执行文件,包括Ubuntu 20.04、Jetpack余Windows平台,可以在https://github.com/triton-inference-server/server/releases/ 上获取,每个版本都会提供对应NGC容器的版本,如下图:

然后到下面的“Assets”选择合适的版本:

以装载Jetpack 5的Orin为例,就下载tritonserver2.26.0-jetpack5.0.2.tgz(1.13GB) 压缩文件到本机上,然后解压缩到指定目录下就可以,例如${HOME}/triton目录,会生成<backends>、<bin>、<clients>、<include>、<lib>、<qa>等6个目录,可执行文件在<bin>目录下。

在执行Triton服务器软件前,还得先安装所需要的依赖库,请执行以下指令:

|

$ $ |

sudo apt-get update sudo apt-get install -y --no-install-recommends software-properties-common autoconf automake build-essential git libb64-dev libre2-dev libssl-dev libtool libboost-dev rapidjson-dev patchelf pkg-config libopenblas-dev libarchive-dev zlib1g-dev |

现在就可以执行以下指令启动Triton服务器:

|

$ $ |

cd ${HOME}/triton bin/tritonserver --model-repository=server/docs/examples/model_repository --backend-directory=backends --backend-config=tensorflow,version=2 |

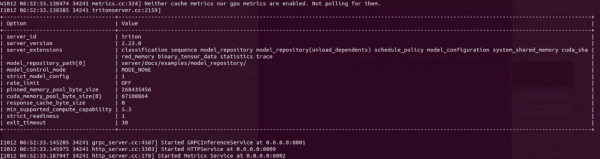

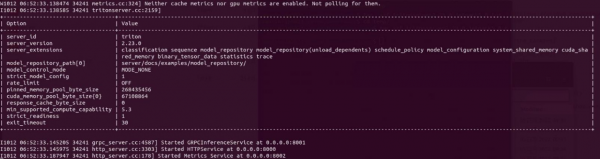

如果最后出现以下画面并且进入等待状态:

现在Triton服务器已经正常运行,进入等待用户端提出请求(request)的状态。

- Docker容器:

在NGC的https://catalog.ngc.nvidia.com/orgs/nvidia/containers/tritonserver/tags可以找到Triton服务器的Docker镜像文件,每个版本主要提供以下几种版本:

- year-xy-py3:包含Triton推理服务器,支持Tensorflow、PyTorch、TensorRT、ONNX和OpenVINO模型;

- year-xy-py3-sdk:包含Python和C++客户端库、客户端示例和模型分析器;

- year-xy-tf2-python-py3:仅支持TensorFlow 2.x和python后端的Triton推理服务器;

- year-xy-pyt-python-py3:仅支持PyTorch和python后端的Triton服务器;

- year-xy-py3-min:用作创建自定义Triton 服务器容器的基础,如Customize Triton Container(自定义Triton容器)说明文件所描述的内容;

其中“year”是年份的数字,例如2022年提交的就是“22”开头;后面的“xy”是流水号,每次往上加“1”,例如2022年10月4日提交的版本为“22-09”。

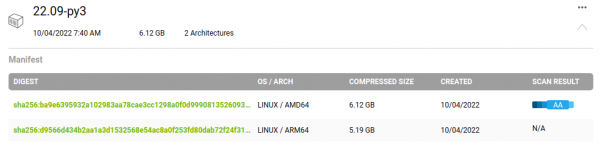

NVIDIA提供的Triton容器镜像是同时支持x86/AMD64与ARM64架构的系统,以22.09-py3镜像为例,可以看到如下图所标示的“2 Architectures”:

点击最右方的“向下”图标,会展开如下图的内容,事实上是有两个不同版本的镜像,不过使用相同镜像名:

因此在x86电脑与Jetson设备都使用相同的镜像下载指令,如下:

|

$ |

docker pull nvcr.io/nvidia/tritonserver:22.09-py3 |

就能根据所使用设备的CPU架构去下载对应的镜像,现在执行以下指令来启动Triton服务器:

|

$

$ |

# 根据实际的模型仓根目录位置设定TRITON_MODEL_REPO路径 export TRITON_MODEL_REPO=${HOME}/triton/server/docs/examples/model_repository # 执行Triton服务器 docker run --rm --net=host -v ${TRITON_MODEL_REPO}:/models nvcr.io/nvidia/tritonserver:22.09-py3 tritonserver --model-repository=/models |

如果执行正常,也会出现以下的等待画面,表示运行是正确的:

以上三种方式都能在计算设备上启动Triton服务器软件,目前看起来使用Docker镜像是最为简单的。当服务器软件启动之后,就处于“等待请求”状态,可以使用“Ctrl-C”组合键终止服务器的运行。

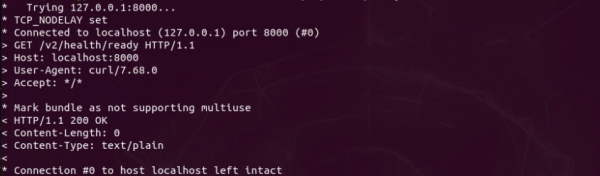

有一种确认Triton服务器正常运行的最简单方法,就是用curl指令检查HTTP端口的状态,请执行以下指令:

|

$ |

curl -v localhost:8000/v2/health/ready |

如果有显示“HTTP/1.1 200 OK”的信息(如下图),就能确定Triton服务器处于正常运行的状态:

接下去就要安装客户端软件,用来对服务器提出推理请求,这样才算完成一个最基础的推理周期。【完】

来源:业界供稿

好文章,需要你的鼓励

埃森哲与Anthropic合作引领AI集成商崛起之路

埃森哲与Anthropic扩大合作,计划培训3万名员工使用Claude,标志着企业AI战略新方向。面对复杂模型生态、治理要求和人才短缺,咨询公司正成为关键的AI系统集成商。研究显示95%的企业AI试点项目零回报,尽管投资300-400亿美元。集成商能填补技术能力与实际应用间的鸿沟,但也带来新的依赖风险。CIO需要在利用外部合作伙伴的同时保持内部能力建设和架构自主权。

字节跳动发布GAR:让AI能像人类一样精准理解图像任何区域的突破性技术

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

Pure Storage和华为存储增长最快,IDC第三季度报告显示

IDC发布2025年第三季度全球企业级存储系统市场追踪报告,显示存储市场同比增长2.1%至近80亿美元。戴尔以22.7%市场份额居首,华为以12%份额位列第二且增长9.5%。全闪存阵列表现突出增长17.6%,中端存储系统增长8.1%。地域方面,日本、加拿大和欧洲表现最佳,而美国市场下降9.9%。IDC预计随着AI应用渗透,企业对闪存存储需求将持续增长。

Inclusion AI推出万亿参数思维模型Ring-1T:首个开源的超大规模推理引擎如何重塑AI思考边界

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。

除英伟达和台积电外,其他AI公司都需要靠量补利

2025年数据中心芯片领域最热门发展趋势

自动化技术领导者揭示企业对AI认知的关键误区

五分之三企业对Wi-Fi投资信心增强

CIO部署新兴技术指南:Gartner三步法平衡风险与收益

埃森哲与Anthropic合作引领AI集成商崛起之路

Pure Storage和华为存储增长最快,IDC第三季度报告显示

英特尔或以16亿美元收购AI推理芯片初创公司SambaNova

5D记忆晶体将成为未来数据存储主流技术

首届全国独角兽企业大赛总决赛在甬顺利闭幕

为全天候绿电而生,海辰储能发布全球首个原生8小时长时储能解决方案

为AI+而生,海辰储能发布全球首款锂钠协同AIDC全时长储能解决方案