Orin开发套件05-使用Docker容器的入门技巧

上一篇内容为大家介绍了从NVIDIA NGC下载DeepStream 6.1的容器版镜像到本地在Jetson上设备的基础指令,不过在正式使用容器版DeepStream 6.1之前,我们还是需要为入门用户提供基本的使用方式与一些小技巧。

Jetson Orin开发套件内置64GB EMMC存储,并且很容易扩充64G甚至更大的NVME存储设备,可以有非常充沛的空间,在这种情况下就非常推荐使用Docker容器技术,能有效简化应用软件的安装与调试工作,非常适合用来开发与部署较为复杂的多功能智能应用,并且在NVIDIA NGC上提供了非常丰富的Docker版本应用镜像文件,用户只要一条指令便可轻松下载使用,这是边缘计算非常重要的一项应用技术。

Docker是一种比较新的“容器”技术,是NVIDIA近年来非常大力推广的应用重点,越来越多的GPU开发环境都以Docker镜像(或称为“仓”)形式提供,具备以下的优点与特性:

- 轻量级:这是相较于虚拟机的比对,容器内不需要独立操作系统,它是基于主机上的操作系统,透过一些映射指令去指向资源路径。大部分的容器镜像都在数十MB到数GB大小规模。

- 硬件调度能力:这是NVIDIA非常喜欢Docker容器技术的重点之一,虚拟机环境对GPU支持能力并不好,得透过底层穿透(pass through)方式调用,但容易影响系统稳定性。Docker容器直接与操作系统交互运作,只要主机上操作系统装好NVIDIA GPU的驱动,甚至不需要安装CUDA开发包,在Docker容器内就能轻松用上GPU并行计算的功能。

- 封装完整:相较于conda或virtualenv这类环境虚拟技术而言,Docker容器的封装更为完整而且独立,这在开发Python相关应用时更加明显,因为Python版本升级太频繁,相关依赖包之间的版本牵动关系复杂,而Docker容器的封装就显得非常有效,并且移植十分简便。

Docker作为一个开源的应用容器引擎,允许开发者很方便地打包应用程序和依赖库到可移植的容器中,然后发布到任何流行的Linux设备上,Docker完全使用沙箱机制,容器之间相互独立,不存在任何接口,因此,允许开发者在同一台机器上,运行不同环境的应用程序与服务,大大简化应用程序(或者服务)的运维操作,同时也提高了开发与测试效率。

对于CUDA设备的调用,需要NVIDIA自行开发的nvidia-docker2指令转换插件的协助,在x86设备上都需要自行安装Docker管理机制与nvidia-docker2界面,不过JetPack都为Jetson安装好了这两个元件,我们只要使用就可以。

现在就开始教大家如何使用Docker容器,以及从NVIDIA NGC中心下载可以在Jetson设备上使用的镜像。

- 检查Docker环境与修改储存路径:

用JetPack安装好系统之后,直接输入以下指令,就能检查目前系统中Docker的所有状态信息:

|

$ |

sudo docker info |

可以看到一长串关于Docker环境的内容,由于信息量较大就不在这里单独列出所有内容。如果要单纯查看版本号,只要执行以下指令就可以:

|

$ |

sudo docker version |

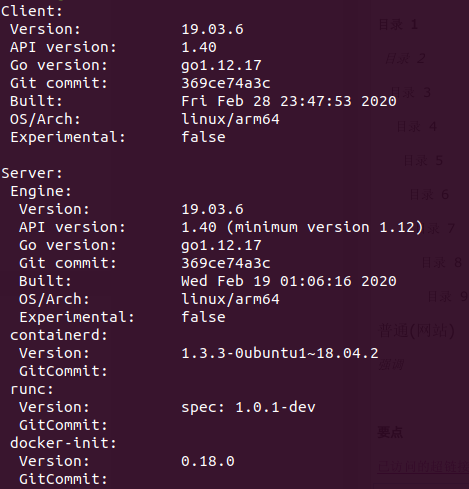

现在会看到如下版本信息,包括用户(Client)端与服务(Server)端:

如果要看最简单的版本信息,那么下面指令是最适合的:

|

$ |

sudo docker --version |

要检查目前Docker系统放置镜像文件的路径,可以执行以下指令:

|

$ |

sudo docker info | grep -i root |

系统预设的存放路径为 /var/lib/docker,如果有自己添加的额外NVME存储设备,可以在 /etc/docker/daemon.json文件中添加以下粗体的指令,调整存放路径:

|

|

# 文件 /etc/docker/daemon.json { "data-root": "<自己指定路径>", "runtimes": { "nvidia": { "path": "nvidia-container-runtime", "runtimeArgs": [] } } } |

修改完后执行以下指令,让新的设定值生效:

|

$ $ |

sudo systemctl daemon-reload sudo systemctl restart docker.service |

现在可以检查看看存储的路径是否更新。

- 简化Docker指令:

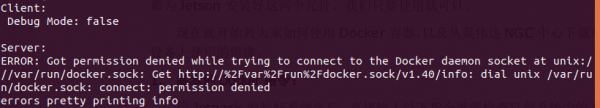

这个应用完全依赖指令操作,在Ubuntu操作系统时又需要“sudo”取得操作权限,例如执行“docker info”指令,会出现下面信息,表示权限不足。

我们可以执行以下步骤,在执行Docker指令时可以不需要使用“sudo”:

|

$ $ $ $ |

sudo groupadd docker sudo gpasswd -a ${USER} docker sudo service docker restart newgrp - docker |

当然,这只是简化权限的问题,仅提供一个参考。

- 从NGC寻找合适的镜像文件

访问http://ngc.nvidia.com/ 会出现如下画面,在左上方“搜索栏(漏斗图标)”中输入“l4t”关键字,就会列出能在Jetson上运行的镜像列表。

目前已经提供近20个容器镜像,分为以下6大类别:

- 基础类:

- NVIDIA L4T Base:

https://catalog.ngc.nvidia.com/orgs/nvidia/containers/l4t-base

- NVIDIA L4T CUDA:

https://catalog.ngc.nvidia.com/orgs/nvidia/containers/l4t-cuda

- NVIDIA Container Toolkit:

https://catalog.ngc.nvidia.com/orgs/nvidia/teams/k8s/containers/container-toolkit

- 深度学习类:

- NVIDIA L4T ML:深度学习综合开发环境

https://catalog.ngc.nvidia.com/orgs/nvidia/containers/l4t-ml

- NVIDIA L4T PyTorch:

、 https://catalog.ngc.nvidia.com/orgs/nvidia/containers/l4t-pytorch

- NVIDIA L4T TensorFlow:

https://catalog.ngc.nvidia.com/orgs/nvidia/containers/l4t-tensorflow

- NVIDIA L4T TensorRT:

https://catalog.ngc.nvidia.com/orgs/nvidia/containers/l4t-tensorrt

- 视觉类:

- DeepStream-l4t

https://catalog.ngc.nvidia.com/orgs/nvidia/containers/deepstream-l4t

- DeepStream L4T - Intelligent Video Analytics Demo

https://catalog.ngc.nvidia.com/orgs/nvidia/helm-charts/video-analytics-demo-l4t

- DeepStream People Detection Demo on Jetson

https://catalog.ngc.nvidia.com/orgs/nvidia/containers/deepstream-peopledetection

- Gaze Demo for Jetson/L4T

https://catalog.ngc.nvidia.com/orgs/nvidia/containers/jetson-gaze

- Pose Demo for Jetson/L4T

https://catalog.ngc.nvidia.com/orgs/nvidia/containers/jetson-pose

- 对话类:

- Voice Demo for Jetson/L4T

https://catalog.ngc.nvidia.com/orgs/nvidia/containers/jetson-voice

- Riva Speech Skills

https://catalog.ngc.nvidia.com/orgs/nvidia/teams/riva/containers/riva-speech

- 教学类:

- DLI Getting Started with AI on Jetson Nano

https://catalog.ngc.nvidia.com/orgs/nvidia/teams/dli/containers/dli-nano-ai

- DLI Building Video AI Applications at the Edge on Jetson Nano

https://catalog.ngc.nvidia.com/orgs/nvidia/teams/dli/containers/dli-nano-deepstream

- 医疗类:专属于Clara AGX的应用容器镜像。

- 下载NVIDIA L4T ML镜像并创建容器

这是能在Jetson设备上执行的最完整的机器学习(Machine Learning)软件栈镜像,访问https://catalog.ngc.nvidia.com/orgs/nvidia/containers/l4t-ml 之后就能看到容器内所包含的内容,以l4t-ml:r32.6.1-py3版本为例,其打包的工具与功能库如下:

- TensorFlow 1.15.5

- PyTorch v1.9.0

- torchvision v0.10.0

- torchaudio v0.9.0

- onnx 1.8.0

- CuPy 9.2.0

- numpy 1.19.5

- numba 0.53.1

- OpenCV 4.5.0 (with CUDA)

- pandas 1.1.5

- scipy 1.5.4

- scikit-learn 0.23.2

- JupyterLab 2.2.9

这已经涵盖我们所需要的绝大部分内容,只要下载镜像后生成执行的容器,就能直接使用里面的开发环境,这样能节省非常大量的安装与调试的时间。

点击页面右上角“Pull Tag”按钮,会列出目前可下载版本的镜像文件,最好选择配合目前JetPack版本的镜像,例如用JetPack 5.0DP安装的Jetson Orin开发套件,其L4T版本为34.1.1,就用下面指令下载r34.1.1-py3镜像:

|

$ |

docker pull nvcr.io/nvidia/l4t-ml:r34.1.1-py3 |

下载完成之后可以用以下指令检查:

|

$ |

docker images |

如果出现以下信息,则表示下载完成。

|

REPOSITORY TAG IMAGE ID CREATED SIZE nvcr.io/nvidia/l4t-ml r34.1.1-py3 93c715e8751b 6 weeks ago 16.2GB |

这个方法可以用在任何L4T版本镜像文件上。

下一篇文章我们将进一步带着大家用这个镜像文件去创建容器,并且开始执行演示或开发的内容。

来源:业界供稿

好文章,需要你的鼓励

让AI看图功能瘦身90%:希腊塞萨洛尼基大学发现图像修复“中奖彩票“神经网络

希腊塞萨洛尼基大学研究团队开发出MIR-L算法,通过"彩票假说"发现大型图像修复网络中的关键子网络。该算法采用迭代剪枝策略,将网络参数减少90%的同时保持甚至提升修复性能。MIR-L能同时处理去雨、去雾、降噪等多种图片问题,为资源受限设备的实时图像处理提供了高效解决方案,具有重要的实用价值和环保意义。

人工智能使用大揭秘:OpenRouter公司百万亿规模数据分析报告

这项由OpenRouter公司团队和Andreessen Horowitz(a16z)投资机构联合开展的研究,于2025年12月发表。

卡内基梅隆大学提出DistCA:让AI训练告别“木桶效应“的神奇技术

卡内基梅隆大学团队提出DistCA技术,通过分离AI模型中的注意力计算解决长文本训练负载不平衡问题。该技术将计算密集的注意力任务独立调度到专门服务器,配合乒乓执行机制隐藏通信开销,在512个GPU的大规模实验中实现35%的训练加速,为高效长文本AI模型训练提供了新方案。

NVIDIA Nemotron 3 系列开放模型: 击穿AI“工程墙”开启“Agentic AI”的“Linux时刻”

W.AWARDS金网奖2026未来商业计划领航秀峰会收官

人工智能使用大揭秘:OpenRouter公司百万亿规模数据分析报告

智能化与全球化并进,IBM中国下一个40年思考

通用汽车推出原生Apple Music应用并支持空间音频

GMV推进卫星导航技术助力自动驾驶运输与物流发展

英伟达考虑增产H200芯片满足中国市场激增需求

IBM推出开源智能体CUGA 任务完成率超五成

OpenAI支持的生物技术公司Chai Discovery获1.3亿美元B轮融资

八问智能时代:西云数据的八个答案

塑造2026年的八大智能手机趋势

AI架构师荣获《时代》杂志年度人物称号

分析:NVIDIA第二季度财报再次超出预期背后的新问题

Jetson百万开发者故事 | 校企合作推动实现多项工业场景下AI边缘计算应用

Jetson百万开发者故事 | NVIDIA Jetson助力水产养殖企业打造自动化流水线

Jetson百万开发者故事 | 基于Jetson Nano的便携式岩石分类检测系统:地质学家的新利器

Jetson百万开发者故事 | 让AI成为铁路客运站自动扶梯安全管控的关键

Jetson百万开发者故事 | Jetson开发者突破百万,从TK1到Orin我都经历了啥

百万Jetson开发者故事

Jetson百万开发者故事 | NVIDIA Jetson如何成为可移动智能脑机交互平台

全新NVIDIA Jetson Orin NX 16GB大幅提升边缘AI性能

Triton推理服务器13-模型与调度器(3)