新架构 新功能 新突破 NVIDIA Hopper架构亮点多 原创

每年的GTC大会,NVIDIA总会带来令人惊喜的产品。在今年的GTC 2022大会上,NVIDIA宣布推出采用NVIDIA Hopper架构的新一代加速计算平台。这一全新架构以美国计算机领域的先驱科学家Grace Hopper的名字命名,将取代两年前推出的NVIDIA Ampere架构。

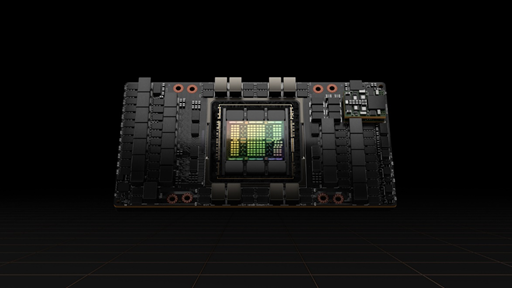

NVIDIA同时发布其首款基于Hopper 架构的GPU——NVIDIA H100。该款GPU集成了800亿个晶体管。H100是全球范围内最大的性能出众的加速器,拥有革命性的Transformer引擎和高度可扩展的NVIDIA NVLink互连技术等突破性功能,可推动庞大的AI语言模型、深度推荐系统、基因组学和复杂数字孪生的发展。

在笔者看来,这次NVIDIA Hopper架构的亮点还是非常多的,比如在制程工艺、引入Transformer、第4代NVIDIA NVLink、新的DPX指令等,这些让NVIDIA H100在驱动新的工作负载方面更加得心应手。

新架构带来新突破

作为全新架构,H100 NVIDIA GPU带来了六项突破性创新:

新工艺带来产品新高度——如今,半导体产业在制程工艺方面不断精进创新。H100由800亿个晶体管构建而成,这些晶体管采用了专为NVIDIA加速计算需求设计的尖端的TSMC 4N工艺,因而能够显著提升AI、HPC、显存带宽、互连和通信的速度,并能够实现近5TB/s的外部互联带宽。

H100是首款支持PCIe 5.0的GPU,也是首款采用HBM3的GPU,可实现3TB/s的显存带宽。20个H100 GPU便可承托相当于全球互联网的流量,使其能够帮助客户推出先进的推荐系统以及实时运行数据推理的大型语言模型。

新引擎加速大模型计算——Transformer现在已成为自然语言处理的标准模型方案,也是深度学习模型领域最重要的模型之一。H100加速器的Transformer引擎旨在不影响精度的情况下,将这些网络的速度提升至上一代的六倍,可以更好地处理NLP和对话类AI应用。

MIG让云部署更便捷——第二代安全多实例GPU(MIG技术)支持将单个GPU分为七个更小且完全独立的实例,以处理不同类型的作业。与上一代产品相比,在云环境中Hopper架构通过为每个GPU实例提供安全的多租户配置,将MIG的部分能力扩展了7倍,这样可以方面CSP进行云端交付GPU。

数据加密让计算更安全——如今数据隐私安全至关重要,而H100是全球首款具有机密计算功能的加速器,可保护AI模型和正在处理的客户数据。客户还可以将机密计算应用于医疗健康和金融服务等隐私敏感型行业的联邦学习,也可以应用于共享云基础设施。

新互联技术让连接更顺畅——为加速大型AI模型,第4代NVIDIA NVLink结合全新的外接NVLink Switch,可将NVLink扩展为服务器间的互联网络,最多可以连接多达256个H100 GPU,相较于上一代采用NVIDIA HDR Quantum InfiniBand网络,带宽高出9倍,这样让数据处理通路更加顺畅。

新指令加速算法——硬件级的加速往往比软件加速更加有效。NVIDIA H100借助新的DPX指令可加速动态规划,适用于包括路径优化和基因组学在内的一系列算法,与CPU和上一代GPU相比,其速度提升分别可达40倍和7倍。Floyd-Warshall算法与Smith-Waterman算法也在其加速之列,前者可以在动态仓库环境中为自主机器人车队寻找最优线路,而后者可用于DNA和蛋白质分类与折叠的序列比对。

两种规格满足多样化部署需求

为了满足各种服务器设计需求,H100将提供SXM和PCIe两种规格。此外,NVIDIA还会推出融合加速器,耦合H100 GPU与NVIDIA ConnectX-7 400Gb/s InfiniBand和以太网智能网卡。

NVIDIA H100 SXM提供4 GPU和8 GPU配置的HGX H100服务器主板,可助力企业将应用扩展至一台服务器和多台服务器中的多个GPU。基于HGX H100的服务器可为AI训练和推理以及数据分析和HPC应用提供更高的应用性能。

H100 PCIe通过NVLink连接两块GPU,相较于PCIe 5.0,可提供7倍以上的带宽,为主流企业级服务器上运行的应用带来卓越的性能。PCIe规格便于集成到现有的数据中心基础设施中。

H100 CNX是一款全新的融合加速器。这款加速器将H100与ConnectX-7智能网卡相结合,可为I/O密集型应用(如企业级数据中心内的多节点AI训练和边缘5G信号处理)提供强劲性能。

我们知道NVIDIA致力于打造3U一体的战略,也就是CPU、GPU、DPU。在今年GTC上,NVIDIA正式推出了Grace CPU。而NVIDIA Hopper架构GPU可与NVIDIA Grace CPU通过NVLink-C2C互联,与PCIe 5.0相比,可将CPU和GPU之间的通信速度提高7倍以上。这一组合,即Grace Hopper超级芯片,可用于大规模HPC和AI应用。

NVIDIA H100可部署于各种数据中心,包括内部私有云、云、混合云和边缘数据中心。

Hopper已在行业内获得各大云服务提供商的广泛支持,包括阿里云、AWS、百度智能云、Google Cloud、Microsoft Azure、Oracle Cloud、腾讯云和火山引擎,这些云服务商均计划推出基于H100的实例。

全球领先的系统制造商,包括源讯、BOXX Technologies、思科、戴尔科技、富士通、技嘉、新华三、慧与(HPE)、浪潮、联想、宁畅和超微预计推出各种采用H100加速器的服务器。

这款产品预计于今年晚些时候全面发售,届时企业可从全球各大云服务提供商和计算机制造商处购买,或者直接从NVIDIA官方渠道购买。

结语

从产品更新看,NVIDIA Hopper架构的亮点非常多,紧跟当下技术发展趋势,特别是人工智能应用的多样化发展。NVIDIA H100依靠在工艺、加速引擎、机密计算、互联技术、指令集等方面的创新,为现代化基础设施提供了源源不断的动力。

来源:至顶网计算频道

好文章,需要你的鼓励

联想推出跨设备AI智能体,挑战微软和谷歌

联想在CES展会上发布了AI助手Qira,该系统可跨联想和摩托罗拉设备生态运行,包括智能手机、可穿戴设备、PC和平板等。Qira不仅是聊天机器人,还能执行实际任务,如设备间文件传输。该系统具备情境感知能力,通过融合知识库创建个性化体验。联想强调隐私保护,优先本地处理数据。Qira将于2026年第一季度首先在联想设备上推出。摩托罗拉还展示了搭载Qira的AI可穿戴设备Project Maxwell概念产品。

剑桥大学突破性研究:如何让AI在对话中学会真正的自信判断

剑桥大学研究团队首次系统探索AI在多轮对话中的信心判断问题。研究发现当前AI系统在评估自己答案可靠性方面存在严重缺陷,容易被对话长度而非信息质量误导。团队提出P(SUFFICIENT)等新方法,但整体问题仍待解决。该研究为AI在医疗、法律等关键领域的安全应用提供重要指导,强调了开发更可信AI系统的紧迫性。

麦肯锡和General Catalyst高管:AI时代终结“一次学习,终身受用“模式

在CES 2026主题演讲中,麦肯锡全球管理合伙人鲍勃·斯特恩费尔斯和通用催化剂CEO赫曼特·塔内贾表示,AI正以前所未有的速度重塑技术领域。塔内贾指出,Anthropic估值在一年内从600亿美元飙升至数千亿美元,预计将出现新一波万亿美元公司。然而,非技术企业对AI全面采用仍持观望态度。两位高管强调,人们必须认识到技能培训和再培训将是终身事业,传统的22年学习40年工作模式已被打破。

威斯康星大学研究团队破解洪水监测难题:AI模型终于学会了“眼观六路“

威斯康星大学研究团队开发出Prithvi-CAFE洪水监测系统,通过"双视觉协作"机制解决了AI地理基础模型在洪水识别上的局限性。该系统巧妙融合全局理解和局部细节能力,在国际标准数据集上创造最佳成绩,参数效率提升93%,为全球洪水预警和防灾减灾提供了更准确可靠的技术方案。

AI代码编辑器扩展推荐漏洞引发供应链安全风险

身份暗物质威胁企业网络安全的新挑战

Ambiq推出首款能耗优化NPU芯片组,为电池设备带来先进AI能力

英伟达推出AI推理上下文NVMe SSD存储解决方案

Infinidat最新升级让勒索软件攻击者胆寒

Lightricks-2 AI视频模型实现设备端运行突破

微软收购Osmos数据平台,强化Fabric智能数据工程能力

微软Excel股票历史功能新年故障,用户纷纷寻找替代方案

Infinidat最新升级让勒索软件攻击者不寒而栗

Commonwealth Fusion Systems完成首个反应堆磁体安装并与英伟达达成合作

宏碁游戏产品线扩展平价硝基系列,推出全新显示面板

DayOne数据中心获得20亿美元C轮融资,推进全球建设计划

NVIDIA Blackwell 现已在云端全面可用

为“代理式AI”装上“护栏” NVIDIA打造“三重防线”

黄仁勋现身北京致辞:60年后,计算机正被重新定义

CES 2025 | NVIDIA Isaac GR00T Blueprint 让人形机器人“加速进化”

未来,就在我们手中

CES 2025 | 代理式AI崛起:NVIDIA定义下一代“代理式 AI Blueprint”

深度学习最佳 GPU,知多少?

NVIDIA推出用于多语言生成式人工智能的NeMo Retriever微服务

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示完美收官!

老黄掏出“迷你版AI超算”,每秒67万亿次运算,仅售2070元人民币