全系列新品正式全球发布!跨代升级,华为持续创新

近日,在华为超高密模块化UPS全系列线上发布会上,新一代中大型UPS5000-H全系列产品正式发布。该系列搭载100kVA/3U超高密热插拔功率模块,是业界首个实现“一柜一兆瓦”的UPS产品。

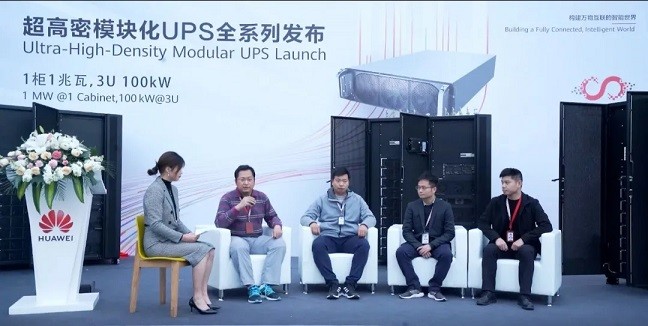

发布会上,由华为数字能源产品线数据中心供电领域总经理李庆委和该系列产品的研发测试团队共同为新品揭幕。

供电系统未来发展关键词:

“高密””高效”“ 智能化”

UPS的技术发展十年一巨变,赛迪顾问电子信息产业研究中心副总经理贾珊珊在分享中表示,上一个10年,UPS新技术以“高频”“模块化”等特点驱动市场格局快速更替,下一个10年,随着新基建红利充分释放,UPS将迎来发展红利期,并且“模块化”“高密”“绿色”的特点将愈发凸显。

在此趋势下,数据中心供配电系统不断创新和发展,中国移动通信集团设计院信息能源所副所长李玉昇指出,当前数据中心供电设施面临运行效率低、设备体积大、维护工作量大等挑战,因此变革势在必行,通过技术演进、新技术和新产品推动供电设施向高密、高效、智能方向发展。

跨代升级,创新突破点:

一柜一兆瓦,3U 100kW

一直以来,华为持续投入研发创新,对UPS产品的性能和指标不断突破极限。据华为数字能源产品线数据中心供电领域总经理李庆委介绍,本次重磅发布的系列新品,实现了器件级、模块级、系统级的跨代升级。

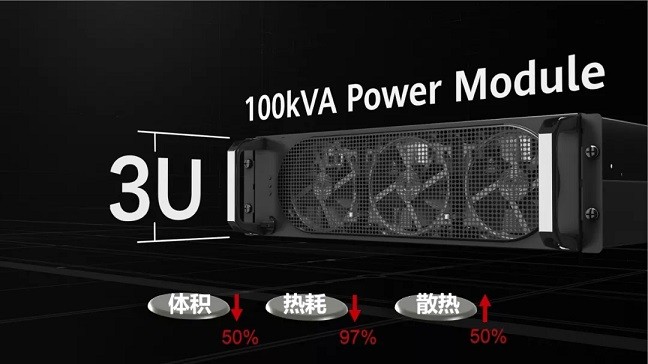

FusionPower系列UPS 5000-H全系列产品图

华为100kW UPS功率模块在体积、热耗、散热等方面进行了创新设计。在体积方面,华为创新专利助力更小体积,打造刀片级功率模块,如“拓扑池化”专利,使体积降低40%;磁集成专利,使电感体积降低20%。在热耗方面,采用三电平于交错并联拓扑架构、先进器件优化及数字控制技术降低损耗。在散热方面,通过系统和部件的极致设计及布局实现超强散热能力,可在40℃长期不降额工作,提升散热能力50%。

100kW/3U超高密功率模块

功率模块密度的提升,意味着整机密度的提升,100kW/3U功率模块带来了高功率密度,实现“一柜一兆瓦”,系统效率高达97%,这将引领数据中心供电进入超高密、高效时代。

乘风破浪,聚焦技术攻关:

科研平台+专家力量

UPS5000-H全系产品从开发到正式发布历时两年半,在专家技术座谈环节,该系列产品的研发测试团队讲述了创新背后的故事。谈及开发过程,100K模块技术总工张春涛表示,最大的难点在于如何平衡各种复杂的因素,包括体积、效率、成本、DFX、器件的可服务性等。此外,还需要考虑作为全球化的产品,如何满足各个国家和地区的电压制式、安装场景的要求,进而在系统和架构设计上,确保产品具备良好的灵活性、可适应性等。

超高密模块化UPS全系列产品研发测试团队

开展专家技术座谈会

为实现技术突破,华为搭载2012实验室的平台实力,联合技术骨干、专家力量对难点问题集中攻关,并且优化可靠性测试策略,利用国内沿海、潮湿、低温、干燥和低气压环境五大外场,全面覆盖各种应用场景。

凭借强大的技术实力,华为UPS产品获得了行业和市场的认可,赛迪顾问发布的《2019-2020年中国UPS市场研究年度报告》显示,2019年度,华为UPS产品市场份额位居中国整体市场第一。

本次UPS 全系列新品的发布,是华为持续创新的一个成就,也是一个新的起点。展望未来,华为将继续打造更加极简、绿色、智能、安全的数据中心能源解决方案。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元