富士通展示Dataffinic Computing高速大数据处理原型技术

富士通实验室正在努力满足在处理分析工作负载的大数据系统中加快处理速度的需求。

近日富士通表示,已经开发了一项新技术可以帮助在分布式存储系统中高速处理大数据,并且信息是保存在多个驱动器中的。这项新技术是在开源Ceph分布式存储框架上实现的,富士通认为它可以很好地运行以消除服务器尝试从这些存储系统读取数据时出现的瓶颈。

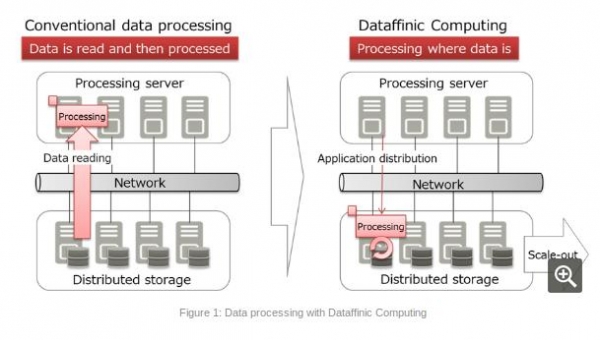

富士通工程师在博客文章中谈到了所谓的“Dataffinic Computing”技术,他表示,存储和服务器之间流动的大量数据是分析系统延迟的主要原因。但是通过在存储中处理这些数据,他们认为这样可以加快速度,因为不需要先移动数据。

Dataffinic Computing通过网络连接多个服务器,同时保持原始存储功能。富士通说,这种方法分解了非结构化视频和日志数据,让所有数据都更容易访问和压缩。

“这意味着分散于分布式存储中的数据可以单独处理,保持访问性能的可扩展性,并提高整体系统性能,”富士通的工程师声称。

富士通的系统还可以预测在分析数据时维护数据所需的存储资源需求。

“存储节点面临各种系统负载以安全地维护数据,包括错误后的自动恢复处理,添加更多存储容量后的数据重新分配处理,以及作为预防性维护一部分的磁盘检查处理,”富士通的工程师写道。“该技术模拟了存储系统中出现的系统负载类型,预测了不久将来所需的资源。基于此,该技术控制数据处理资源及其分配,而不会降低系统存储功能的性能。”

富士通表示,Dataffinic原型系统包括5个存储节点和5个服务器,由一个千兆网络连接。工程师们通过从50GB视频数据中提取出例如人和车等对象来测量其数据处理性能。

工程师表示,Dataffinic系统可以在50秒内处理这些数据,这比使用传统方法处理数据所花费的500秒缩短了10倍。

“这项技术可以实现对爆炸式增加的数据进行可扩展和高效的处理,”富士通工程师这样表示。

Constellation Research分析师Holger Mueller表示,富士通的这项新技术可能很有用处,因为存储对于依赖大数据的下一代软件应用来说至关重要。

Mueller说:“企业需要坚持数据进行时间分析、记录保存和法定监管。因此,存储硬件制造商必须创新,应对必须存储和处理的越来越多的数据。很高兴看到研发投资带来了新的高性能存储选择。”

下一步将是通过商业应用验证该技术。如果运行可靠的话,富士通计划在2019年之前将基于该架构的新产品推向市场。

来源:至顶网服务器频道

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元