ASC18世界超算总决赛清华成功卫冕,黑马上海科大斩获AI大奖

5月9日,2018 ASC世界大学生超级计算机竞赛(ASC18)总决赛在南昌大学落下帷幕,清华大学成功卫冕总冠军,首次入围总决赛的“黑马”上海科技大学一鸣惊人,揽获亚军和e Prize计算挑战奖两项大奖,台湾清华大学获得最高计算性能奖。

2018 ASC世界大学生超级计算机竞赛(ASC18)

ASC18由亚洲超算协会、浪潮集团和南昌大学联合举办,共有全球300余支高校代表队报名,经过预赛选拔有20支队伍晋级总决赛。决赛要求参赛大学生队伍在3000瓦功耗约束下自行设计超算系统,运行优化国际通行基准测试、人工智能机器阅读理解、2017年诺贝尔化学奖冷冻电镜技术的核心应用Relion、美国国家航空航天局(NASA)著名计算流体力学软件CFL3D等前沿科学与工程应用。

上届冠军清华大学代表队在20强队伍中完成赛题数量最多且性能出色,总成绩遥遥领先,成功卫冕。在HPCG基准测试、神秘应用SIESTA、冷冻电镜应用Relion、CFD应用CFL3D多项赛题中均取得佳绩,反映出全面、深刻的超算系统与应用理解能力以及出色的性能优化能力。

清华大学获得ASC18超算竞赛冠军

上海科技大学代表队首次入围ASC总决赛斩获亚军和e Prize计算挑战奖,成为ASC18的最大“黑马”。其在备受关注的人工智能机器阅读理解赛题中,针对模型算法和训练性能提出了自己独特的创新及改进,8小时内完成大规模数据集的并行模型训练,并实现46.46的高预测精度,接近世界前沿先进水平,以此获得e Prize计算挑战大奖。

上海科技大学获得ASC18超算竞赛亚军和e Prize计算挑战奖

台湾清华大学代表队采用浪潮AI超算服务器配置Tesla GPU加速卡构建了先进的异构加速超算系统,并实现了精细功耗控制优化,运行国际通行的HPL基准测试,在3000W功耗约束下实现整体系统42.99万亿次/秒的持续浮点运算性能,大幅刷新了ASC17创下的赛事纪录,获得最高计算性能奖。

台湾清华大学获得ASC18超算竞赛最高计算性能奖

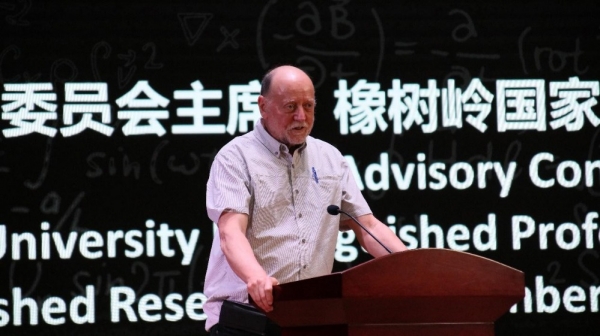

ASC竞赛专家委员会主席、全球最快超级计算机排行榜Top500发起人、美国橡树岭国家实验室及田纳西大学教授杰克·唐加拉(Jack Dongarra)表示:“参与ASC这样的比赛是一件令人激动的事情。我看到学生们花费很多时间、甚至不远万里赶来,每个人面对硬件、软件的问题和挑战都在努力执行任务、解决难题,这真的让人深感鼓舞。希望ASC竞赛能够为所有人带来快乐,不论是现在还是在不久的将来。”

ASC竞赛专家委员会主席、全球最快超级计算机排行榜Top500发起人 杰克·唐加拉(Jack Dongarra)

ASC竞赛发起人、中国工程院院士 王恩东认为,当前超级计算与大数据、云计算和人工智能相互融合、交叉应用的趋势愈发明显,超级计算机将成为未来智能社会的重要基础设施,其发展速度和水平将关乎社会发展、生活改善与文明进步。ASC作为一项全球化的超算竞赛,将在复合型超算精英培养与国际化学术交流上发挥更重要的作用,为智慧计算的发展奠定坚实基础。

ASC竞赛发起人、中国工程院院士 王恩东

ASC 世界大学生超级计算机竞赛(ASC Student Supercomputer Challenge)由中国发起组织,并得到亚洲及欧美相关专家和机构支持,旨在通过大赛平台推动各国及地区间超算青年人才交流和培养,提升超算应用水平和研发能力,发挥超算的科技驱动力,促进科技与产业创新。大赛迄今已连续举行7届,共吸引了全球超过5500名大学生参赛,是目前全球规模最大、参与人数最多的大学生超算赛事。

来源:业界供稿

好文章,需要你的鼓励

奥运级别的努力:首席信息官为2026年AI颠覆做准备

AI颠覆预计将在2026年持续,推动企业适应不断演进的技术并扩大规模。国际奥委会、Moderna和Sportradar的领导者在纽约路透社峰会上分享了他们的AI策略。讨论焦点包括自建AI与购买第三方资源的选择,AI在内部流程优化和外部产品开发中的应用,以及小型模型在日常应用中的潜力。专家建议,企业应将AI建设融入企业文化,以创新而非成本节约为驱动力。

字节跳动发布GAR:让AI能像人类一样精准理解图像任何区域的突破性技术

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

Spotify推出AI播放列表功能让用户掌控推荐算法

Spotify在新西兰测试推出AI提示播放列表功能,用户可通过文字描述需求让AI根据指令和听歌历史生成个性化播放列表。该功能允许用户设置定期刷新,相当于创建可控制算法的每周发现播放列表。这是Spotify赋予用户更多控制权努力的一部分,此前其AI DJ功能也增加了语音提示选项,反映了各平台让用户更好控制算法推荐的趋势。

Inclusion AI推出万亿参数思维模型Ring-1T:首个开源的超大规模推理引擎如何重塑AI思考边界

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。

为AI+而生,海辰储能发布全球首款锂钠协同AIDC全时长储能解决方案

长时储能开启智慧未来:海辰储能生态日全球首发三大新品

Arm 借助融合型 AI 数据中心,重塑计算格局

奥运级别的努力:首席信息官为2026年AI颠覆做准备

Spotify推出AI播放列表功能让用户掌控推荐算法

Adobe押注生成式AI获得回报,年度营收创历史新高

OpenAI与迪士尼达成十亿美元合作协议,米老鼠和漫威角色进入Sora

甲骨文150亿美元数据中心投资导致股价下跌

Spoor鸟类监测AI软件需求飞速增长

制药行业AI数据质量危机:垃圾进垃圾出的隐患

Harness获得2.4亿美元融资,估值达55亿美元,专注自动化AI编码后的开发流程

英伟达CEO黄仁勋独家专访:万亿美元押注AI工厂将成为新时代计算机