Facebook公布Big Basin Volta计划 为OCP贡献服务器设计

为推动Open Compute Project(OCP)项目,Facebook本周公布了最新名为Big Basin v2的GPU服务器设计。

OCP最早是由一群致力于通过开发共享知识产权来打造高效服务器、存储和数据中心的工程师社区建立起来的。诺基亚、英特尔、思科、联想、苹果和谷歌等公司都是OCP的成员。

Big Basin v2的结构与之前的Big Basin基本相同,但升级采用了Nvidia最新八款Tesla V100图形卡。Tioga Pass CPU单元被用于头节点,同时在CPU与GPU之间数据传输的PCIe带宽也翻了一番。

Facebook在一篇博客文章中表示,在增加了OCP网卡的带宽之后,单GPU性能与之前的Big Basin设计相比增加了66%。

这意味着研究人员和工程师可以构建更大规模的机器学习模型,更有效地进行训练和部署。 Facebook通过监控用户的互动,来预测特定用户将看到什么内容。

Facebook将机器学习用于新闻推送排名、个性化广告、搜索、语言翻译、语音识别、甚至是在上传的图片中为你的朋友推荐正确的标签。

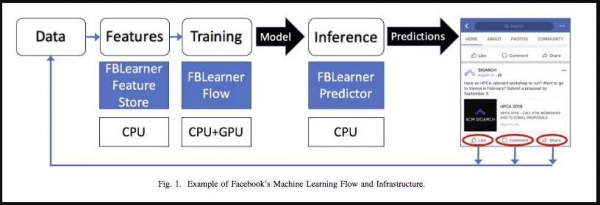

大多数机器学习是通过Facebook的AI软件平台FBLearner运行的。

Facebook机器学习基础设施的数据通道。图片来源:Facebook

它分为不同的组件:Feature Store、Flow和Predictor。

Facebook解释说:“Feature Store根据数据和数据流生成特征并将其提供给FBLearner Flow。Flow则基于生成的特征来构建、训练和评估机器学习模型。”

“然后通过FBLearner Predictor把最终的训练模型部署到生产环境中。Predictor会对实时流量进行推断或预测。例如,它可以预测某人最关心的故事、帖子或照片。”

我们很感兴趣看看用于支持大型企业人工智能和机器学习的硬件蓝图是怎样的。这对Facebook来说意义重大,因为它实际上并不真正地参与AI Cloud竞争。谷歌或亚马逊等其他技术巨头可能不会乐于采用它的系统。

“我们相信,开放合作有助于促进未来设计的创新,并使我们能够构建更复杂的人工智能系统,最终支持沉浸式的Facebook体验。”

好文章,需要你的鼓励

亚马逊推出Alexa网页版:生成式AI助手的新选择

亚马逊在CES期间宣布推出Alexa.com网站,用户可像使用其他AI聊天机器人一样与Alexa交互。经过数月早期体验,Alexa+已获得数千万用户。新网站支持语音和文本交互,需登录使用以确保跨设备功能连续性。76%的Alexa+交互为独特任务,包括智能家居控制和第三方集成。Alexa+兼容七年来的设备,正式版将收费每月20美元或包含在Prime会员中。

UCSD团队打造终极仿真世界:让AI智能体在虚拟城市中自立更生的惊人实验

SimWorld是由UCSD等多所顶尖院校联合开发的革命性AI仿真平台,基于虚幻引擎5构建了具备真实物理规律的虚拟城市环境。该平台支持无限扩展的程序化世界生成和自然语言交互,让AI智能体能够在复杂环境中学会生存、合作和竞争,为通用人工智能的发展提供了前所未有的训练平台。

Plaud推出可穿戴AI记录设备NotePin S,CES 2026记者新利器

AI笔记公司Plaud在CES 2026推出新款可穿戴设备NotePin S,可夹在衣领、戴在手腕或挂在脖子上记录对话。该设备通过蓝牙连接手机,配备双麦克风,录制范围约3米,支持一键高亮标记重要时刻。同时发布的还有Plaud Desktop桌面AI记录工具,可原生捕获线上会议内容,无需机器人加入通话。两款产品将所有笔记、会议和对话整合到统一平台管理。

浙江大学团队提出C2DLM:让AI推理更像人类思维的全新语言模型

浙江大学联合华为提出C2DLM,这是一种因果概念引导的扩散语言模型,通过自动提取因果关系并融入注意力机制来增强AI推理能力。相比传统方法,C2DLM在推理任务上平均提升1.31%-12%,训练效率提高3.2倍,为解决语言模型推理能力不足开辟了新路径。

亚马逊推出Alexa网页版:生成式AI助手的新选择

Plaud推出可穿戴AI记录设备NotePin S,CES 2026记者新利器

机器人初创公司推出现实版瓦力机器人及其他伴侣产品

VisIC宣布完成2,600万美元B轮融资

CES 2026 | AMD扩张“边缘统治力” “芯片级异构”塑造汽车、工业边缘应用“新法则”

CES 2026 | NVIDIA新风向: Rubin平台面市 ,系统级“AI工厂”成型,物理AI加速落地

英伟达Vera-Rubin平台推出前六月已淘汰现有AI硬件

英特尔推出首批18A工艺制程的Core Ultra处理器

Rokid在CES 2026推出无屏AI智能眼镜

英伟达物理AI模型为新一代机器人铺路

微软发布 GitHub Copilot 的 C++ 代码编辑工具

至顶AI实验室硬核评测:戴尔Precision 5690移动工作站,部署DeepSeek+LobeChat打造个人超级智能体

戴尔新服务器采用优化冷却和Open Compute Project

OCP China Day 2023:数据中心基础设施创新分论坛在京举行

OCP China Day 2023:五大社区齐聚 加速开源开放创新与落地

OCP China Day 2023开幕在即 | AIGC引爆巨量算力需求,揭秘数据中心破局之道

META PLATFORMS迎来新成员:专为驱动人工智能而生

OCP发布Caliptra新硬件信任标准 强化边缘和机密计算安全性

更高效更快捷 OCP China Day 2022开放计算创新论坛举行

针对OCP中数据存储面临的挑战,西部数据给出这样的答案

OCP China Day 2022:开放计算,推动数据中心可持续发展

希捷亮相OCP China Day 2022,与生态伙伴共话绿色存储之道