Nvidia与Accenture合作率先推出定制的Llama大型语言模型

埃森哲近日宣布推出基于Nvidia新AI Foundry服务开发的Accenture AI Refinery框架。该产品旨在使客户能够使用 Llama 3.1 模型构建定制的大型语言模型,使企业能够使用自己的数据和流程完善和个性化这些模型,以创建特定领域的生成式 AI 解决方案。

生成式AI走向Nvidia AI Foundry的旅程

在一次简报会上,Nvidia公司AI软件副总裁Kari Briski表示,她经常被问及生成式AI相关的问题。

“这是一段旅程,是的,生成式AI是一项巨大的投资。企业会问,‘我们为什么要这样做?用例是什么?’当你想到员工生产力时,你是否希望自己一天有更多的时间?我知道我会的。也许如果有10个人,你可以完成更多的事情。这就是生成式AI的用武之地——自动执行重复、平凡的任务,例如总结、最佳实践和后续步骤。”

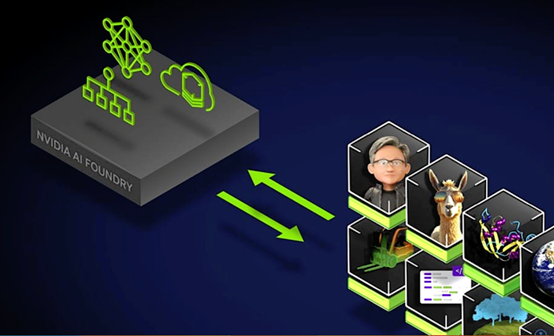

AI Foundry:全面的基础设施

“Nvidia AI Foundry是一项服务,使企业能够使用加速计算和软件工具,结合我们的专业知识来创建和部署可以为企业生成式AI应用增强的自定义模型,”Brisk说。

AI Foundry平台提供了用于开发和部署自定义AI模型的基础设施,包括:

- 基础模型:一套Nvidia和社区模型,包括Llama 3.1。

- 加速计算:DGX Cloud提供可扩展的计算资源,这对于大型AI项目来说至关重要。

- 专家支持:Nvidia AI Enterprise的专家协助开发、微调和部署AI模型。

- 合作伙伴生态系统:与埃森哲等合作伙伴的合作,为AI驱动的转型项目提供咨询服务和解决方案。

Brisk表示,一旦企业定制了模型,就必须对其进行评估。她指出,这正是一些客户陷入困境的地方。她提到了她从客户那里听到的一些话:“‘我的模型做得怎么样?我只是定制了它。它能做我需要的事情吗?’因此,NeMo为客户提供了多种评估方式,除了学术基准,你还可以上传自己的自定义评估基准,可以连接到第三方人工评估者生态系统,还可以使用大型语言模型来进行评判。”

行业采用

正如Brisk在简报中指出的那样,有几家公司正在使用AI Foundry,包括Amdocs、Capital One和ServiceNow。据Nvidia称,这三家厂商正在将AI Foundry集成到他们的工作流程中,而且他们通过开发结合行业特定知识的定制模型获得了竞争优势。

Nvidia NIM的优势

Nvidia的NIM具有Briski提及的一些独特优势。

她解释说:“NIM是一个通过标准API访问的定制模型和容器,这是我们多年工作和研究的成果。”她在Nvidia工作了八年时间,期间Nvidia也一直在研究它。

“它是基于云原生堆栈的,可以在任何GPU上开箱即用,其中涵盖了我们1亿多台Nvidia GPU的安装基数。有了NIM,你就可以非常快速地定制和添加模型。”

她补充说,NIM现在支持Llama 3.1,包括Llama 3.1 8B NIM(单GPU大型语言模型)、Llama 3.1 70B NIM(用于高精度生成)和Llama 3.1 405B NIM(用于合成数据生成)。

部署定制的大型语言模型

此外,埃森哲宣布与Nvidia合作开发AI Refinery框架,该框架是运行在AI Foundry上的。埃森哲表示,该框架推动了企业级AI领域的发展。该框架集成在埃森哲的基础模型服务中,承诺帮助企业开发和部署根据其需求量身定制的大型语言模型。据两家公司称,这个框架包括了四个关键要素:

- 领域节点定制和培训:这使企业能够使用自己的数据和流程来完善大型语言模型,从而提高模型对特定业务需求的相关性和价值。定制部门是运行在AI Foundry上的,让模型训练变得强大而高效。

- Switchboard Platform:使用户能够根据特定的业务环境或标准(例如成本和准确性)选择和组合模型。

- Enterprise Cognitive Brain:该组件会扫描和矢量化企业数据和知识,创建一个企业范围的索引,以增强生成式AI系统的能力。

- 代理架构:该架构旨在使AI系统能够自主运行,支持负责任的AI行为,同时最大限度地减少人工监督。

战略重要性和影响

埃森哲的AI Refinery框架有机会改变企业职能,从营销开始,然后扩展到其他领域,能够快速创建和部署针对特定业务需求的生成式AI应用,彰显了埃森哲对创新和转型的承诺。在向客户提供框架之前,埃森哲内部应用了该框架,展示了它所看到的潜力。

重塑企业

埃森哲董事长兼首席执行官Julie Sweet在公告中强调了生成式AI在重塑企业方面的变革潜力,强调了部署由定制模型驱动的应用以满足业务优先级和推动全行业创新的重要性。

此外,Nvidia公司创始人、首席执行官黄仁勋指出,埃森哲的AI Refinery将提供必要的专业知识和资源,帮助企业创建定制的Llama大型语言模型。

最后的一些想法

埃森哲推出的AI Refinery框架可能对企业采用和部署生成式AI至关重要。通过采用Briski在简报中大加赞赏的Llama 3.1模型和AI Foundry的功能,埃森哲使企业能够创建高度定制且有效的AI解决方案。

随着企业继续探索生成式AI的潜力,埃森哲AI Refinery等框架将在实现定制且有效的AI解决方案方面发挥关键的作用。

埃森哲与Nvidia之间的合作有望推动AI技术的进一步发展,为企业提供增长和创新的途径,也强调了所有AI道路都通向Nvidia。

好文章,需要你的鼓励

加拿大保险公司Manulife如何利用AI赋能销售和呼叫中心代理

Manulife公司的AI战略以惠及多个市场的关键用例为中心,其中一个主要重点是销售代理支持。随着代理的客户组合不断增长,他们越来越难以跟踪个人需求和偏好。

为替代VMware做准备,Veeam向XCP-NG开放支持测试

数据管理供应商Veeam刚刚发布了针对开源VMware替代方案Proxmox的软件版本,同时开发出一套原型工具来顶替另一款虚拟化平台,即基于Xen Server的分叉XCP-NG。

上海AI Lab提出TimeSuite:解锁MLLM长视频理解的潜力!

多模态大型语言模型(MLLMs)通过遵循一般的人类指令来解释视觉内容,已经展示了令人印象深刻的视频理解性能。然而,这些MLLMs在

雷军公布小米汽车纽北成绩:6分46秒874!登顶“纽北全球最速四门车”

蚂蚁数科 CTO 王维:更好的通用 AGI 仍在路上,AI 亟待提升专业性和可信性

2024年中国IT用户满意度调研结果公布

加拿大保险公司Manulife如何利用AI赋能销售和呼叫中心代理

Gartner发布2024年中国安全技术成熟度曲线

为替代VMware做准备,Veeam向XCP-NG开放支持测试

微软“安全未来倡议”:全面守护数字世界

深度剖析:聊聊英特尔与AMD各自不同的CPU整合思路

上海AI Lab提出TimeSuite:解锁MLLM长视频理解的潜力!

高通重磅发布!最新骁龙至尊版汽车平台亮相及战略重点

蚂蚁数科在港加注RWA业务, “两链一桥”平台亮相金融科技周

不急于求成的雷鸟创新,想造出“年轻人的第一台AR眼镜”

NVIDIA宣布向OCP贡献Blackwell GPU平台设计

肯睿Cloudera发布附带嵌入式NVIDIA NIM微服务的AI推理服务

视觉能力媲美OpenAI,Meta发布Llama 3.2

市场预测:到2032年AI服务器市场规模将突破1800亿美金

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示深圳站圆满收官

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示南京站圆满收官

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示银川站圆满收官

分析:NVIDIA第二季度财报再次超出预期背后的新问题

NVLink和NVSwitch是Nvidia在AI战争中的秘密武器

Nvidia CEO黄仁勋就AI的未来发表六项大胆声明