英伟达AI Foundry与NIM:巨大竞争优势由此显现

英伟达已经充实了完整的软件技术栈,旨在简化面向企业客户的定制模型开发与部署流程。这是否代表着AI Nervana目标的实现?AMD和英特尔又该如何与之抗衡?

为了推动企业客户拥抱AI,其准入门槛与经济效益必须进一步优化。英伟达为此重新发布了AI Foundry项目,旨在帮助企业适应并采用AI以满足自身业务需求,同时摆脱从头开始的复杂步骤以及数额可观的资金投入。

这个时机选得恰到好处,目前投资者越来越担心企业可能很难从AI投资当中获得良好回报。如果没有企业采用,AI技术将遭遇失败,我们也将再次身陷AI寒冬。为了驳斥这种观点,英伟达计划在下一次财报电话会议上分享关于企业投资回报率的故事。而此番公布的AI Foundry加NIM组合,也许会成为大多数企业后续前进的标准路线。虽然这个故事中的许多组件来自开源社区,但其只能在英伟达GPU上运行。而且据我们所知,还没有哪家芯片厂商拥有与NIM或者AI Foundry相近的方案选项。

AI Foundry究竟是什么?

英伟达AI Foundry是一整套软件、模型与专家服务的组合,旨在帮助企业轻松起步并完成自己的AI探索之旅。那这样的定位是否会让英伟达与IBM和埃森哲等生态系统咨询合作伙伴发生冲突?毕竟埃森哲一直在使用英伟达AI Foundry改造其内部企业职能,并借助自己学习到的知识建立起了Accenture AI Refinery来帮助客户完成同样的探索。此外,德勤也正在摸索类似的前进道路。

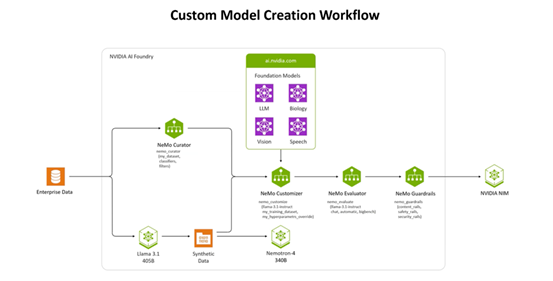

自定义模型的创建工作流程。

根据英伟达就Foundry项目发表的博文介绍,“如同台积电根据其他厂商的设计图制造芯片一样,英伟达AI Foundry的定位也是为其他公司提供基础设施与工具以开发并定制AI模型——具体组件包括DGX Cloud、基础模型、英伟达NeMo软件、英伟达专业知识以及生态系统工具和支持。”

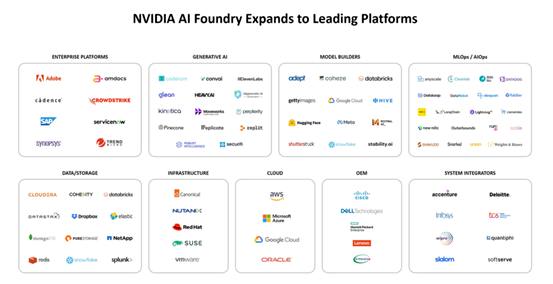

英伟达Foundry最初于2023年年底推出,当时主要面向微软Azure托管AI。在此之后,英伟达招募了数十家合作伙伴帮助其交付这套平台,包括亚马逊云科技、Google Cloud和Oracle Cloud,以及数十家生成式AI公司、模型开发商、集成商以及OEM伙伴。

随着新合作伙伴的涌现,英伟达AI Foundry的生态系统也迎来了蓬勃发展。

英伟达AI Foundry服务汇聚了打造特定数据集或者企业定制化模型所必需的三大要素——英伟达AI基础模型集合、英伟达NeMo框架及工具,以及英伟达DGX Cloud AI超级计算服务。三者合一,将为企业提供一套用于构建定制化生成式AI模型的端到端解决方案。

但说到这里,很多朋友可能想到了RAG——这不就是检索增强生成的作用吗?没错,RAG确实能够很好地将企业中的特定数据添加到大模型当中,但英伟达表示,Foundry所生成的定制模型在准确度方面要比简单挂载RAG的方案高出十个百分点。这10%的差异,足以决定一套模型到底足够投入生产,还是被彻底扔进垃圾堆。

还有NIM

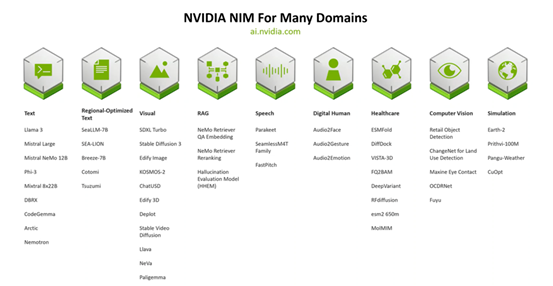

NIM提供的则是必要构建块,能够大大简化并扩展Foundry能够发挥作用的领域范围。英伟达分享了其面向各个领域打造的50多个NIM。有些朋友可能不太熟悉,NIM是指英伟达NIM Factory构建的容器化推理处理微服务,而拥有AI许可证的企业客户还能访问ai.nvidia.com上不断增长的NIM资源库。

英伟达NIM正在迅速增长,涵盖了大多数主要的数据和AI模式。

就在Foundry发布的同时,恰逢Meta推出了自己的开源大模型Llama 3.1 405B——这是首个能够与OpenAI、谷歌乃至其他厂商的顶尖闭源AI模型相媲美的开放模型,在常识、可操纵性、数学、工具使用以及多语言翻译等方面均具备最先进的能力。Meta认为最新一代的Llama将激发新的应用与建模范式,包括用于改进和训练较小模型的合成数据生成,以及模型蒸馏功能。英伟达Foundry还支持Nemotron、谷歌DeepMind的CodeGemma、CodeLlama、谷歌DeepMind的Gemma、Mistral、Mixtral、Phi-3、StarCoder2等项目。

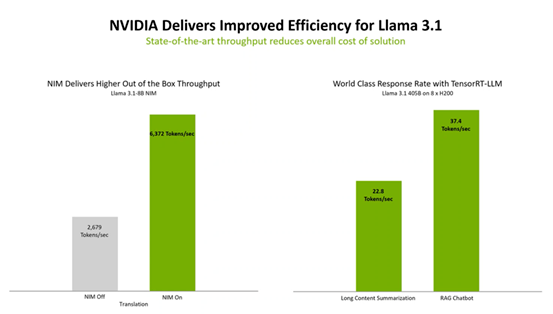

借此良机,英伟达表示其经过优化的NIM能够提高Llama 3.1等模型的性能。英伟达TensorRT-LLM等推理解决方案则可提高Llama 3.1模型的效率,从而最大限度降低延迟并尽可能提高吞吐量,帮助企业更快生成token,最终降低在生产环境下运行大模型的总成本。

相较于Meta公布的Llama 3.1,NIM在同等硬件上能够实现更强的性能。

英伟达此次还发布了四项新的NeMo Retriever NIM微服务,使得企业能够扩展至“代理AI”工作流程(即AI应用程序在最少干预或者监督之下准确运行),同时提供最高精度的检索增强生成(RAG)功能。这些新的NeMo Retriever嵌入和重新排名的NIM微服务目前已经全面开放:

- NV-EmbedQA-E5-v5是一种流行的社区基础嵌入模型,针对文本问答检索进行了优化。

- NV-EmbedQA-Mistral7B-v2是一种流行的多语言社区基础模型,针对文本嵌入进行了微调,能够实现高精度问答功能。

- Snowflake-Arctic-Embed-L是一种经过优化的社区模型。

- NV-RerankQA-Mistral4B-v3是一种流行的社区基础模型,针对文本重新排名进行了微调,旨在实现高精度问答能力。

英伟达在相关博文当中解释道,“NeMo Retriever兼具双方面优势,既通过使用嵌入NIM来广泛进行数据检索,同时又使用重新排序的NIM以修剪结果的相关性。NeMo Retriever能够帮助开发人员构建起相应管线,确保为自己的企业提供最有用、最准确的结果。”

NIM应用示例:医疗保健聊天机器人

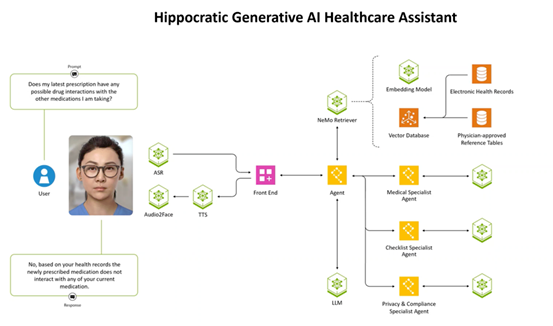

这里来看相关示例。假设我们想要构建一款数字助手来帮助患者获取个性化信息。英伟达展示了如何将3个代理智能体加9个NIM来构建一款助手应用程序。整个效果与Nervana的目标非常接近,且远远走出了竞争对手所能交付的一切实际产品。

可以使用一组NIM来创建医疗保健数字助手。

总结

虽然竞争对手仍在努力提高加速器的性能和连接能力,但英伟达已经开辟出支持AI采用的软件新赛道。目前来看,市面上似乎并不存在NIM或者Foundry项目的直接竞争对手。当然,Transformer Engine和TensorRT-LLM也同样独树一帜,相较于不具备此类功能的GPU可实现2到4倍的性能增益。

随着企业努力适应并采用匹配其业务和应用程序的定制化模型,英伟达正在开拓一条通往企业级AI的新捷径。

至于定价问题,NIM已经包含在各GPU的Enterprise AI许可证之内;而Foundry则须根据客户的实际情况单独定价,不在Enterprise AI的服务范围。

好文章,需要你的鼓励

CoreWeave LOTA技术实现对象数据高速全球传输

CoreWeave发布AI对象存储服务,采用本地对象传输加速器(LOTA)技术,可在全球范围内高速传输对象数据,无出口费用或请求交易分层费用。该技术通过智能代理在每个GPU节点上加速数据传输,提供高达每GPU 7 GBps的吞吐量,可扩展至数十万个GPU。服务采用三层自动定价模式,为客户的AI工作负载降低超过75%的存储成本。

IDEA研究院等机构联手打造智能AI助手:让机器像人类一样思考和学习的突破性技术

IDEA研究院等机构联合开发了ToG-3智能推理系统,通过多智能体协作和双重进化机制,让AI能像人类专家团队一样动态思考和学习。该系统在复杂推理任务上表现优异,能用较小模型达到卓越性能,为AI技术的普及应用开辟了新路径,在教育、医疗、商业决策等领域具有广阔应用前景。

谷歌DeepMind与CFS合作开发核聚变等离子体AI控制系统

谷歌DeepMind与核聚变初创公司CFS合作,运用先进AI模型帮助管理和改进即将发布的Sparc反应堆。DeepMind开发了名为Torax的专用软件来模拟等离子体,结合强化学习等AI技术寻找最佳核聚变控制方式。核聚变被视为清洁能源的圣杯,可提供几乎无限的零碳排放能源。谷歌已投资CFS并承诺购买其200兆瓦电力。

AI训练新突破:上海AI实验室让大模型自己当老师,推理和判断能力同步飞跃

上海人工智能实验室提出SPARK框架,创新性地让AI模型在学习推理的同时学会自我评判,通过回收训练数据建立策略与奖励的协同进化机制。实验显示,该方法在数学推理、奖励评判和通用能力上分别提升9.7%、12.1%和1.5%,且训练成本仅为传统方法的一半,展现出强大的泛化能力和自我反思能力。

Littelfuse推出首款具有SPDT和长行程且兼容回流焊接的发光轻触开关

至顶科技助力AI创业者,在HICOOL峰会探索“如何用AI赚到第一桶金”

CoreWeave LOTA技术实现对象数据高速全球传输

谷歌DeepMind与CFS合作开发核聚变等离子体AI控制系统

微软为Windows 11推出全新Copilot自动化功能

苹果研究人员探索AI如何预测Bug、编写测试并修复代码

刚果称全球最大水电站可为AI数据中心供电

HPE Alletra存储业务获得战略重点关注

谷歌DeepMind与核聚变初创公司合作的真实原因

Omdia预测:超大规模云市场销售额2030年将达1630亿美元

Oracle全面押注AI,用户仍在摸索应用路径

Aramex与AWS携手推进全球物流数字化转型

最热门的 AI 模型:它们的功能和使用方法

这款古怪的 AI 智能手机可以创建你的数字分身

Faireez 获 750 万美元融资,为租赁市场提供 AI 驱动的酒店式管家服务

Broadcom 大获全胜:70% 大型 VMware 客户购买其最全面解决方案

Peer 获得1050万美元元宇宙引擎投资,推出3D个人星球功能

获 3000 万美元融资,Crogl 发布面向安全分析师的全新 AI "钢铁侠战衣"

Turing 获得 1.11 亿美元融资,估值达到 22 亿美元,为 OpenAI 等大语言模型公司提供关键代码支持

Tavus 推出系列 AI 模型,实现实时人脸交互技术突破

Welevel 获得 570 万美元融资,革新程序化游戏开发

AI 驱动的卓越运营:企业如何通过人人可及的流程智能提升成功